当我们开始做网站的时候,很多seo优化细节要注意,就像今天聊的Robots协议,看似就一个txt文档,其实对于网站优化和收录有很大影响。

因为我们搭建一个全新网站的时候,网站根目录是没有Robots协议文档的,需要站长自行去添加,很多站长不知道或不太关心Robots协议的撰写,有的甚至设置错误Robots协议导致蜘蛛屏蔽了蜘蛛。

直到某一天发现我们的网站一直不收录,后面排查原因的时候才发现是Robots协议没设置好,无疑浪费了很多很多的时间,所以,刚开始建站的时候一定要注意这些问题。

比如很多站长网站刚运营的时候,没有设置好Robots协议,出现以下问题:

1.禁止了蜘蛛抓取,导致网站迟迟不收录。

2.没有禁止动态页面抓取,产生大量的重复页面。

3.后台地址,空栏目页没有禁止抓取,产生大量低质量页面,影响网站权重判定。

Robots协议协议是什么?以及设置Robots协议有什么作用。

1.Robots协议协议是什么?

Robots协议是引导搜索引擎蜘蛛爬行的标准,每当有蜘蛛进入我们网站的时候首先爬取的就是Robots.txt文件,如果网站根目录下没有Robots协议文件,那么蜘蛛就由自己的喜好开始爬取,完全自由自在,没有任何拘束。

如果有Robots协议文件,那么搜索引擎蜘蛛就会按照Robots协议协议来爬取,不会爬取你禁止爬取的内容,你可以理解成Robots协议是搜索引擎蜘蛛爬行的引导者。

当然,也有很多蜘蛛不遵循Robots协议协议,就好像头条搜索的蜘蛛开始爬取内容的时候,那段时间听到很多站长声讨头条,完全不按照Robots协议爬取,甚至直接把服务器爬瘫痪了。

现在淘宝,头条,公众号等等平台,为了打造闭环生态,所以都拒绝了部分蜘蛛的爬取,这也是为什么我们用百度搜索,查找不到淘宝的商品,公众号的文章,这都是设置了Robots协议文件的关系。

2.Robots.txt样式

通常存放在网站跟目录,你可以登录FTP查看站点跟目录下是否存在这个文件,如果没有可以自行创建,当Robotx.txt为空的时候,它代表不为网站做任何的抓取限制。

User-agent:

是定义搜索引擎的,指定搜索引擎的爬取程序,如果想定义所有搜索引擎请用 * ,

记住他不能单独使用,他要配合前面两个语法使用(随便一个就行了)

Disallow:

是禁止搜索引擎抓取的路径。注意: / 表示根目录 (代表网站所有目录)。Disallow 禁止搜索引擎把我们的网页放出来,就是我们不允许搜索引擎收录,请记住是不允许搜索引擎收录,并不代表他不能爬取了。这是两个概念,他还是能爬的,他不是命令,他只是协议

Allow:

是允许的意思,但需要注意: 他的使用一般都是结合 Disallow 他不能单独出现,意思是禁止爬取那个内容,加上 Allow 后意思是,除了可以爬取这个外其余的都禁止!

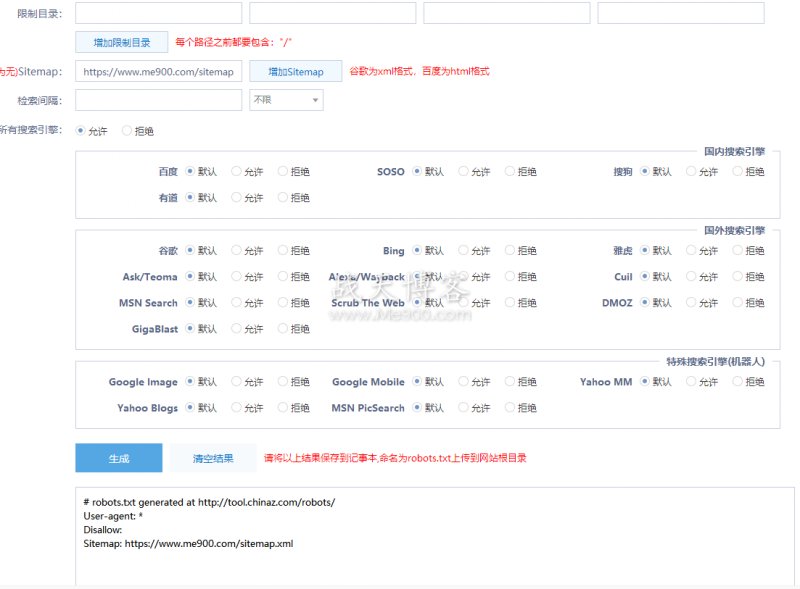

如果不清楚该怎么写的话,可以借助站长工具,可以一键生成Robots协议,并且检测出来,直白的告诉你每个指令是什么意思。

对于很多推广项目,放有大量链接的站长,一般都采用的go页面跳转,那么,我们在设置robots协议的时候,直接可以屏蔽蜘蛛都go页面的抓取。

类似网站后台,带参数的动态链接,我们都是可以设置不被搜索引擎抓取。

根据不同的站,有不同的写法,大家可以多多研究摸索~

关注公众号:lmcjl_com(长按复制)

本文来自作者:展天,不代表懒猪博客立场!

转载请注明:https://my.lmcjl.com/1991.html

本文链接:https://my.lmcjl.com/post/5335.html

4 评论