NSX ALB + Harbor + OpenShift 4.8 UPI安装配置实验笔记系列目录

目录

1 在vCenter里准备虚机

1.1 为master和worker主机配置反关联规则

2 安装bootstrap

2.1 安装bootstrap

2.2 在operator主机ssh进bootstrap

2.3 在operator主机准备Kubeconfig文件

2.4 检查Master主机的Registry库配置是否正确

2.5 在Operator上查看安装完成前日志

2.6 在Operator上查看整体安装日志

2.7 检查AVI中bootstrap的服务是否已启动

3 安装master

3.1 安装master节点

3.2 检查Master主机的Registry库配置是否正确

3.3 在Operator主机上查看安装日志

3.4 检查master集群状态

3.5 检查AVI中master集群的服务是否已启动

4 部署worker节点

4.1 安装worker节点

4.2 检查Master主机的Registry库配置是否正确

4.3 检查待处理的CSR,并批准所有CSR请求

4.4 检查集群状态

5 获取集群console地址及kubeadmin密码

注:使用RHCOS安装OCP集群,则不需要配置yum源,如果使用RHEL或是CentOS来安装OCP则需要配置Yum源。为了简化操作,此处使用RHCOS

1 在vCenter里准备虚机

在vCenter里按之前规划准备虚机,并挂载RHCOS的ISO文件。OS类型为RHEL8 64bit。

1.1 为master和worker主机配置反关联规则

1). 在vCenter中选中OCP所有的Cluster->配置->虚拟机/主机规则->添加

2). 分别为OCP Master和Worker创建反关联规则,输入对应的名称如“OCP-Master_Anti-Affinity”,类型选择“单独的虚拟机”,然后点击“添加”,将对应的虚机加入后确定。

2 安装bootstrap

2.1 安装bootstrap

1). 启动bootstrap虚机,自RHCOS ISO引导进入系统,并打开Web console;

2). 查看本地磁盘号,并记录:

fdisk -l

3). 查看本地网卡连接:

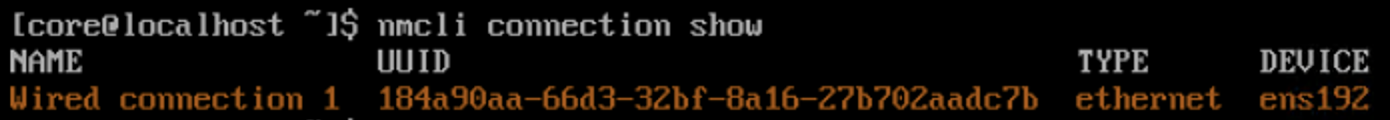

nmcli connection show

4). 配置网络信息,以便能与operator主机通讯;

可使用nmcli或是nmtui配置,其中nmtui为图形界面,可按提示操作即可,如下图示例(配置完后,记得需要激活一下):

nmcli配置:

nmcli con mod "Wired connection 1" ipv4.method manual ipv4.addresses 192.168.170.50/24 ipv4.gateway 192.168.170.1 ipv4.dns 192.168.110.10 connection.autoconnet yes ipv4.dns-search "ocp.corp.tanzu"5). 重启NetworkManager服务,使配置生效,然后进行测试:

sudo systemctl start NetworkManager

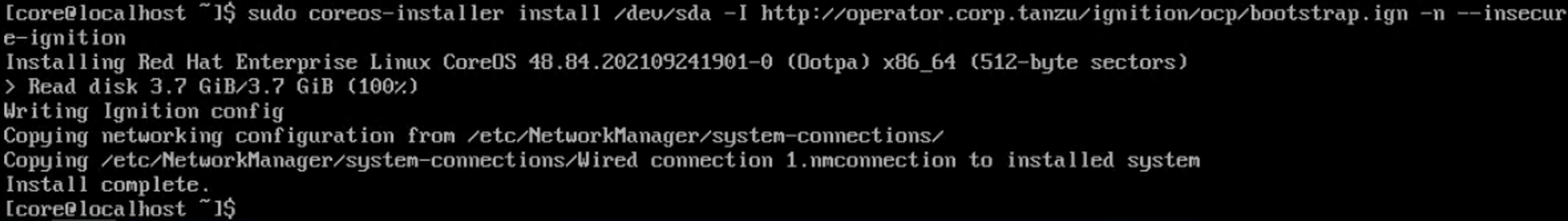

6). 通过Operator上的ignition进行bootstrap的安装

sudo coreos-install install /dev/sda -I http://operator.corp.tanzu/ignition/ocp/bootstrap.ign -n --insecure-ignition此处“-n等同于--copy-network”将上面配置的IP配置信息带入安装配置中。

7). 等待安装完成后重启主机

reboot2.2 在operator主机ssh进bootstrap

rm -rf ~/.ssh/known_hosts

ssh -i ${SSH_PRI_FILE} core@bootstrap.${OCP_CLUSTER_ID}.${DOMAIN}2.3 在operator主机准备Kubeconfig文件

方式一:将kubeconfig文件copy至操作用户目录下:

mkdir ~/.kube

cp ${IGN_PATH}/auth/kubeconfig ~/.kube/config方式二:声明变量:

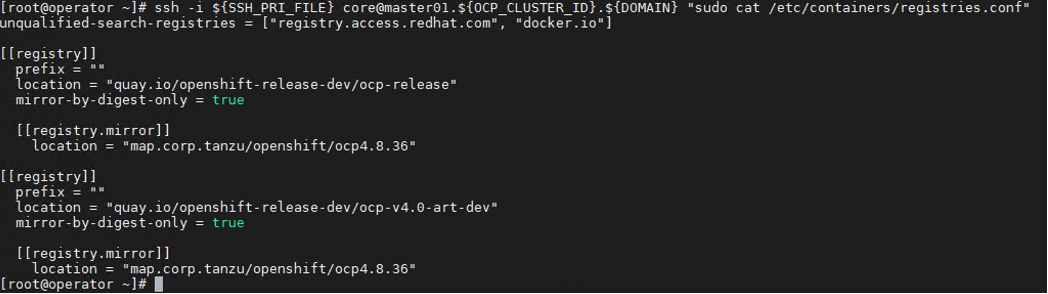

export KUBECONFIG=${IGN_PATH}/auth/kubeconfig2.4 检查Master主机的Registry库配置是否正确

ssh -i ${SSH_PRI_FILE} core@bootstrap.${OCP_CLUSTER_ID}.${DOMAIN} "sudo cat /etc/containers/registries.conf"2.5 在Operator上查看安装完成前日志

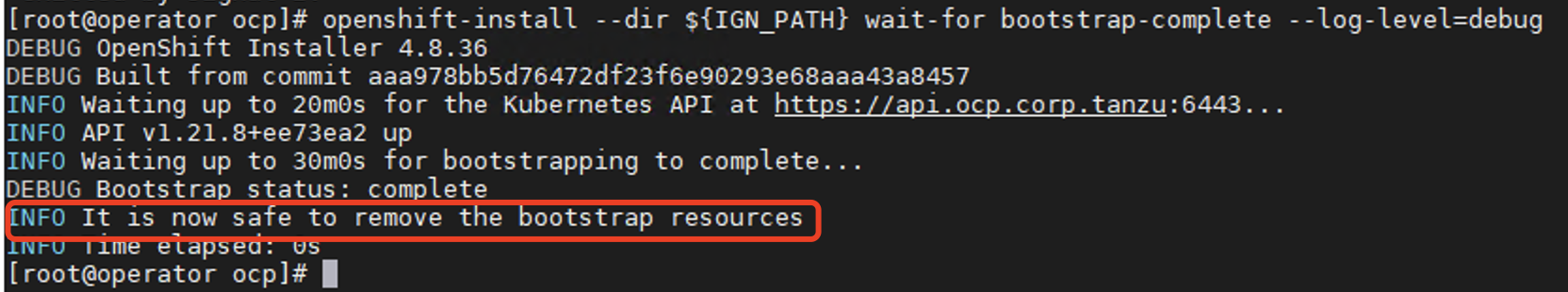

openshift-install --dir ${IGN_PATH} wait-for bootstrap-complete --log-level=debug2.6 在Operator上查看整体安装日志

openshift-install --dir ${IGN_PATH} wait-for install-complete2.7 检查NSX ALB(AVI)中bootstrap的服务是否已启动

在NSX ALB管理界面的Application->Dashboard中找到对应的OCP API Service,然后展看,看其Pool的活动状态,红色为非活动状态:

3 安装master

3.1 安装master节点

与Bootstrap节点安装步骤相同,但注意ignition文件使用“master.ign”

1). 启动master的三台虚机,自RHCOS ISO引导进入系统,并打开Web console;

2). 查看本地磁盘号,并记录:

fdisk -l3). 查看本地网卡连接:

nmcli connection show4). 配置网络信息,以便能与operator主机通讯;

可使用nmcli或是nmtui配置,其中nmtui为图形界面,可按提示操作即可,配置完后,记得需要激活一下。

此处记录nmcli配置:

nmcli con mod "Wired connection 1" ipv4.method manual ipv4.addresses 192.168.170.51/24 ipv4.gateway 192.168.170.1 ipv4.dns 192.168.110.10 connection.autoconnet yes ipv4.dns-search "ocp.corp.tanzu"5). 重启NetworkManager服务,使配置生效,然后进行测试:

sudo systemctl start NetworkManager6). 通过Operator上的ignition进行bootstrap的安装

sudo coreos-install install /dev/sda -I http://operator.corp.tanzu/ignition/ocp/master.ign -n --insecure-ignition此处“-n等同于--copy-network”将上面配置的IP配置信息带入安装配置中。

7). 等待安装完成后重启主机

reboot3.2 检查Master主机的Registry库配置是否正确

ssh -i ${SSH_PRI_FILE} core@master01.${OCP_CLUSTER_ID}.${DOMAIN} "sudo cat /etc/containers/registries.conf"

3.3 在Operator主机上查看安装日志

查看master的不同安装阶段信息:

ssh -i ${SSH_PRI_FILE} core@bootstrap.${OCP_CLUSTER_ID}.${DOMAIN} "journalctl -b -f -u bootkube.service"查看安装日志信息:

openshift-install --dir ${IGN_PATH} wait-for bootstrap-complete --log-level=debug或者使用如下命令:

tail -f ${IGN_PATH}/.openshift_install.log当log提示“INFO It is now safe to remove the bootstrap resources”后,bootstrap主机即可关机或移除,如下图:

3.4 检查master集群状态

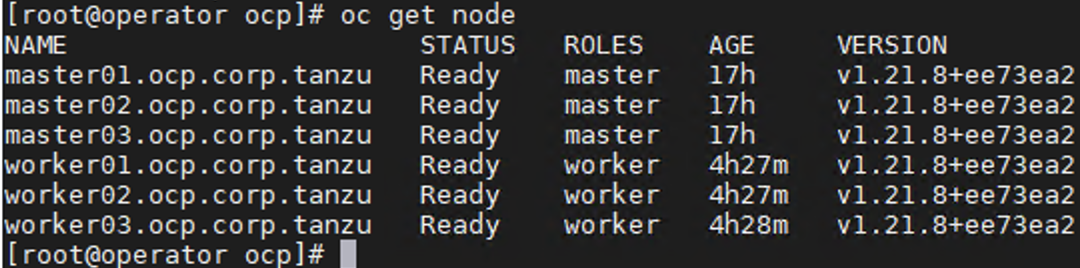

oc get nodes

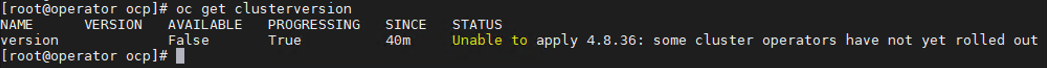

oc get clusterversion

当出现以上“some cluster operators have not yet rolled out”,则可以进入下一步部署。

3.5 检查AVI中master集群的服务是否已启动

4 部署worker节点

4.1 安装worker节点

与Bootstrap节点安装步骤相同,但注意ignition文件使用“worker.ign”

1). 启动master的三台虚机,自RHCOS ISO引导进入系统,并打开Web console;

2). 查看本地磁盘号,并记录:

fdisk -l3). 查看本地网卡连接:

nmcli connection show4). 配置网络信息,以便能与operator主机通讯;

可使用nmcli或是nmtui配置,其中nmtui为图形界面,可按提示操作即可,配置完后,记得需要激活一下。

此处记录nmcli配置:

nmcli con mod "Wired connection 1" ipv4.method manual ipv4.addresses 192.168.170.54/24 ipv4.gateway 192.168.170.1 ipv4.dns 192.168.110.10 connection.autoconnet yes ipv4.dns-search "ocp.corp.tanzu"5). 重启NetworkManager服务,使配置生效,然后进行测试:

sudo systemctl start NetworkManager6). 通过Operator上的ignition进行bootstrap的安装

sudo coreos-install install /dev/sda -I http://operator.corp.tanzu/ignition/ocp/worker.ign -n --insecure-ignition此处“-n等同于--copy-network”将上面配置的IP配置信息带入安装配置中。

7). 等待安装完成后重启主机

reboot4.2 检查Master主机的Registry库配置是否正确

ssh -i ${SSH_PRI_FILE} core@worker01.${OCP_CLUSTER_ID}.${DOMAIN} "sudo cat /etc/containers/registries.conf"4.3 检查待处理的CSR,并批准所有CSR请求

1). 检查待处理的CSR

oc get csr

2). 使用命令批准所有CSR请求

oc get csr -o go-template='{{range .items}}{{if not .status}}{{.metadata.name}}{{"\n"}} {{end}}{{end}}' | xargs --no-run-if-empty oc adm certificate approve

3). 重复工检查CSR请求,并批准所有请求,真到没有新的pending csr出现

4). 再次检查

4.4 检查集群状态

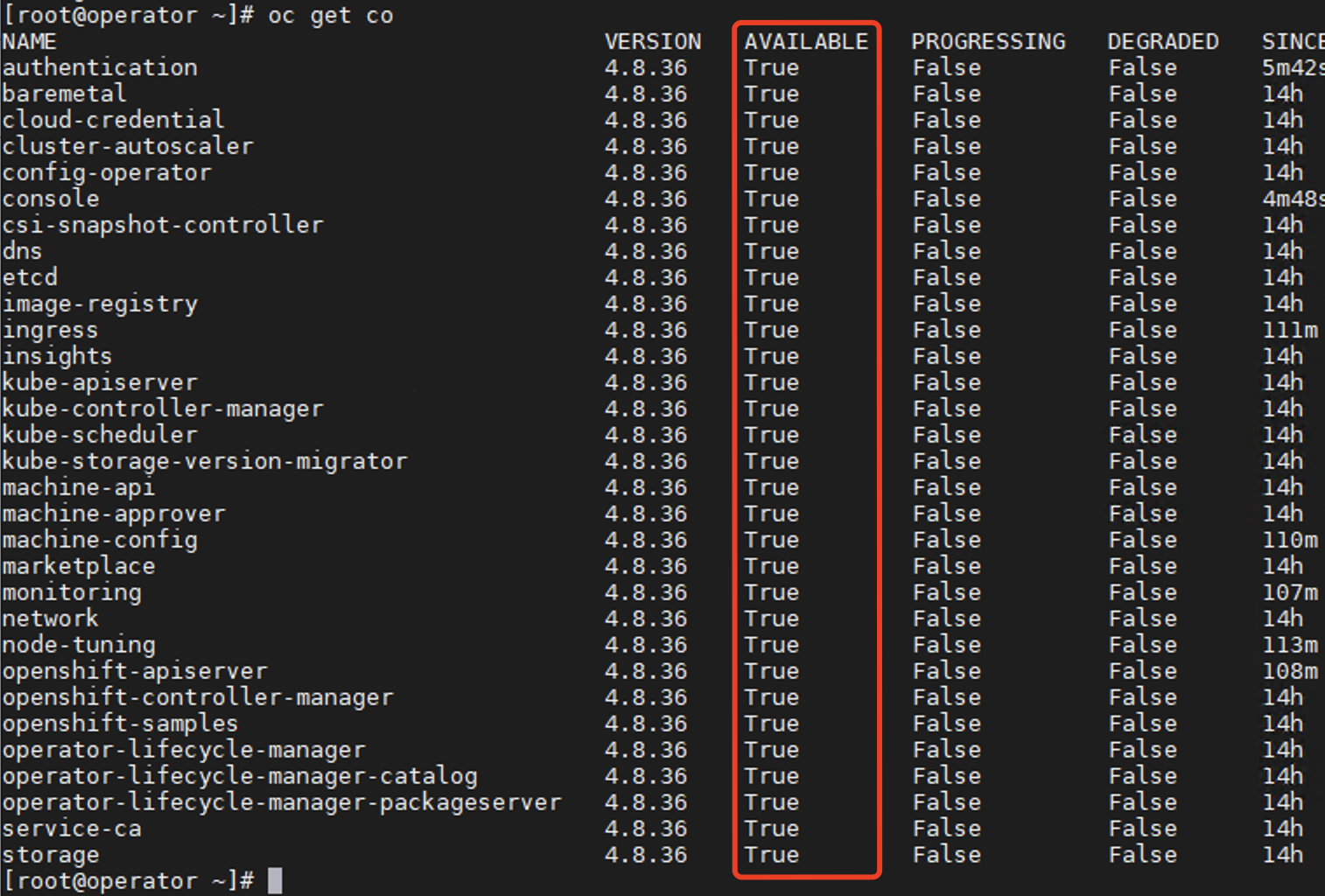

oc get co查看Available列是否已全为True,如下图:

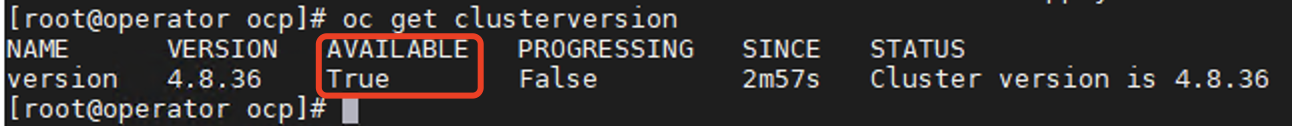

oc get clusterversion查看Available列是否已为True,如下图:

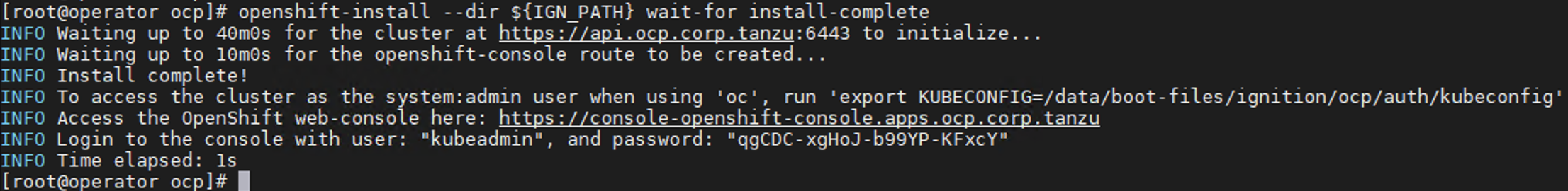

5 获取集群console地址及kubeadmin密码

openshift-install --dir ${IGN_PATH} wait-for install-complete

再次检查集群node情况:

本文链接:https://my.lmcjl.com/post/6452.html

4 评论