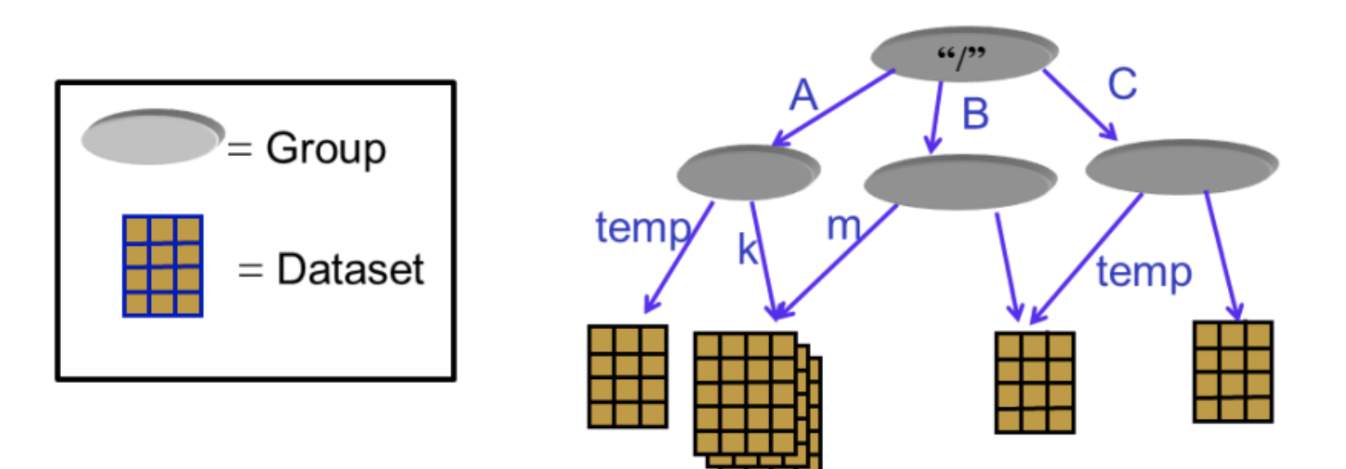

背景:h5文件详解 H5文件是层次数据格式第5代的版本(Hierarchical Data Format,HDF5),它是用于存储科学数据的一种文件格式和库文件。由美国超级计算中心与应用中心研发的文件格式,用以存储和组织大规模数据. H5将文件结构简化成两个主要的对象类型: 数据集dataset,就是同一类型数据的多维数组 组group,是一种容器结构,可以包含数据集和其他组, 继续阅读

Search Results for: 模数

查询到最新的6条

最新基于MATLAB 2023a的机器学习、深度学习实践应用

MATLAB 2023版的深度学习工具箱,提供了完整的工具链,使您能够在一个集成的环境中进行深度学习的建模、训练和部署。与Python相比,MATLAB的语法简洁、易于上手,无需繁琐的配置和安装,能够更快地实现深度学习的任务。 MATLAB的深度学习工具箱提供了丰富的函数和算法,涵盖了从数据预处理到模型训练的全过程。可以轻松地导入和处理大规模数据集,利用批量导入和Datastore类函数高效地进行 继续阅读

python pow()

pow() 是 Python 的内置函数之一,用于计算一个数的幂。具体来说,pow(x, y) 函数将两个参数 x 和 y 作为输入,返回一个数值,表示 x 的 y 次幂。pow() 函数的语法为: scssCopy code pow(x, y[, z])其中 x 和 y 是必需的参数,表示底数和指数;z 是可选参数,表示取模数。如果提供了取模数 z,那么 pow(x, y, z) 的返回值将是 x 的 y 次幂对 z 取模的结果。例如,如果我们想计算 2 的 3 次幂,可以使用 pow 继续阅读

pyspark CSV 少数据用法介绍

本文将从解答标题、CSV与pyspark的关系、异常处理、性能优化、数据可视化等多个方面详细阐述pyspark CSV 少数据处理。 一、CSV与pyspark的关系 CSV是一种常见的文件格式,是将数据按照逗号分隔的文本文件,在数据处理中占有很重要的地位。pyspark是一个分布式计算框架,是处理大规模数据的重要工具之一。pyspark提供了读取、处理和保存CSV文件的API,可以使用CSV文件进行pyspark数据分析。在使用CSV文件进行pyspark数 继续阅读

Python编写读取HDFS目录下的所有文件

如何使用Python编写程序读取HDFS目录下的所有文件?在这篇文章中,我们将详细阐述这个问题。 一、读取HDFS文件系统 HDFS是Apache Hadoop的分布式文件系统。它设计用来存储和处理大规模数据集(Big Data),并提供高容错性、高可靠性、高可扩展性和高性能的数据存储。我们通过Python的hdfs模块来连接和操作HDFS文件系统。 代码示例: from hdfs import InsecureClient hdfs_client = I 继续阅读

VXLAN:数据中心网络的未来

概要 随着云计算和虚拟化技术的快速发展,数据中心网络正面临着越来越大的挑战。传统的网络架构在适应大规模数据中心的需求方面存在一些限制,如扩展性、隔离性和灵活性等方面。为了克服这些限制,并为数据中心网络提供更好的性能和可扩展性,VXLAN(Virtual Extensible LAN)作为一种新兴的网络虚拟化技术应运而生。本文将详细介绍VXLAN的工作原理、优势以及在数据中心网络中的应用ÿ 继续阅读