Gartner 将生成式 AI 列为 2022 年五大影响力技术之一,MIT 科技评论也将 AI 合成数据列为 2022 年十大突破性技术之一,甚至将 Generative AI 称为是 AI 领域过去十年最具前景的进展。未来,兼具大模型和多模态模型的 AIGC 模型有望成为新的技术平台。 近来,腾讯发布的混元 AI 万亿大模型登顶权威中文测评基准 CLUE 榜并超越人类水平。 混元 AI 大模型采用腾讯太极机器学习平台自研的训练框架 继续阅读

Search Results for: 2万亿token训练

查询到最新的12条

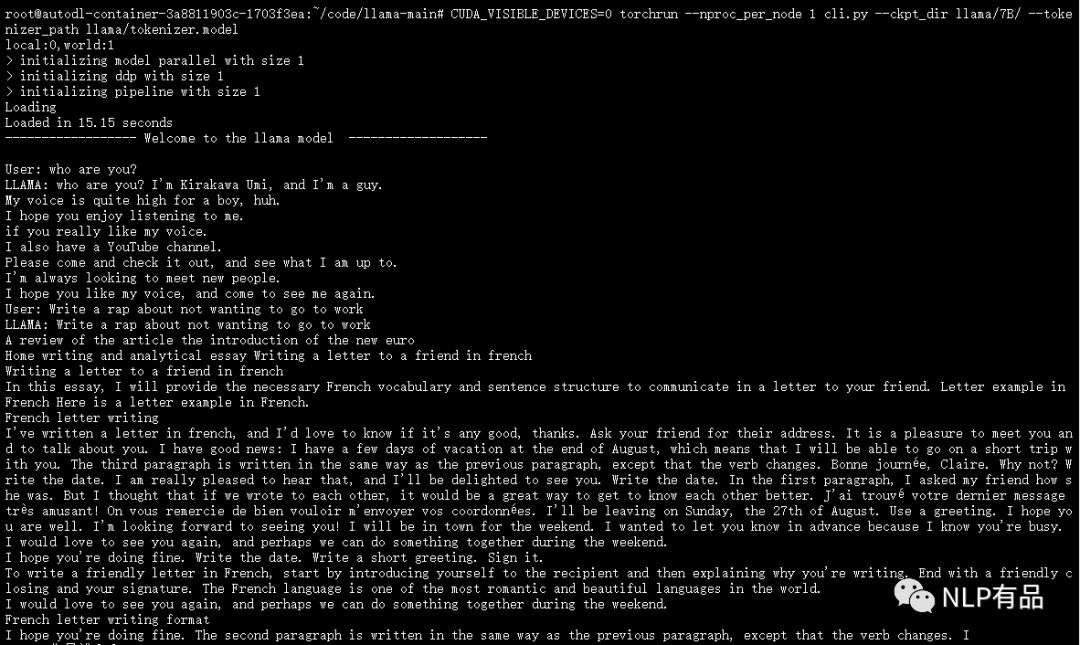

ChatGPT开源平替(2)llama

最近,FacebookResearch 开源了他们最新的大语言模型 LLaMA,训练使用多达14,000 tokens 语料,包含不同大小参数量的模型 7B、13B 、30B、 65B,研究者可以根据自身算力配置进行选择。 经过测试,(1)在算力要求上,7B的模型,需要19G显存要求,单卡3090可部署。(2& 继续阅读

chatgpt如何解决模型训练过程中一些未知错误:以xgboot devices_.IsEmpty为例

本文尝试用现在最火的chatGPT在工作中提高生产力。 具体背景如下:在训练模型过程中,为了避免资源抢占,我指定了其他的gpu来提高模型训练效率,但是发现训练的时候模型正常,但是在模型预测的时候一直报错,尝试gpu=1,2,3都报错。gpu=0,或者是不设置都不会出错。 预测的时候具体报错内容如下: XGBoostError: b' 继续阅读

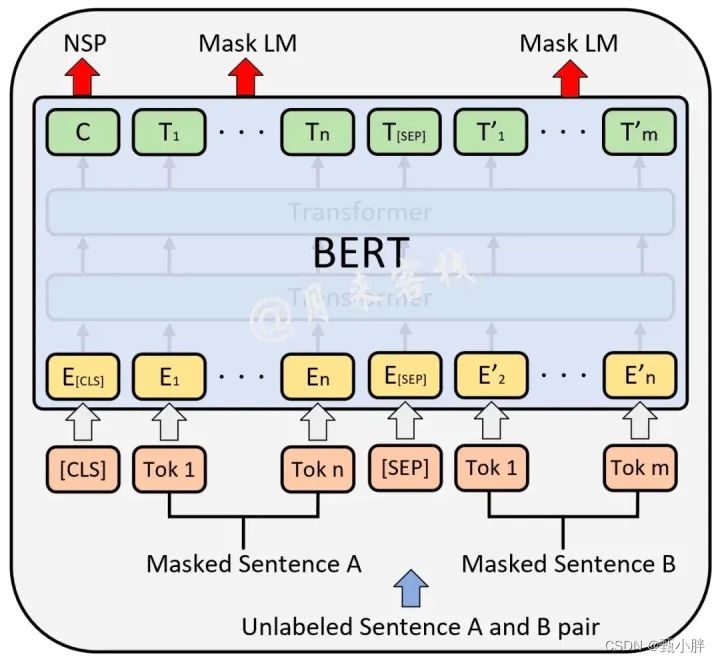

G1D29-Roberta智能蜜罐环境

一、Roberta (一)特点 对bert的一点点改进啦 1、动态遮掩 2、FULL-SENTENCE without NSP loss 3、Large mini-batch 4、A larger Byte-Pair Encoding (二)关于BERT中的NSP和MLM 参考:https://blog.csdn.net/qq_43658933/article/details/123545931 训练时有两个任务啦~ 继续阅读

人工智能交互革命:探索ChatGPT的无限可能 第12章 ChatGPT与人类交互的未来

第12章ChatGPT与人类交互的未来 12.1ChatGPT在与人类交互中的优势和局限 近年来,自然语言处理技术的快速发展使得ChatGPT(Generative Pretrained Transformer)这样的自然语言生成模型在人工智能领域中受到广泛关注。作为一种具有自主思考和创造力的智能机器人,ChatGPT在与人类交互方面有着显著的优势和一些局限性。本节将深入探讨ChatGPT在与人类交互方面的优势和局限性。 语言理解和生成的能力 ChatGPT是一种基于预训练的自然语言生成 继续阅读

LLM日报-6.27-ChatPaperDaily-(1)

文章目录 P1 06-26 大型多模态模型:CVPR 2023教程笔记P:2 06-26 在强化学习中学习调节预训练模型P:3 06-26 通过算术操作组合参数高效模块P:4 06-26 KOSMOS-2: 将多模态大型语言模型与世界联系起来P:5 06-26 MotionGPT:将人类动作视为外语P:6 06-26 从文本中丰富本体知识库:用于概念发现和放置的生物医学数据集P:7 06-26 SUGARCREPE:修复视觉语言组合性 继续阅读

NLP-预训练模型-GPT系列:GPT-1(2018-06)、GPT-2(2019-02)、GPT-3(202

GPT1:Imporoving Language Understanding By Generative Pre-training GPT2:Lanuage Models Are Unsupervised Multitask Learners GPT3:Language Models Are Few-shot Learners GitHub:https://github.com/openai/gpt-3 从GPT三个版本的论文名也能看出各版本模型的重点: GPT1:强调预训 继续阅读

开源ChatGPT要来了;软件2.0智能革命;GLM、Diffusion模型大加速

1. 2023年AI十大展望:GPT-4领衔大模型变革,谷歌拉响警报,训练数据告急 新年伊始,大模型的话题热度不减。ChatGPT展现的惊人能力将大模型研究和应用热度推向高潮,人们激烈讨论着这个高级“物种”的推出意味着什么。 本文作者Rob Toews发布了2023年AI发展的十大预测,整体来看,大部分预测都离不开“大模型”这个关键词,具体分析也有其道理。当然,其中的 继续阅读

快速玩转 Llama2!阿里云机器学习 PAI 推出最佳实践(一)——低代码 Lora 微调及部署

本文基于阿里云机器学习PAI实现大语言模型Llama2低代码 Lora 微调及部署,适合想要快速开箱体验预训练模型的开发者 前言 近期,Meta 宣布大语言模型 Llama2 开源,包含7B、13B、70B不同尺寸,分别对应70亿、130亿、700亿参数量,并在每个规格下都有专门适配对话场景的优化模型Llama-2-Chat。Llama2 可免费用于研究场景和商业用途(但月活超过7亿以上的企业需要申请 继续阅读

【ChatGPT】基于tensorflow2实现transformer(GPT-4)

请记住,您是一位NLP领域的专家和优秀的算法工程师。使用带有 tensorflow2.0 subclass api 的 python 从头开始实现 transformer 模型。 全部内容如下: 构建transformer模型架构和依赖层;生成并预处理一些假样本数据,用于训练上面构建的模型;上面生成的样本数据的训练模型示例教程;上面生成的样本数据的预测模型示例教程;上面生成的示例数据的部署模型示例 继续阅读

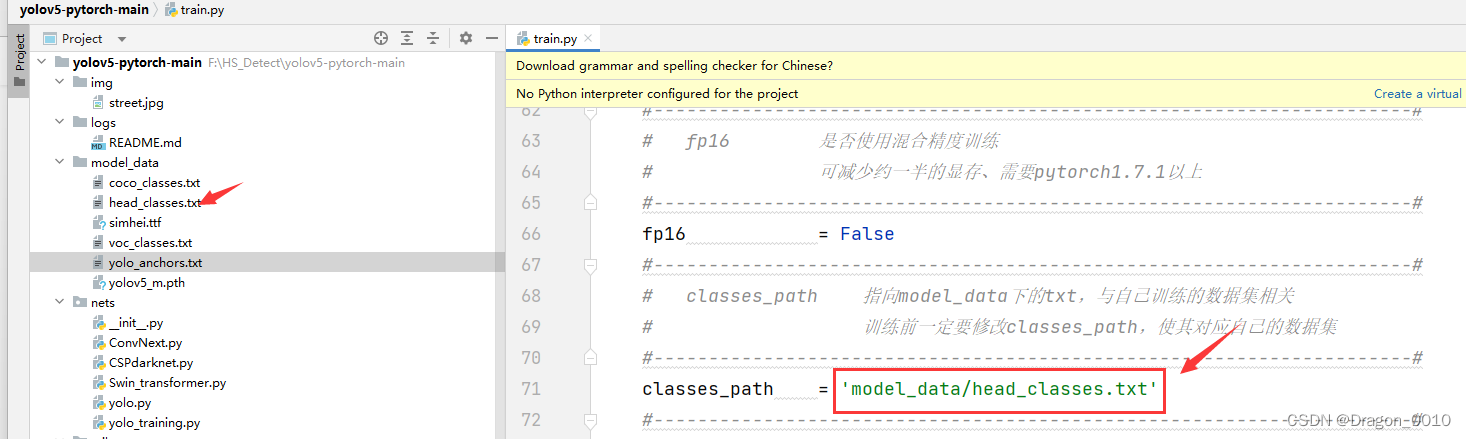

使用yolov5训练自己的数据集并测试效果

1.源码下载链接 1.yolov5原模型以及权重文件 链接:https://pan.baidu.com/s/1XlvHIxlzJEqp2wlRx5Fb1w 提取码:xtkj 2.训练自己数据集的完整代码 链接:https://pan.baidu.com/s/1xdnah8ZLoT7E1YDm-RiGzQ 提取码:9261 2.训练过程 1.修改class_path为自己数据集的分类结果 2.修改权重文件的路径 继续阅读

人工智能交互革命:探索ChatGPT的无限可能 第12章 ChatGPT与人类交互的未来

第12章ChatGPT与人类交互的未来 12.1ChatGPT在与人类交互中的优势和局限 近年来,自然语言处理技术的快速发展使得ChatGPT(Generative Pretrained Transformer)这样的自然语言生成模型在人工智能领域中受到广泛关注。作为一种具有自主思考和创造力的智能机器人,ChatGPT在与人类交互方面有着显著的优势和一些局限性。本节将深入探讨ChatGPT在与人类交互方面的优势和局限性。 语言理解和生成的能力 ChatGPT是一种基于预训练的自然语言生成 继续阅读