分类目录:《深入理解深度学习》总目录 BERT是由堆叠的Transformer Encoder层组成核心网络,辅以词编码和位置编码而成的。BERT的网络形态与GPT非常相似。简化版本的ELMo、GPT和BERT的网络结构如下图所示。图中的“Trm”表示Transformer Block,即基于Transformer的特征提取器。 ELMo使用自左向右编码和自右向左编码的两个LSTM网络,分别以 P ( w i ∣ w 1 , w 继续阅读

Search Results for: Bidirectional

查询到最新的2条

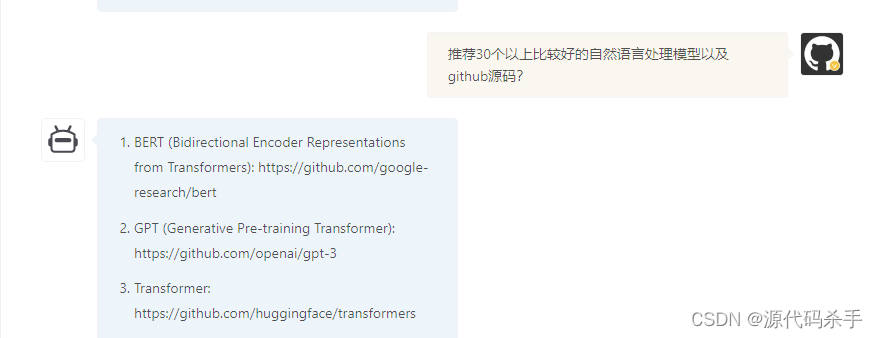

【回答问题】ChatGPT上线了!推荐30个以上比较好的自然语言处理模型

【回答问题】ChatGPT上线了!推荐40个以上比较好的自然语言处理模型以及github源码? BERT (Bidirectional Encoder Representations from Transformers): https://github.com/google-research/bert GPT (Generative Pre-training Transformer): https://github.com/openai/gpt-3 Transfo 继续阅读