GitHub - huggingface/peft: 🤗 PEFT: State-of-the-art Parameter-Efficient Fine-Tuning. 最先进的参数高效微调 (PEFT) 方法 Parameter-Efficient Fine-Tuning (PEFT) 方法可以使预训练语言模型 (PLM) 高效适应各种下游应用程序,而无需微调模型的所有参数。微调大型 PLM 的成本通常高得令人望而却步。在这方面,PE 继续阅读

Search Results for: HuggingFace

查询到最新的6条

ChatGPT来了,让我们快速做个AI应用

你好,我是徐文浩。 过去的两讲,我带着你通过OpenAI提供的Embedding接口,完成了文本分类的功能。那么,这一讲里,我们重新回到Completion接口。而且这一讲里,我们还会快速搭建出一个有界面的聊天机器人来给你用。在这个过程里,你也会第一次使用 HuggingFace 这个平台。 HuggingFace 是现在最流行的深度模型的社区,你可以在里面下载到最新开源的模型&# 继续阅读

中科大ChatGPT学术镜像小白部署教程,全民都可以拥抱AI

docker…不会用…python不会用…服务器默认python版本3.6不会升级…代理也不会配置…各种命令不会用… 那么下面就是最简单办法,点点点即可【希望有帮助?】 文章目录一、体验镜像地址二、 基本配置2.1 config.py文件2.2 main.py文件三、下载项目四、项目部署五、演示 一、体验镜像地址 中科大学术版ChatGPT镜像:https://huggingface.co/spaces/cfwef/gpt 永久免费镜像克隆 继续阅读

tiktoken (a fast BPE tokeniser for use with OpenAI‘s mo

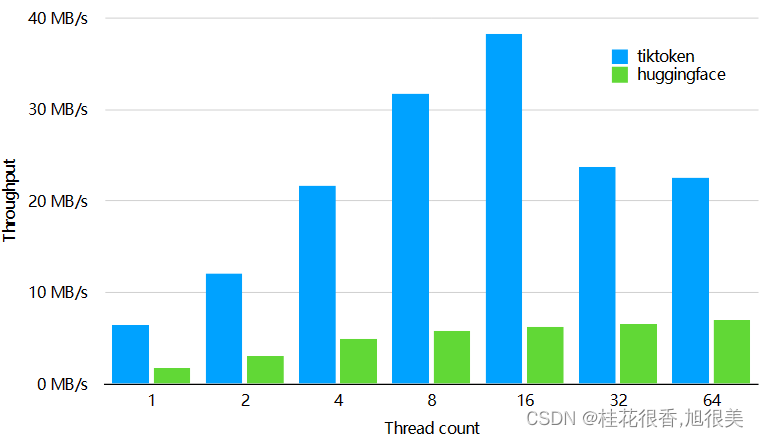

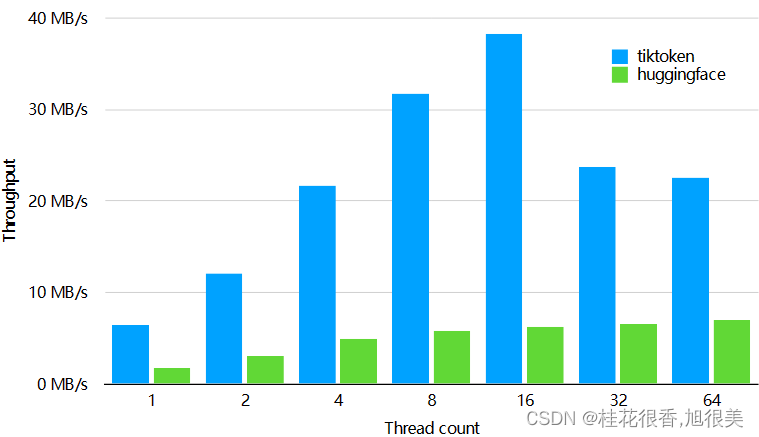

OpenAI在其官方GitHub上公开了一个最新的开源Python库:tiktoken,这个库主要是用做字节对编码(BPE)的。相比较HuggingFace的tokenizer,其速度提升了好几倍。 chatgpt 按token 数量收费,1000个token大约700个单词,可以用tiktoken统计token数量,自己估算费用或者做token数量限制! 安装 pip install tik 继续阅读

RLHF:基于人类反馈(Human Feedback)对语言模型进行强化学习【Reinforcement Le

HuggingFace发表了一篇博客,详细讲解了ChatGPT背后的技术原理——RLHF。 笔者读过之后,觉得讲解的还是蛮清晰的,因此提炼了一下核心脉络,希望给对ChatGPT技术原理感兴趣的小伙伴带来帮助。 此外,文末整理了几篇关于 RLHF 最热门的12篇必读论文,卖萌酱打包好挂在公众号后台了,感兴趣的小伙伴可以在公众号“夕小瑶的卖萌屋”后台回复【1212】领取。 在过去几年里࿰ 继续阅读

tiktoken (a fast BPE tokeniser for gpt4、chatgpt)

OpenAI在其官方GitHub上公开了一个最新的开源Python库:tiktoken,这个库主要是用做字节对编码(BPE)的。相比较HuggingFace的tokenizer,其速度提升了好几倍。 chatgpt 按token 数量收费,1000个token大约700个单词,可以用tiktoken统计token数量,自己估算费用或者做token数量限制! 安装 pip install tik 继续阅读