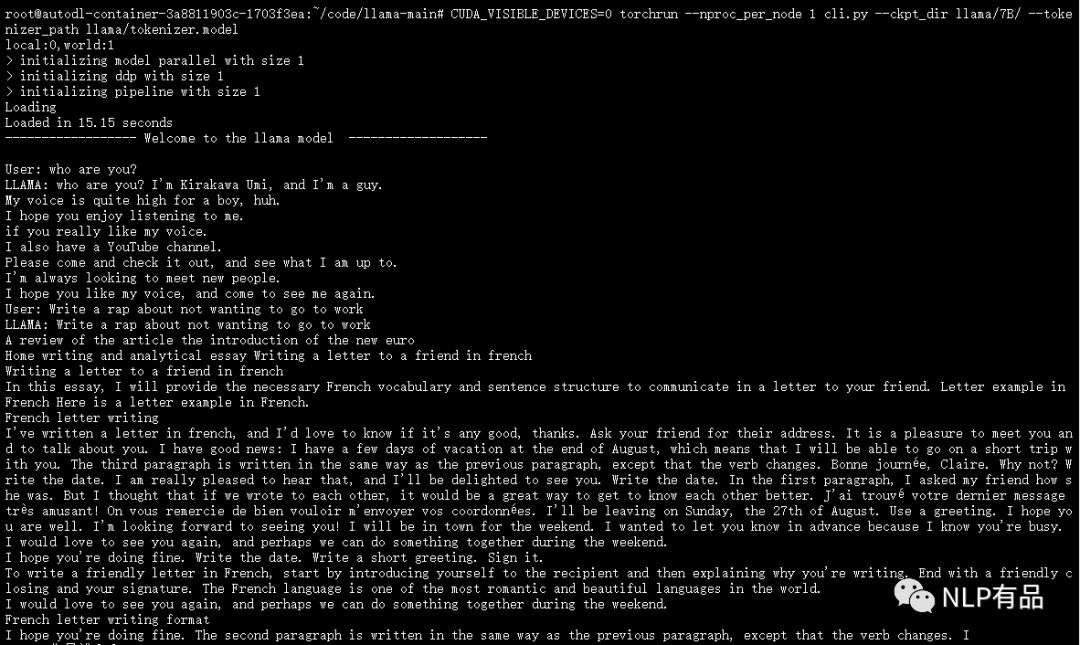

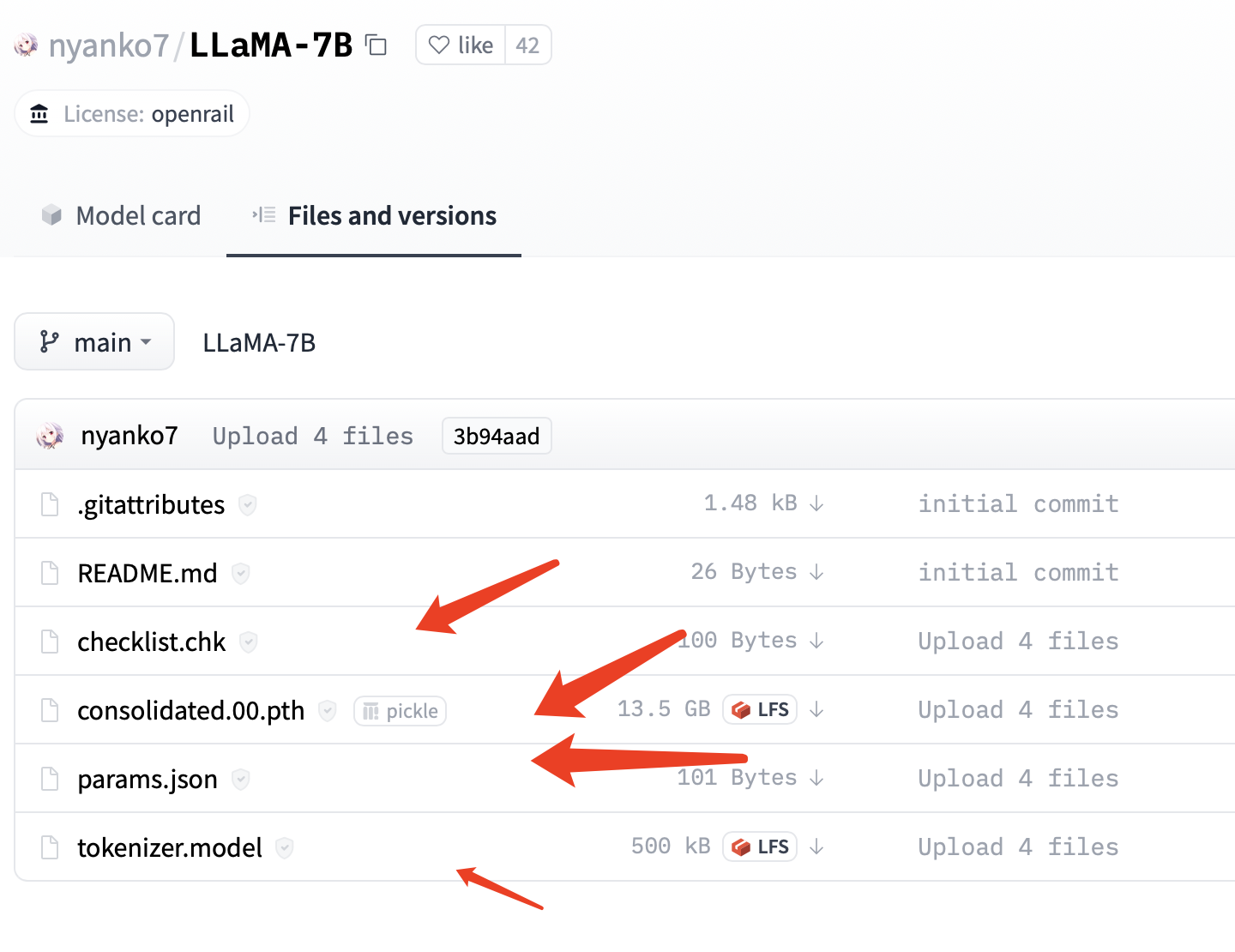

最近,FacebookResearch 开源了他们最新的大语言模型 LLaMA,训练使用多达14,000 tokens 语料,包含不同大小参数量的模型 7B、13B 、30B、 65B,研究者可以根据自身算力配置进行选择。 经过测试,(1)在算力要求上,7B的模型,需要19G显存要求,单卡3090可部署。(2& 继续阅读

Search Results for: Llama

查询到最新的7条

快速玩转 Llama2!阿里云机器学习 PAI 推出最佳实践(一)——低代码 Lora 微调及部署

本文基于阿里云机器学习PAI实现大语言模型Llama2低代码 Lora 微调及部署,适合想要快速开箱体验预训练模型的开发者 前言 近期,Meta 宣布大语言模型 Llama2 开源,包含7B、13B、70B不同尺寸,分别对应70亿、130亿、700亿参数量,并在每个规格下都有专门适配对话场景的优化模型Llama-2-Chat。Llama2 可免费用于研究场景和商业用途(但月活超过7亿以上的企业需要申请 继续阅读

【类ChatGPT】本地CPU部署中文羊驼大模型LLaMA和Alpaca

昨天在github上看到一个在本地部署中文大模型的项目,和大家分享一下。先把地址po出来。 项目名称:中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs) 项目地址:https://github.com/ymcui/Chinese-LLaMA-Alpaca 以下是原github中给出的体验GIF,可以看到这个模型还是具备一定的指令理解和上下文对话能力的。 继续阅读

本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿、130亿、330亿和650亿这4种参数规模的模型,参数是指神经网络中的权重和偏置等可调整的变量,用于训练和优化神经网络的性能,70亿意味着神经网络中有70亿个参数,由此类推。 在一些大型神经 继续阅读

Vicuna-13B使用云服务器部署

Vicuna概述 Vicuna由一群主要来自加州大学伯克利分校的研究人员推出,仍然是熟悉的配方、熟悉的味道。Vicuna同样是基于Meta开源的LLaMA大模型微调而来,它的训练数据是来自ShareGPT上的7万多条数据(ShareGPT一个分享ChatGPT对话的谷歌插件): 在训练方式上,研究人员借鉴了Alpaca:增强了Alpaca提供的训练脚本,以更好地处理多轮对话和长 继续阅读

十大开源GPT替代模型,实现属于你自己的chatGPT

文章目录 LLaMAAlpacaAlpaca-LoRAChinese-VicunaBLOOMBELLET5BERTOPTGLM 公众号: MCNU云原生,文章首发地,欢迎微信搜索关注,更多干货,第一时间掌握! 今年chatGPT真的是出尽了风头,搞得好像凡是不讲chatGPT的都是村里还没通网络的,各种技术平台也是充斥着人工智能的相关文章,凡是不 继续阅读

ChatDoctor(LLM大模型用于医疗对话)

ChatDoctor: A Medical Chat Model Fine-tuned on LLaMA Model using Medical Domain Knowledge paper:https://arxiv.org/pdf/2303.14070.pdf 通用领域中最近的大型语言模型 (LLM),例如 ChatGPT,在遵循指令和产生类似人类的响应方面取得了显着的成功。 但是语言模型并未针对医学领域量身定制,导致答案准确性较差 继续阅读