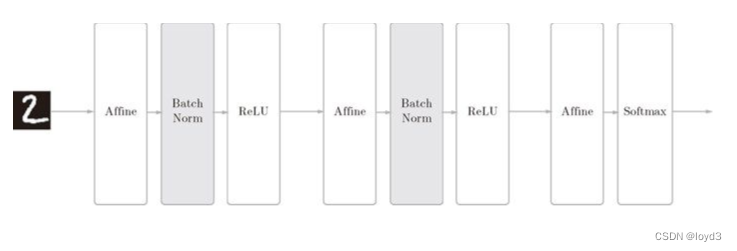

如果为了使各层拥有适当的广度,“强制性”地调整激活值的分布会怎样呢?实际上,Batch Normalization 方法就是基于这个想法而产生的 为什么Batch Norm这么惹人注目呢?因为Batch Norm有以下优点: 可以使学习快速进行(可以增大学习率)。不那么依赖初始值(对于初始值不用那么神经质) 。抑制过拟合(降低Dropout等的必要性)。 Batch Norm的思路是调整各层的激活值分布使其拥有适当的广度。为此 继续阅读

Search Results for: Normalization

查询到最新的1条