最近 ChatGPT3.5 在全世界范围内掀起了一次 AI 的潮流,ChatGPT1.0/ChatGPT2.0 当时也是比较火爆,但是那个当时感觉还是比较初级的应用,相当于是一个进阶版的微软小冰,给人的感觉是有一点智能,但不多。其实从早期版本开始,就已经能够理解较多的上下文信息并给出符合上下文的回复,但是给人的震撼并不如这次 3.5/4.0 版本来的多。就我个人而言,最直接的比较震撼的 继续阅读

Search Results for: gpt2

查询到最新的5条

NLP-预训练模型-GPT系列:GPT-1(2018-06)、GPT-2(2019-02)、GPT-3(202

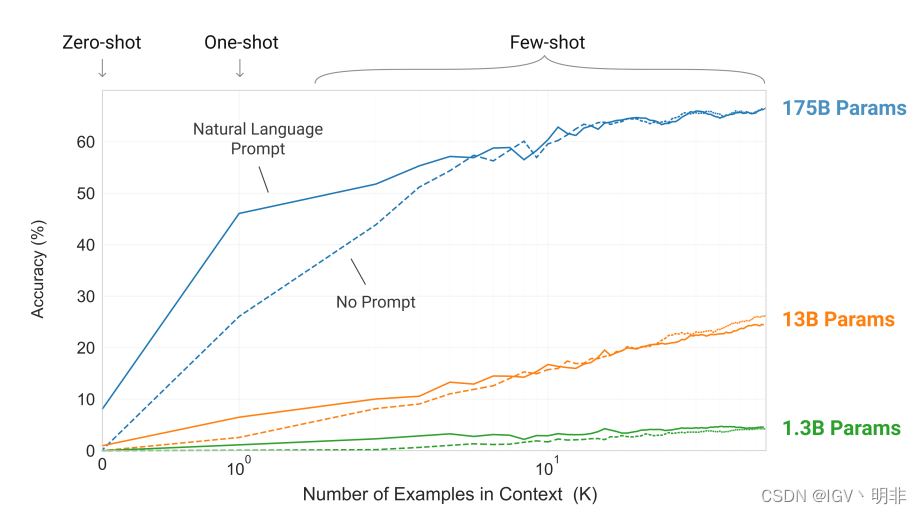

GPT1:Imporoving Language Understanding By Generative Pre-training GPT2:Lanuage Models Are Unsupervised Multitask Learners GPT3:Language Models Are Few-shot Learners GitHub:https://github.com/openai/gpt-3 从GPT三个版本的论文名也能看出各版本模型的重点: GPT1:强调预训 继续阅读

从GPT到chatGPT(三):GPT3(一)

#GPT3 文章目录前言正文摘要介绍方法模型结构训练数据集训练过程评估小结 前言 OpenAI在放出GPT2后,并没有引起业界太大的影响和关注,究其原因,并不是zero-shot这种想法不够吸引人,而是GPT2表现出来的效果依然差强人意,仍然属于“人工智障”的阶段,然而OpenAI认为他们的方向没有问题,不在特定领域上做太多的微调,甚至不做微调(这样就能避免1. 继续阅读

ChatGPT——OpenAI推出的人工智能聊天机器人

ChatGPT——OpenAI推出的人工智能聊天机器人 目录 [隐藏] 1 什么是ChatGPT2 ChatGPT的应用领域[3]3 ChatGPT的原理4 ChatGPT的发展历程5 ChatGPT爆火的原因6 ChatGPT带来的变革7 社会各界对于ChatGPT的态度8 ChatGPT同类型产品9 相关条目10 参考文献 [编辑]什么是ChatGPT ChatGPT全称为“chat Generative Pre-trained Transformer”,翻译成中 继续阅读

ChatGPT原理解析

文章目录Transformer模型结构构成组件整体流程GPT预训练微调模型GPT2GPT3局限性GPT4相关论文 Transformer Transformer,这是一种仅依赖于注意力机制而不使用循环或卷积的简单模型,它简单而有效,并且在性能方面表现出色。 在时序模型中,2017年最常用的模型是循环神经网络(RNN),RNN是一种序列模型,通过将之前的信息存储在隐藏状态中,使得它能够有效 继续阅读