audtorch-系列文章目录 提示:这里可以添加系列文章的所有文章的目录,目录需要自己手动添加 例如:第一章 Python 机器学习入门之pandas的使用 提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档 文章目录 系列文章目录前言一、audtorch是什么?二、使用步骤 1.引入库2.读入数据总结 前言 为了让自己成功攀登上语音处理深度学习的 继续阅读

Search Results for: torch

查询到最新的12条

Pytorch——Conv2d、conv2d

Conv2d、conv2d是pytorch中进行卷积操作的2个类,虽然只是首字母大小写不同,使用起来方法也不一样,一个是类,一个是函数。 1 Conv2d Conv2d是torch.nn中的类 1.1 初始化 CLASS torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups 继续阅读

深入浅出Pytorch函数——torch.numel

分类目录:《深入浅出Pytorch函数》总目录 相关文章: · 深入浅出TensorFlow2函数——tf.size · 深入浅出Pytorch函数——torch.numel · 深入浅出PaddlePaddle函数——paddle.numel 语法 torch.numel(input) 参数 input: [torch.Tensor] 输入的张量 返回值 input张量元素的总数 实例 >>> a = torch.ra 继续阅读

pytorch中的numel函数

获取tensor中一共包含多少个元素 import torch x = torch.randn(3,3) print("number elements of x is ",x.numel()) y = torch.randn(3,10,5) print("number elements of y is ",y.numel()) 输出: number elements of x is 9 number elements of 继续阅读

pytorch获取张量元素个数numel()的用法

numel就是"number of elements"的简写。numel()可以直接返回int类型的元素个数 import torcha = torch.randn(1, 2, 3, 4) b = a.numel() print(type(b)) # int print(b) # 24 通过numel()函数,我们可以迅速查看一个张量到底又多少元素。 继续阅读

【Pytorch API笔记3】用torch.numel()来统计网络的参数量

如何统计网络的大小,可以试一试torch.numel()函数 torch.numel()函数,可以计算出单个tensor元素的个数 一、对单个tensor使用,求tensor元素的个数 x = torch.randn((1, 3, 5, 7)) x.numel() torch.numel() 输出105 二、求整个网络的参数 n_p = sum(x.numel() for x in model.parameters()) 继续阅读

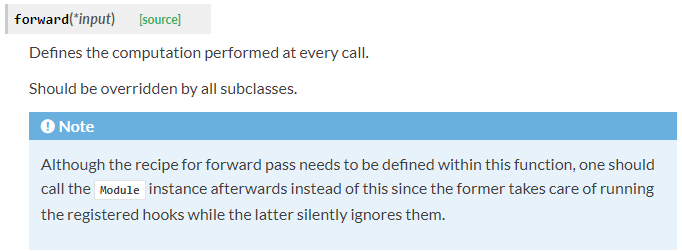

Pytorch中什么时候调用forward()函数

Module类是nn模块里提供的一个模型构造类,是所有神经网络模块的基类,我们可以继承它来定义我们想要的模型。下面继承Module类构造本节开头提到的多层感知机。这里定义的MLP类重载了Module类的__init__函数和forward函数。它们分别用于创建模型参数和定义前向计算。前向计算也即正向传播。 import torch from torch import nnclass MLP(nn.Module):# 声明带有模型参数的层,这里声明了两个 继续阅读

pytorch 中的 forward 的使用与解释

转自:https://blog.csdn.net/xu380393916/article/details/97280035,感谢作者分享。 在使用pytorch的时候,模型训练时,不需要使用forward,只要在实例化一个对象中传入对应的参数就可以自动调用 forward 函数 class Module(nn.Module):def __init__(self):super(Module, self).__init__()# 继续阅读

python中forward是什么意思_pytorch 中forward 的用法与解释说明

前言 最近在使用pytorch的时候,模型训练时,不需要使用forward,只要在实例化一个对象中传入对应的参数就可以自动调用 forward 函数 即: forward 的使用 class Module(nn.Module): def __init__(self): super(Module, self).__init__() # ...... def forward(self, x): # ...... return x data = ..... #输入数据 # 实例化一个对象 modul 继续阅读

PyTorch深度学习

这本PyTorch深度学习图书,是2019-04-01月由人民邮电出版社所出版的,著作者信息: [印度] 毗湿奴·布拉马尼亚(Vishnu Subramanian) 著,王海玲,刘江峰 译,本版是第1次印刷, ISBN:9787115508980,品牌:异步图书, 这本书的包装是16开平装,所用纸张为胶版纸,全书页数193,字数有万字, 是本值得推荐的Python软件开发图书。此书内容摘要 PyTorch是Facebook于2017年初在机器学习和科学计算工具Tor 继续阅读

解决:torch.cuda.is_available()一直返回False,显卡是NVIDA GeForce

目录 1. 背景2. 发现问题根源3. 解决问题 1. 背景 AI时代了,之前一直不怎么用到的小米笔记本Pro的 NVIDA GeForce MX250独显,就想着让它发挥余热,免得买了这么多年,一直闲置,浪费。 无脑按照chatGPT给的例子,一段乱搞,突然发现一直报错,说无可用的GPU,这就烦人了,明明有,但是好像隐身 继续阅读

PyTorch之前向传播函数forward

神经网络的典型处理如下所示: 1. 定义可学习参数的网络结构(堆叠各层和层的设计); 2. 数据集输入; 3. 对输入进行处理(由定义的网络层进行处理),主要体现在网络的前向传播; 4. 计算loss ,由Loss层计算; 5. 反向传播求梯度; 6. 根据梯度改变参数值,最简单的实现方式(SGD)为: we 继续阅读