ImportWarning与在模块导入中可能的错误相关的警告的基类。本文地址:https://my.lmcjl.com/exception/import-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

Search Results for: war

查询到最新的12条

Pytorch中什么时候调用forward()函数

Module类是nn模块里提供的一个模型构造类,是所有神经网络模块的基类,我们可以继承它来定义我们想要的模型。下面继承Module类构造本节开头提到的多层感知机。这里定义的MLP类重载了Module类的__init__函数和forward函数。它们分别用于创建模型参数和定义前向计算。前向计算也即正向传播。 import torch from torch import nnclass MLP(nn.Module):# 声明带有模型参数的层,这里声明了两个 继续阅读

【ubuntu】【vmware tools】设置共享目录

1、现象 ubuntu 22 + vmware 16,安装后会发现 “Reinstall VMware Tools…” 灰色不可用。如图: 2、原因分析 ubuntu 22 ISO 内不再提供 VMware Tools 的安装包,未检测到所以灰色不可用 在 Ubuntu 22 上挂载 Windows HGFS 共享目录,你需要安装并配置 open-vm-tools。 3、解决方案 安装 open-vm-tools # 继续阅读

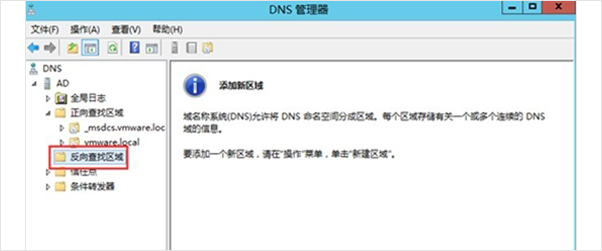

VMware搭建配置DNS服务器的方法步骤(图文教程)

随着VMware在各行各业的大量使用,各种用户的问题和疑问也相继增多,重庆正睿科技有限公司座位VMware的合作伙伴,今天就与大家分享一下VMware搭建配置DNS服务器的方法步骤。 方法步骤: 1、在步骤2.1中已经安装好了DNS,现在使用域账号登录ad服务器上。使用dnsmgmt.msc打开DNS配置界面:右键创建反向查找区域: 2、其他按照默认提示点击下一,在如图所示处键入192.168.0,按照默认提示点击下一步即可 3、在正向查找区域,更新AD的PTR 继续阅读

ResourceWarning

ResourceWarning与资源使用相关的警告的基类。 会被默认的警告过滤器忽略。3.2 新版功能.本文地址:https://my.lmcjl.com/exception/resource-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

BytesWarning

BytesWarning与 bytes 和 bytearray 相关的警告的基类。本文地址:https://my.lmcjl.com/exception/bytes-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

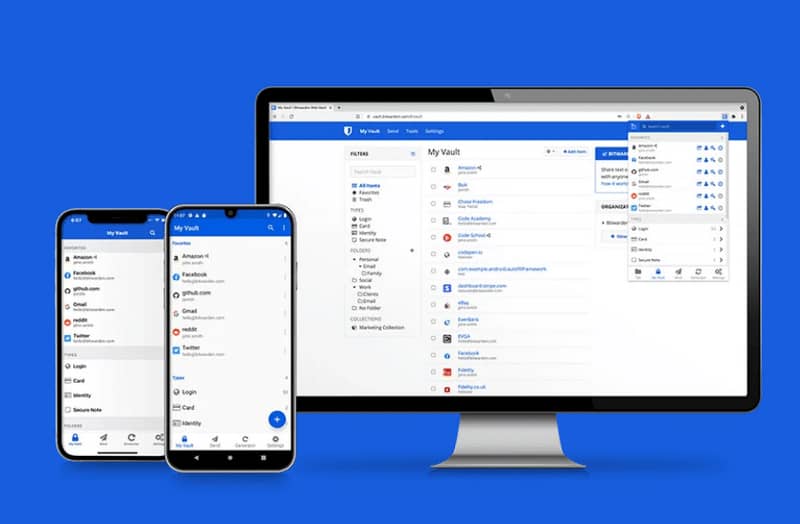

BitWarden – 免费全平台开源密码管理器

作为一个计算机专业毕业的人来说,互联网上的密码肯定不能是简单地“asdf1234”,但是密码多了有的时候也确实记不住,今天老俍就来推荐一款免费全平台开源密码管理软件 – Bitwarden。 BitWarden 简介 BitWarden 是一款免费且开源的密码管理服务,用户可在加密的保管库中存储敏感信息(例如网站登录凭据)。Bitwarden 平台提供有多种客户端应用程序(网页版、Windows、macOS、安卓、Linux 继续阅读

UnicodeWarning

UnicodeWarning与 Unicode 相关的警告的基类。本文地址:https://my.lmcjl.com/exception/unicode-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

FutureWarning

FutureWarning如果所发出的警告是针对以 Python 所编写应用的最终用户的,则以此作为与已弃用特性相关警告的基类。本文地址:https://my.lmcjl.com/exception/future-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

RuntimeWarning

RuntimeWarning与模糊的运行时行为相关的警告的基类。本文地址:https://my.lmcjl.com/exception/runtime-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

SyntaxWarning

SyntaxWarning与模糊的语法相关的警告的基类。本文地址:https://my.lmcjl.com/exception/syntax-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

transformer学习笔记:Feed-Forward Network

transformer结构在Muli-Head Attention层之后还添加了一层Feed-Forward层。Feed-Forward层包括两层全连接层以及一个非线性激活函数ReLu。 注意到在Mui-Head Attention的内部结构中,我们进行的主要都是矩阵乘法(scaled Dot-Product Attention),即进行的都是线性变换,而线性变换的学习能力是不如非线性变化的强的,所以Mui-Head Attention的 继续阅读