所以农历新年以后的每天过的都是这种生活……好吧其实在过年之前就是这样的生活了,除了去吃饭以为就是在房间呆着了,游戏也没玩。 过年那天在沙发上坐了会就被问在干嘛。一般不都是在发短信祝贺新年什么的吗但是我当时正在看哈利波特(1-7).txt(…………) 其实也偶尔出门了。昨天有去梅园,前天在小区闲逛遇到火灾。。 再之前几天发现姨妈养的乌龟死了← 之前都以为是在冬眠。姨妈家的芦荟也死了orz 不管怎样新地址新开始的第一篇,还是要说新年快乐XDD 继续阅读

Search Results for: 新开

查询到最新的9条

又又又回家啦

已经习惯一到节假日就要回家,虽说现在我爸妈想见的可能只是小朋友而已 爸妈的闲情逸致 有听说种菜是中国人自带的技能,虽说我是完全种不好?(之前养了盆长寿花,就活了1个多月)不过我爸倒是把技能点满了。以前也有写过关于小院子的内容:不太顺利的端午节,那时候还是挂满葡萄,开着栀子花的小清新院子,今年受疫情影响,爸妈至今还没有开学,闲的太久无聊就开始捯饬院子了,现在到处是新开垦的菜地哈哈哈。 小朋友也在一个角落种下了她心爱的油菜花,开始盼望着下一次来看望她的花花。 葡萄现在还是这样小小的~之前端午 继续阅读

ChatGPT来了,让我们快速做个AI应用

你好,我是徐文浩。 过去的两讲,我带着你通过OpenAI提供的Embedding接口,完成了文本分类的功能。那么,这一讲里,我们重新回到Completion接口。而且这一讲里,我们还会快速搭建出一个有界面的聊天机器人来给你用。在这个过程里,你也会第一次使用 HuggingFace 这个平台。 HuggingFace 是现在最流行的深度模型的社区,你可以在里面下载到最新开源的模型&# 继续阅读

网络兼职能赚钱吗,网络兼职如何赚取收入?

随着互联网的发展,大家开始逐渐在网络上找“副业”,“搞钱”的方式也是五花八门。最让人印象深刻的应该是约拍了,那么以这类技能为主的账号发展空间有多大呢?这篇文章可能有你想要的答案。 去年12月,豆瓣用户@豆友友 在豆瓣小组“副业失败的一天”发布了一个帖子,自述想要继续拍照的副业,但目前的技术尚不够专业,想要寻求其他用户的建议。 一年之后,她重新开帖,记录这一年内在小红书与模特“约拍互勉”的创作过程。令人惊喜的是,摄影技术上的进步之外,@豆友 继续阅读

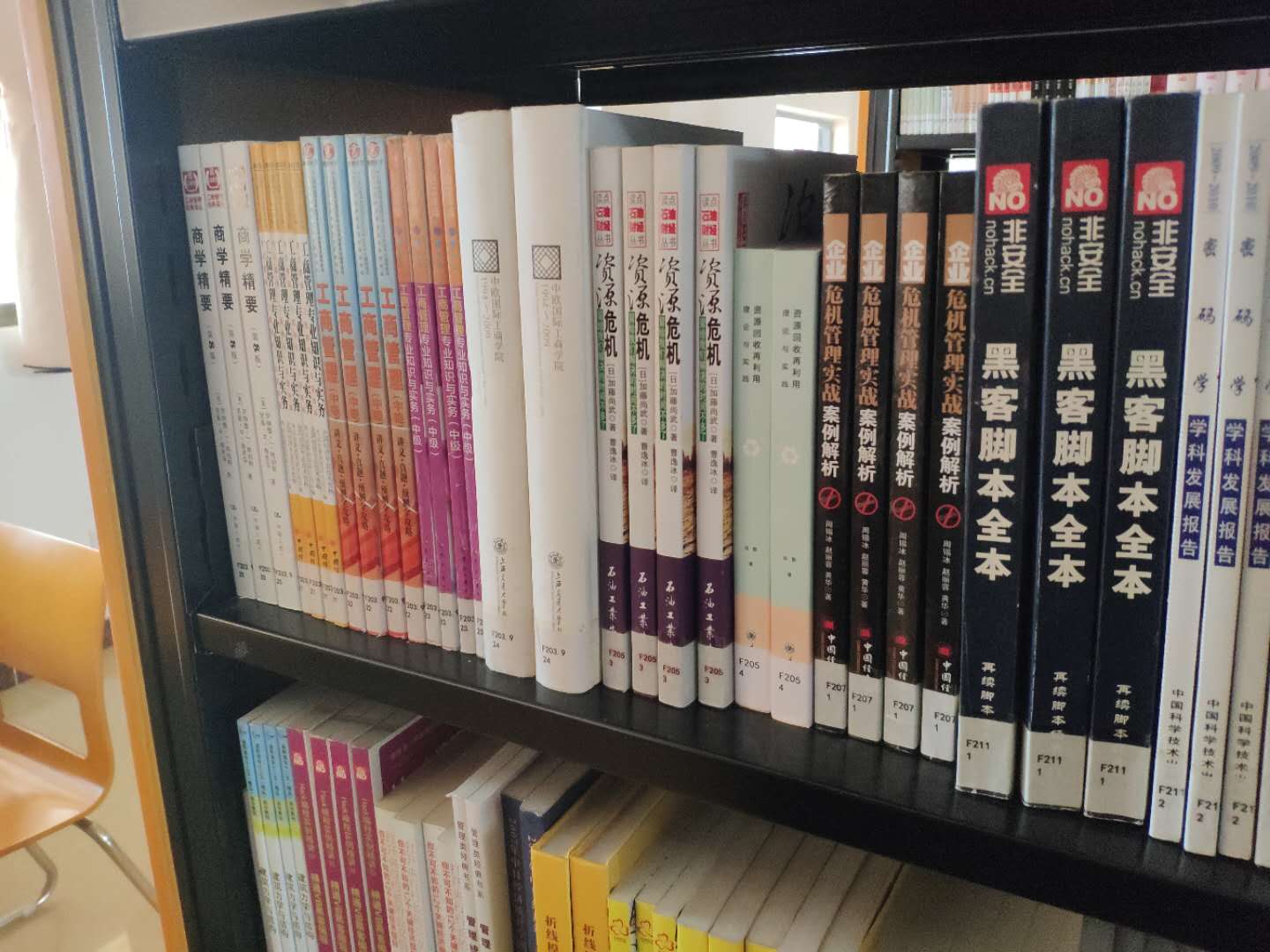

大学第一次逛图书馆

过前几个星期我们劳动周,我们宿舍被分配到图书馆打扫卫生,算是提前看到了真面目吧,相比于其他人在太阳下劳动,我们是轻松的,只是简简单单的拖拖地,清清灰,清理窗户,清理装修留下的垃圾,所以我大学的劳动周是洽意的,还能在书香里遨游(说的都是屁话~)11.5日也就是今天,我校图书馆二次装修重新开馆,话说真的挺高科技的,还能看见进馆出馆人数,里面设备也齐全的,书也很多,图书馆整整四楼,刷新我的三观~我随便拿了几张图书馆的照片,给你们看一看~黑客书籍借书机器 继续阅读

记一次 WordPress 迁移升级

本博客在 Vultr VPS 平稳运行五年有多,一直到近期发现由于PHP版本过低而造成插件无法升级,再加上VPS当初安装的操作系统版本过低,如果在原来的升级上进行升级,担心升级后的兼容性和稳定性,于是新开一个主机,进行一次迁移升级。 第一步:WordPress 和相应插件都升级到最新版本,然后利用“WP-DBManager”插件,对博客进行数据完整备份。备份前记得优化数据和备份时进行压缩。建议备份三次。 第二步:在 Vultr VPS 新开一个最便宜套餐的主机(我选的是日本机房),并且选择安装 继续阅读

教育机构加盟代理,硬笔书法加盟哪里性价比比较高

运作伊始,大多硬笔书法培训学校事无巨细,没有自己鲜明的特点和优势,难以形成市场口碑,学员人数就不会有大的突破。一家新开硬笔书法培训机构想要被家长接受,少则半年,多则一年甚至两年,所以,更建议选择有一定市场口碑,品牌优势的硬笔书法加盟品牌,教育行业从不是急功近利的行业。 优秀的硬笔书法加盟品牌有全面的管理系统帮助校区运营管理,一套成熟的管理系统,用来管理老师,学员,帮助排课等,能节约大量的管理事件与精力。培训机构加强对教师的管理对于教师的管 继续阅读

代运营电商公司上班好吗(找电商代运营公司需要注意这些)

目前,大多数做电子商务的企业都会想找一家电子商务公司来提高他们商店的销量或商店水平。那么目前的电商代运营公司怎么样呢?只能说现在的电商代运营公司真的层出不穷,而且鱼龙混杂,有好的也有不好的。一般要找电商代运营公司的话一定要先确定这家公司是不是正规靠谱的公司。 现在就简单归类为三大部分:骗子型代运营公司;套路型代运营公司;专业型代运营公司。 骗子型:基本上就是割韭菜式的,(就是骗一波钱然后改名字重新开一家新的代运营公司然后再骗 继续阅读

ReduceNet

本文直接采用VanillaNet的方案重新开始构建模型ReduceNet。按照VanillaNet的方式极限压缩网络深度至单层 前几天在知乎上看到华为提出的一个VanillaNet,其中的一个设计点和我一直想实现的功能非常类似,即训练阶段的时候模型是比较深的网络,推理的时候会自动变成比较浅的网络。起初我一直想缓渐地暴力地丢掉卷积层,结果不能如愿,模型性能会在训练阶段的最后几个epoch一直退化,模型变成毫无用处 继续阅读