前言 ChatGPT基本信息&原理 ChatGPT基本信息 研发公司:OpenAI 创立年份:2015年 创立人:马斯克、Sam Altman及其他投资者 目标:造福全人类的AI技术 GPT(Generative Pre-trained Transformer):生成式预训练语言模型 GPT作用:问答,生成文章等 模型发展史 参数量(单位:亿) 预训练数据量( 继续阅读

Search Results for: 原模型参数不变

查询到最新的12条

雷军入局!小米大模型拼图会志在何方?

原创 | BFT机器人 OpenAI发布的ChatGPT,凭借海量参数与训练数据加持的惊人语言生成能力,引发了人工智能领域的热潮。ChatGPT的强大实力令业界瞩目,推动了科技企业在大语言模型的布局。 Google在2018的BERT模型,标志着预训练语言模型的兴起,近期发布的T5模型在抽象性和广泛适用性上超越了BERT;FaceBook的Bart模型性能也不逊色;在国内࿰ 继续阅读

从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进...

图文原创:亲爱的数据 “参数服务器之父” Alex Smol教授已于2023年2月从美国著名公有云厂商亚马逊云科技(AWS)离职,创办了一家名为Boson.ai的人工智能公司。 公元2023年的春天,显然也是人工智能的又一春。 Alex Smol教授重新出发并在领英公布了新目标: “scalable foundation models”(可扩展基础模型)。 这类厂商可被视为Cha 继续阅读

聊聊当下火热的通用人工智能--ChatGPT引爆的大模型时代

前言 目前人工智能领域实在是IT界火热的名字,使IT、互联网又火热了一把,与以往不同,这次着实让模型、算法、AI、大模型、超大规模训练、千亿级参数等不绝于耳。作为一个入门,下面进行一些简单的学习总结 ChatGPT——目前还只能是GPT ChatGPT(全名:Chat Generative Pre-trained Transformer),美国OpenAI 研发的聊天机器人程序& 继续阅读

ChatGPT 常见错误原因及解决方案:报错、回答不完整、网络错误等

文章目录使用注意遇到的错误常见错误请求过多回答不完整拒绝回答模型过载或引擎不存在导致错误的原因问的问题太专业了连续问了很多次重复问题句子太长网络错误请求太多长时间不用报错出现错误怎么办 使用注意 众所周知,ChatGPT 非常火爆,很多时候被限流,建议大家寻找平替,或尽量在白天访问,晚上会和另一个半球的活跃用户同时使用,非常容易无法访问和使用。 遇到的错误 常见错误 An error oc 继续阅读

【Java高级语法】(十二)可变参数:Java中的“可变之美“,做好这些细节,你的程序强大又灵活~

Java高级语法详解之可变参数 🔹 前言1️⃣ 概念2️⃣ 优势和缺点3️⃣ 特征和应用场景3.1 特征3.2 应用场景 4️⃣ 使用和原理5️⃣ 使用技巧5.1 可变参数结合泛型5.2 使用元组或列表进行参数传递5.3 使用默认值5.4 缓存计算结果 6️⃣ 实战:构建动态日志工具🌾 总结 🔹 前言 你是不是曾经为了传递不确定数量的参数而纠结不已?在Java编程领域,我们常常遭遇需 继续阅读

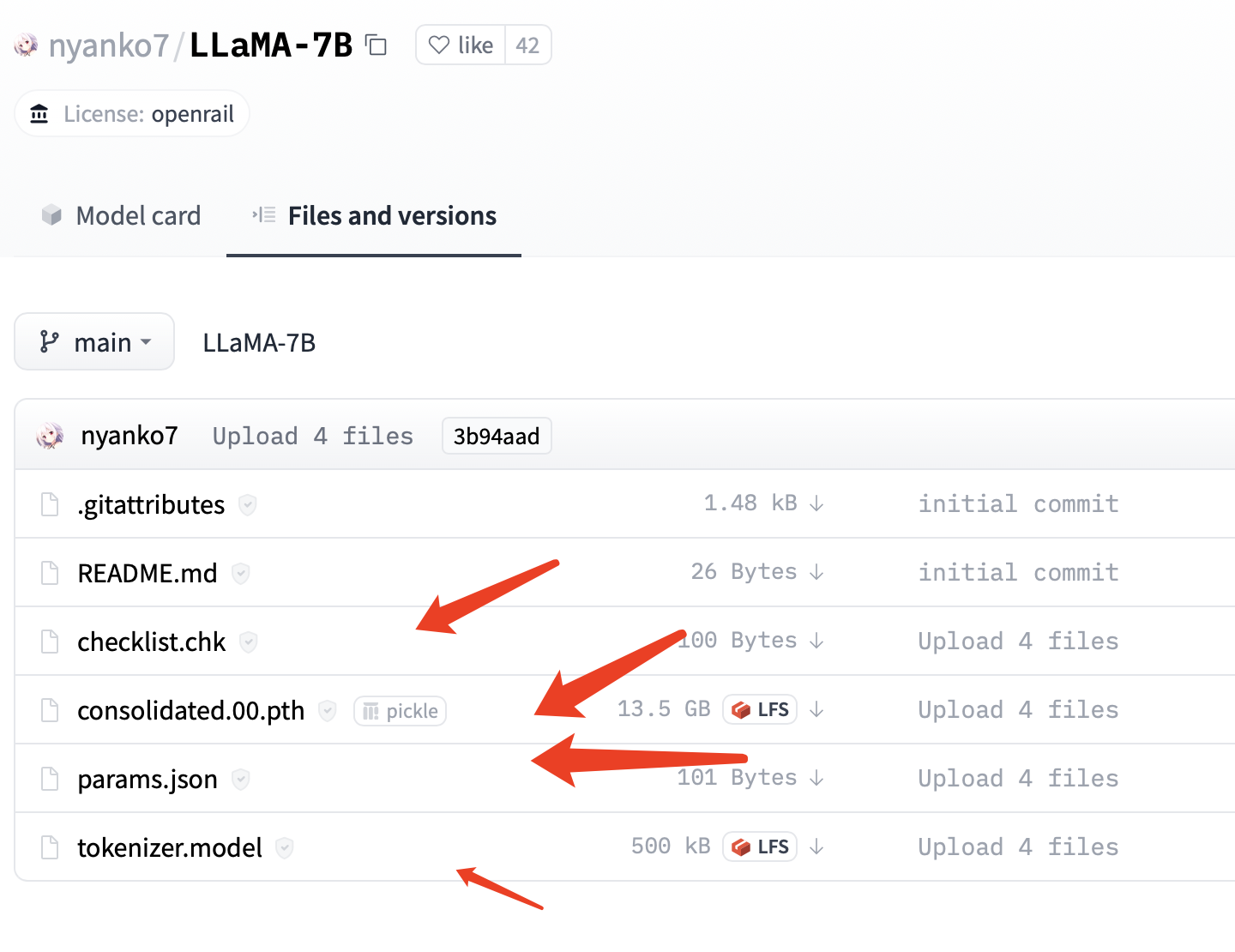

国内首个类 ChatGPT 模型:复旦大学 MOSS 今日正式开源,RTX 3090 显卡可运行

4 月 21 日消息,复旦大学自然语言处理实验室开发的新版 MOSS 模型今日正式上线,成为国内首个插件增强的开源对话语言模型。 目前,MOSS 模型已上线开源,相关代码、数据、模型参数已在 Github 和 Hugging Face 等平台开放,供科研人员下载。 据介绍,MOSS 是一个支持中英双语和多种插件的开源对话语言模型,moss-moon 系列模型具有 160 亿参数&# 继续阅读

ChatGPT实现的技术原理有哪些?

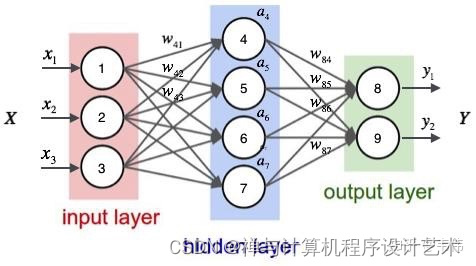

ChatGPT实现的技术原理 作为一种大型语言模型,ChatGPT的技术原理主要基于人工神经网络和自然语言处理技术。 ChatGPT使用了前馈神经网络(feedforward neural network)和递归神经网络(recurrent neural network)的结合来构建深度神经网络模型。这个模型包括多个隐藏层,每个隐藏层都包含多个神经元。 ChatGPT的训练数据主要来自于海量的互联网文本&# 继续阅读

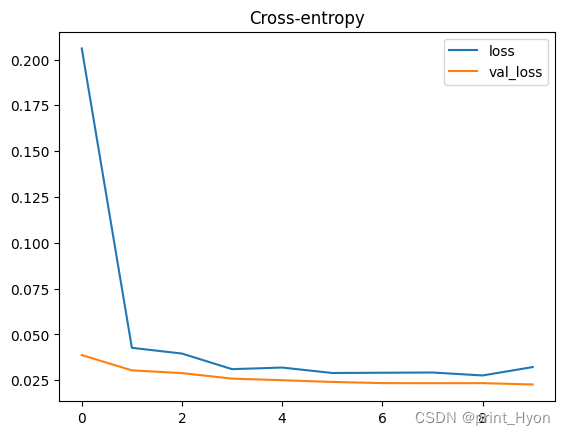

【机器学习】机器故障的二元分类模型-Kaggle竞赛

竞赛介绍 数据集描述 本次竞赛的数据集(训练和测试)是从根据机器故障预测训练的深度学习模型生成的。特征分布与原始分布接近,但不完全相同。随意使用原始数据集作为本次竞赛的一部分,既可以探索差异,也可以了解在训练中合并原始数据集是否可以提高模型性能。 文件 训练.csv - 训练数据集; 是(二进制)目标(为了与原始数据集的顺序保持一致,它不在最后一列位置࿰ 继续阅读

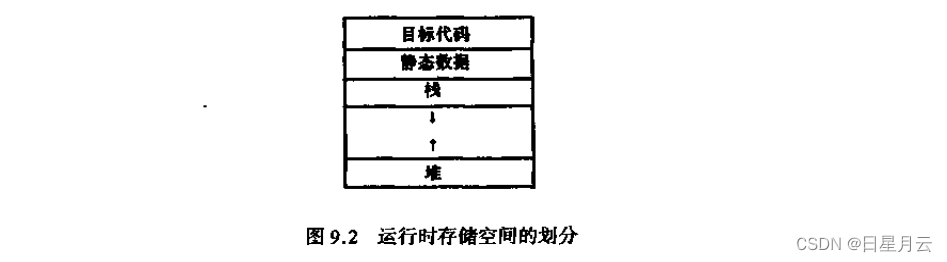

第九章 总结及作业(4)【编译原理】

第九章 总结及作业(4)【编译原理】 前言推荐第九章 运行时存储空间组织9.1 目标程序运行时的活动9.1.1过程的活动9.1.2参数传递 9.2 运行时存储器的划分9.2.1运行时存储器的划分9.2.2 活动记录9.2.3 存储分配策咯 9.3 静态存储分配9.3.1数据区*9.3.2公用语句的处理*9.3.3等价语句的处理9.3.4 地址分配9.3.5 临时变量的地址分配 9.4 简单的栈式存储分配9.4.1C的活动记录9.4.2C的过程调用、过程进入、数组 继续阅读

什么是循环神经网络模型?

引言 随着人工智能技术的不断发展,越来越多的应用需要使用深度学习模型来解决。然而,传统的深度学习模型在处理一些复杂的问题时,往往会出现过拟合的情况,导致模型的性能下降。为了解决这个问题,循环神经网络模型应运而生。本文将介绍循环神经网络模型的基本原理、训练方法、应用场景以及优化策略。 一、循环神经网络模型的基本原理 神经网络模型是一种模拟人类神经系统的机器学习模型,可以用于解决各种问题,例如图像识别、自然语言处理、语音识别、推荐系统等等。神经网络模型由多个神经元组成,每个神经 继续阅读

本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿、130亿、330亿和650亿这4种参数规模的模型,参数是指神经网络中的权重和偏置等可调整的变量,用于训练和优化神经网络的性能,70亿意味着神经网络中有70亿个参数,由此类推。 在一些大型神经 继续阅读