ChatGLM-6b初步微调实验 chatglm-6b微调/推理, 样本为自动生成的整数/小数加减乘除运算, 可gpu/cpu chatglm-6b fine-tuning/inference, The sample is an automatically generated, integer/decimal of add, sub, mul and div operation, that can be gpu/cpu 项目地址 https://github.com/yongzhuo/ch 继续阅读

Search Results for: 6b初步微调实验

查询到最新的12条

一种平价的chatgpt实现方案,基于清华的 ChatGLM-6B + LoRA 进行finetune.(ai

** 清华大学的chatglm-6b开源模型对话能力虽然能基本满足对话需求,但是针对专业领域和垂直领域回答显得智商捉急,这个时候就需要进行微调来提升效果,但是但是同学们显卡的显存更捉急,这时候一种新的微调方式诞生了,现在大火的ai作画里面的lora训练方式直接应用到微调里面,chatglm-lora方式进行微调** 下面是是教程和注意事项 第一步 下载代码 git clone https://github.c 继续阅读

史上最大图灵测试实验完成150万人类参与1000万次对话,判断对面是人还是AI

本文 介绍 了AI 21实验室推出了一个好玩的社交图灵游戏——「人类还是机器人?」 【导读】这个「人类还是AI?」的游戏一经推出,就被广大网友们玩疯了!如今全世界已有150万人参与,网友们大方分享自己鉴AI的秘诀。 历上规模最大的图灵测试,已经初步有结果了! 今年4月中旬,AI 21实验室推出了一个好玩的社交图灵游戏——「人类还是机器人?」。 继续阅读

人类精英呼吁暂停AI实验 ChatGPT:合理但谨慎考虑

3月29日,非营利组织“未来生命研究所(Future of Life Institute)”发表了一封题为“暂停巨型AI实验”的公开信,呼吁全球的AI实验室暂停训练比GPT-4更强大的系统至少6个月,并在此期间开发出一份针对AI的共享安全协议,必要时需要政府介入。 1000多名科技人士在这份公开信上签名,包括特斯拉CEO马斯克、Stability AI 的CEO Emad Mostaque等企 继续阅读

网络层实验报告

计算机网络综合实训 实训报告二 所在院系 计算机与信息工程学院 学科专业名称 计算机科学与技术 导师及职称 柯宗武 教授 提交时间 2022.3.29 网络层实验报告 (湖北师范大学计算机与信息工程学院 中国 黄石 435002) 1 IP分析 1.1背景知识 1.1.1 什么是IP协议 IP是英文Internet Protocol(网际互连协议)的缩写,是TCP/IP体系中的网络层协议,目前常用的版本 继续阅读

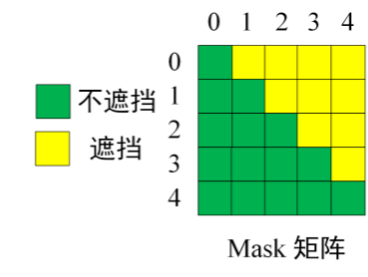

《自然语言处理》第二次实验:机器翻译(Seq2Seq中英文翻译实验)

文章目录 任务一:按照实验手册进行Seq2Seq中英文翻译实验步骤 1 进入ModelArts开发环境步骤 2 下载自然语言处理包步骤 3 上传实验数据步骤 4 进入Notebook实验环境步骤 1 导入实验所需的第三方模块步骤 2 设置运行环境步骤 3 查看数据内容步骤 4 定义数据预处理函数步骤 5 获得mindrecord文件步骤 6 超参数设置步骤 7 定义读取mindrecord函数步骤 8 定义GRU单元步骤 9 定义Encoder步骤 10 定义Decoder步骤 11 定义 继续阅读

局域网实验报告

计算机网络综合实训 实训报告一 所在院系 计算机与信息工程学院 学科专业名称 计算机科学与技术 导师及职称 柯宗武 教授 提交时间 2023.3.10 网络层实验报告 (湖北师范大学计算机与信息工程学院 中国 黄石 435002) 1 集线器与交换机的对比实验 1.1 背景知识 (1)冲突域与广播域 冲突域:以太网共享信道的传输机制决定了在网络中只能有一个站点发送数据。如果两个或两个以上站点同时发送数据将发生冲突。虽然以太网在 MA 继续阅读

类ChatGPT项目的部署与微调(下):从ChatGLM-6b到ChatDoctor

前言 随着『GPT4多模态/Microsoft 365 Copilot/Github Copilot X/ChatGPT插件』的推出,绝大部分公司的技术 产品 服务,以及绝大部分人的工作都将被革新一遍 类似iPhone的诞生 大家面向iOS编程 有了App Store现在有了ChatGPT插件/GPT应用商店,以后很多公司 很多人面向GPT编程(很快技术人员分两种,一种懂GPT,一种不懂GPT) 然ChatGPT/GPT 继续阅读

腾讯云部署清华大学ChatGLM-6B实战

简介(来自官方) ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符 继续阅读

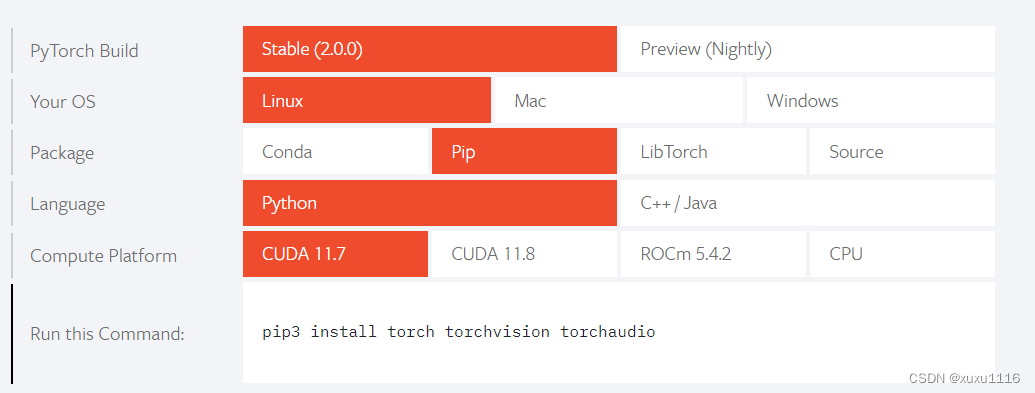

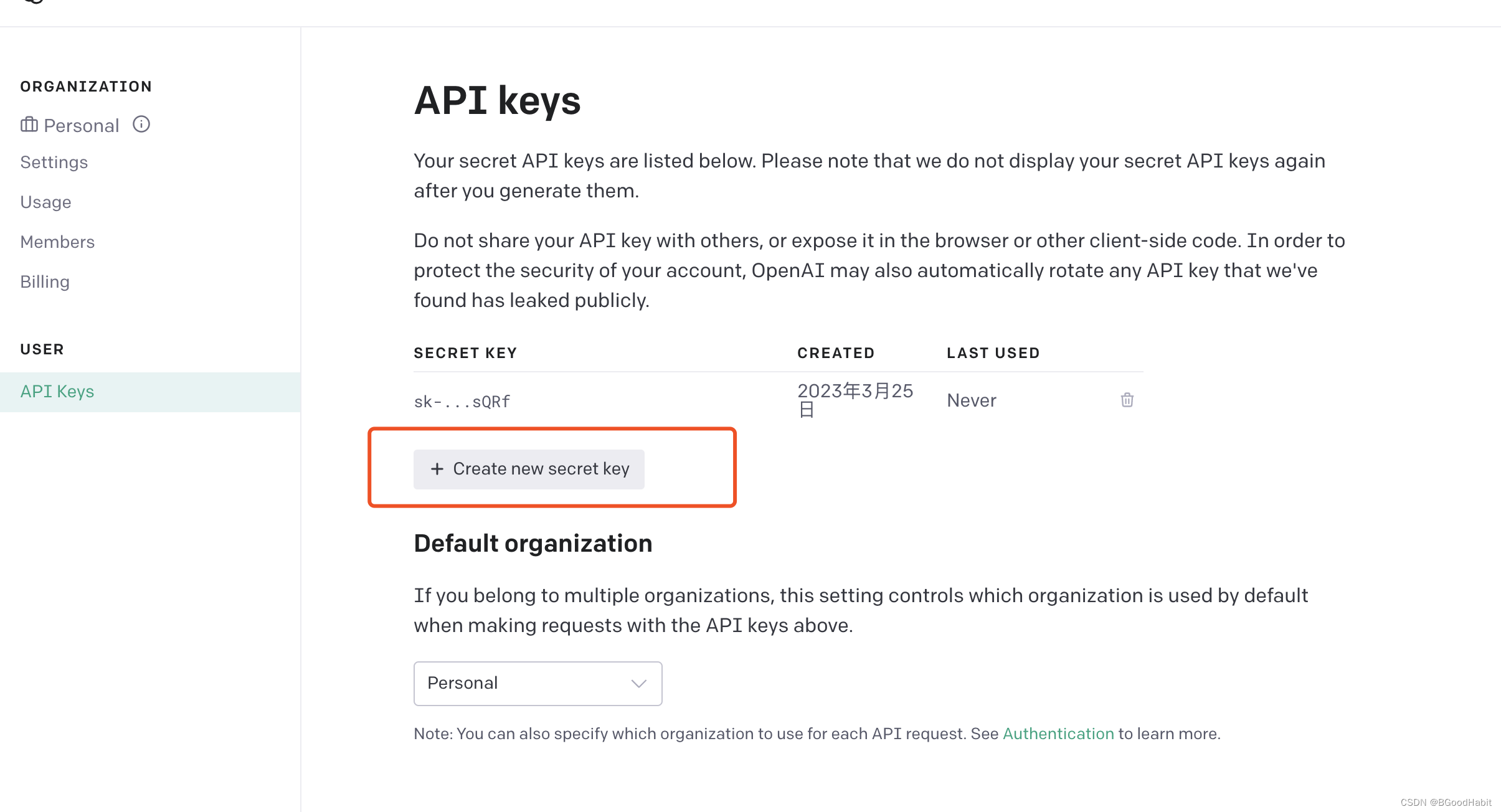

ChatGPT API接口使用+fine tune微调+prompt介绍

目录1 接口调用1.1 生成key1.2 接口功能1.2.1 图片生成 (image generation)1.2.2 对话(chat)1.2.3 中文纠错 (Chinese Spelling Correct)1.2.4 关键词提取 (keyword extract)1.2.5 抽取文本向量 (Embedding)1.2.6 微调 (fine tune)2 如何写好prompt2.1分类任务2.2 归纳总结3.3 翻译2.4 API接口多样性控制3 实用资料 1 接口调用 继续阅读

快速玩转 Llama2!阿里云机器学习 PAI 推出最佳实践(一)——低代码 Lora 微调及部署

本文基于阿里云机器学习PAI实现大语言模型Llama2低代码 Lora 微调及部署,适合想要快速开箱体验预训练模型的开发者 前言 近期,Meta 宣布大语言模型 Llama2 开源,包含7B、13B、70B不同尺寸,分别对应70亿、130亿、700亿参数量,并在每个规格下都有专门适配对话场景的优化模型Llama-2-Chat。Llama2 可免费用于研究场景和商业用途(但月活超过7亿以上的企业需要申请 继续阅读

huggingface - PEFT.参数效率微调

GitHub - huggingface/peft: 🤗 PEFT: State-of-the-art Parameter-Efficient Fine-Tuning. 最先进的参数高效微调 (PEFT) 方法 Parameter-Efficient Fine-Tuning (PEFT) 方法可以使预训练语言模型 (PLM) 高效适应各种下游应用程序,而无需微调模型的所有参数。微调大型 PLM 的成本通常高得令人望而却步。在这方面,PE 继续阅读