Urllib 1.什么是互联网爬虫? 如果我们把互联网比作一张大的蜘蛛网,那一台计算机上的数据便是蜘蛛网上的一个猎物,而爬虫程序就是一只小蜘蛛,沿着蜘蛛网抓取自己想要的数据 解释1:通过一个程序,根据Url(http://www.taobao.com)进行爬取网页,获取有用信息 解释2:使用程序模拟浏览器,去向服务器发送请求,获取响应信息 继续阅读

Search Results for: url请求头信息

查询到最新的12条

全网最详细中英文ChatGPT-GPT-4示例文档-信息智能提取从0到1快速入门——官网推荐的48种最佳应用场

从0到1快速入门信息智能提取应用场景Introduce 简介setting 设置Prompt 提示Sample response 回复样本API request 接口请求python接口请求示例node.js接口请求示例curl命令示例json格式示例其它资料下载 ChatGPT是目前最先进的AI聊天机器人,它能够理解图片和文字,生成流畅和有趣的回答。如果你想跟上AI时代的潮流,你一定要学会使用ChatGPT。如果你想了解OpenAI最新发 继续阅读

nginx/apache/php隐藏http头部版本信息的实现方法

1、nginx隐藏头部版本信息方法 编辑nginx.conf配置文件,在http{}内增加如下一行 复制代码 代码如下: http { …… server_tokens off; …… } 编辑php-fpm配置文件,fastcgi.conf或fcgi.conf 继续阅读

ChatGPT OpenAPI 接入

请注意,在实际使用中,需要使用 API 密钥,并根据 API 文档中的信息调用正确的端点和参数。 基础信息 Base URL: https://api.chatgpt.com/v1/认证方式: API Key 认证信息 您需要在 API 请求中包含您的 API 密钥以进行身份验证。 请求头(Headers): Authorization: Bearer YOUR_API_KEY 端点列表 客户服务端点 继续阅读

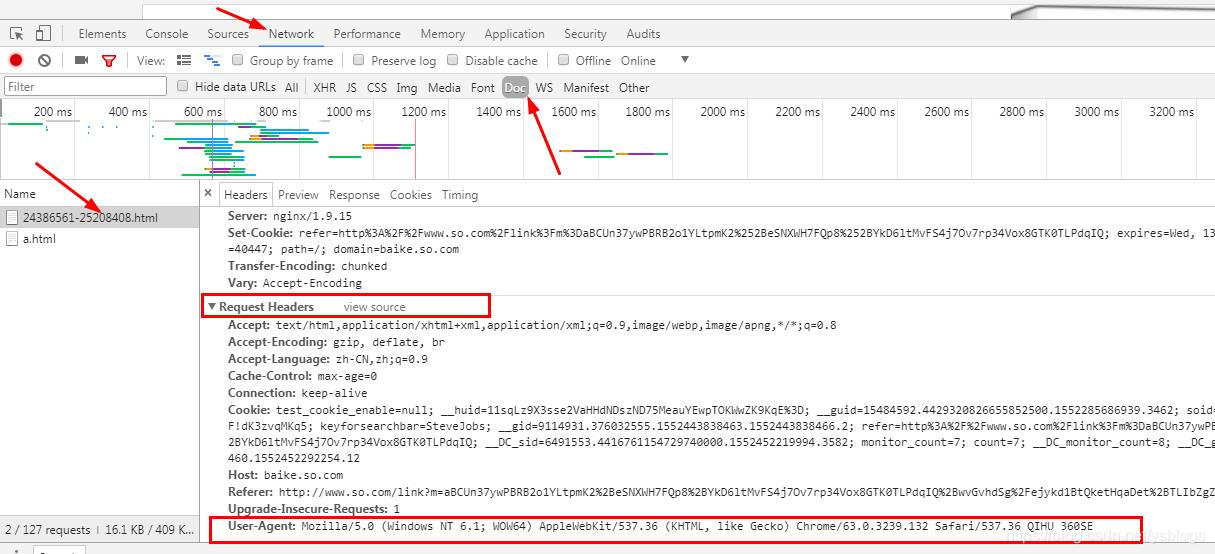

Python爬虫中Requests设置请求头Headers的方法

1、为什么要设置headers? 在请求网页爬取的时候,输出的text信息中会出现抱歉,无法访问等字眼,这就是禁止爬取,需要通过反爬机制去解决这个问题。 headers是解决requests请求反爬的方法之一,相当于我们进去这个网页的服务器本身,假装自己本身在爬取数据。 对反爬虫网页,可以设置一些headers信息,模拟成浏览器取访问网站 。 2、 headers在哪里找? 谷歌或者火狐浏览器,在网页面上点击:右键–> 继续阅读

Linux | 如何使用 cURL 发送 POST 请求

1 概述 Curl 是一个命令行实用程序,允许用户创建网络请求。Curl 在 Windows、 Linux 和 Mac 上皆可使用,这使它成为开发人员的首选。 在本文中,我们将解释如何使用 cURL 发出 POST 请求。使用 HTTP POST 方法向远程服务器发送数据。 2 发送一个 POST 请求 命令的形式如下: curl -X POST [options] [URL] X 选项,指定与远程服务器通信时 继续阅读

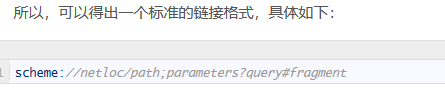

python爬虫(一)urllib.request库学习总结

一.简单介绍 urllib库:是python的内置请求库,常用于网页的请求访问。 包括以下模块: urllib.request 请求模块 urllib.error 异常处理模块 urllib.parse url解析模块 urllib.robotparser robots.txt解析模块 二.实践操作 (1)针对含参数访问 import urllib.request import urllib.parse import 继续阅读

php爬取天猫和淘宝商品数据

一、思路 最近做了一个网站用到了从网址爬取天猫和淘宝的商品信息,首先看了下手机端的网页发现用的react,不太了解没法搞,所以就考虑从PC入口爬取数据,但是当爬取URL获取数据时并没有获取价格,库存等的信息,仔细研究了下发现是异步请求了另一个接口,但是接口要使用refer才能获取数据,于是就通过以下方式写了一个简单的爬虫,用于爬取商品预览图和商品的第一个分类的价格、库存等。 二、实现 代码如下: php;" > function crawlUrl($url){ impor 继续阅读

微信图片消息 服务器故障,解决图片上传到微信服务器后无法显示问题

标签:attr ict viewport 使用 完全 example cache ber copy vue项目里可以添加到app.vue 关于referrer 在页面引入图片、JS 等资源,或者从一个页面跳到另一个页面,都会产生新的 HTTP 请求,浏览器一般都会给这些请求头加上表示来源的 Referrer 字段。Referrer 在分析用户来源时很有用,有着广泛的使用。但 URL 可能包含 继续阅读

【kali学习笔记】信息收集之搜索引擎的使用技巧

一、Google 搜索引擎的使用技巧 1、Google 常用语法说明 site 指定域名 inurl URL 中存在的关键字页面 intext 网页内容里面的关键字 Filetype 指定文件类型 intitle 网页标题中的关键字 link 返回你所有的指定域名链接 info 查找指定站点信息 cache 搜索 Google 里的内容缓存 2、技巧 技巧 1:inurl,拆开来,就是 in url ,它的作用是限定在 url 中搜 继续阅读

pip install requests_爬虫_Day 6 学习requests库这一篇文章足够

目录requests安装requests使用get请求requests伪装头信息requests使用ip代理request使用post请求request设置超时参数request忽略ssl证书验证requests携带cookies请求并利用selenium获取cookies1.安装在ubuntu中 Ctrl+Alt+T 进入终端,输入pip3 install request如果安装比较慢可以使用清华的镜像源在终端中输入pip3 install requests -i https: 继续阅读

nginx rewrite 实现URL跳转的方法

最近工作中常常要改nginx配置,学习了nginx中rewrite的用法 URL跳转 这里说的URL跳转就是用户在访问一个URL时将其跳转到另一个URL上。 常见的应用场景是让多个域名跳转到同一个URL上,(例如让旧域名跳转到新域名上) 将静态文件请求跳转到cdn上等 根据用户设备跳转到不同站点(pc版,wap版)等。 URL跳转可以通过js在页面上设置的window.location实现 也可以通过php设置heade 继续阅读