前言 ChatGPT基本信息&原理 ChatGPT基本信息 研发公司:OpenAI 创立年份:2015年 创立人:马斯克、Sam Altman及其他投资者 目标:造福全人类的AI技术 GPT(Generative Pre-trained Transformer):生成式预训练语言模型 GPT作用:问答,生成文章等 模型发展史 参数量(单位:亿) 预训练数据量( 继续阅读

Search Results for: 原模型参数冻结一部分参数

查询到最新的12条

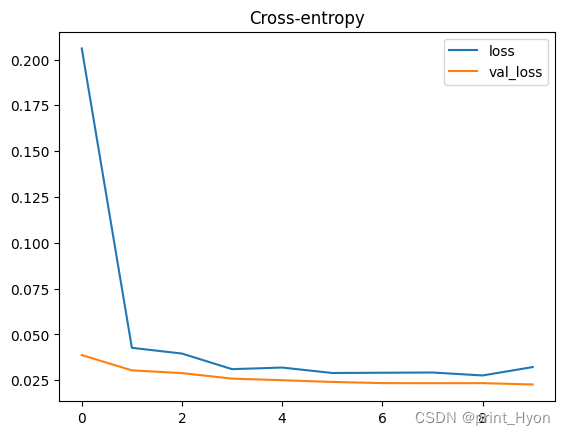

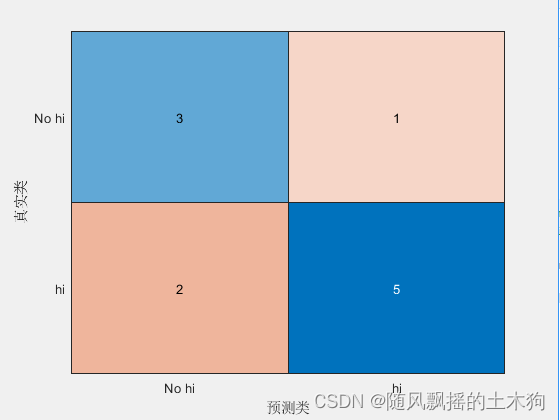

【机器学习】机器故障的二元分类模型-Kaggle竞赛

竞赛介绍 数据集描述 本次竞赛的数据集(训练和测试)是从根据机器故障预测训练的深度学习模型生成的。特征分布与原始分布接近,但不完全相同。随意使用原始数据集作为本次竞赛的一部分,既可以探索差异,也可以了解在训练中合并原始数据集是否可以提高模型性能。 文件 训练.csv - 训练数据集; 是(二进制)目标(为了与原始数据集的顺序保持一致,它不在最后一列位置࿰ 继续阅读

从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进...

图文原创:亲爱的数据 “参数服务器之父” Alex Smol教授已于2023年2月从美国著名公有云厂商亚马逊云科技(AWS)离职,创办了一家名为Boson.ai的人工智能公司。 公元2023年的春天,显然也是人工智能的又一春。 Alex Smol教授重新出发并在领英公布了新目标: “scalable foundation models”(可扩展基础模型)。 这类厂商可被视为Cha 继续阅读

神经网络笔记

多分类问题 Softmax 高级优化算法 Adam Algorithm Intuition 每个参数有不同的学习率 卷积层 每个神经元只看前一层输入的一部分 原因: 1.更快的计算 2.需要更少的训练数据(不容易过度拟合) 模型评估 成本函数 分类 训练集用来训练参数w和b,而测试集用来选择多项式模型(即参数d),训练集不能评估w和b的好坏,类似的测 继续阅读

雷军入局!小米大模型拼图会志在何方?

原创 | BFT机器人 OpenAI发布的ChatGPT,凭借海量参数与训练数据加持的惊人语言生成能力,引发了人工智能领域的热潮。ChatGPT的强大实力令业界瞩目,推动了科技企业在大语言模型的布局。 Google在2018的BERT模型,标志着预训练语言模型的兴起,近期发布的T5模型在抽象性和广泛适用性上超越了BERT;FaceBook的Bart模型性能也不逊色;在国内࿰ 继续阅读

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的评估度量介绍 网格搜索、随机搜索和贝叶斯优化是寻找机器学习模型参数最佳组合、交叉验证每个参数并确定哪一个参数具有最佳性能的常用方法。 一、 评估指标 1、分类 1.1 准确性 1.2 精度 1.3 召回 1.4 F1值 1.5 F0.5值 1.6 F2值 1.7 计算评估指标的功能 2、回归 2.1 平均绝对误差 2.2 均方误差 2.3 均方根误差 二、 基于F1值执 继续阅读

大模型时代来临,智能文档处理该走向何方?

自去年ChatGPT发布以来,大语言模型(Large Language Model, LLM)的发展仿佛瞬间驶入了快车道,每天都能听到对相关话题的讨论。 按照现行的标准,能被称为大语言模型至少要满足以下四个条件: 模型:基于自回归语言模型,参数量超过百亿。能力:具有思维链、情景学习等涌现能力,能够执行人类的指令。对话:可以直接和人类 继续阅读

Azure OpenAI 官方指南04|Codex的模型结构和应用场景

Codex 是 OpenAI 公司推出的 GPT-3(Generative Pre-trained Transformer – 3)的多个派生模型之一。它是基于GPT语言模型,使用代码数据进行 Fine-Tune(微调)而训练出的专门用于代码生成/文档生成的模型。Codex 模型参数从12M到12B不等,是目前最强的编程语言预训练模型。Codex 能够帮助程序员根据函数名和注释自动补全代码、直接生成代码、自动 继续阅读

ChatGPT模型中的惩罚机制

ChatGPT模型中的惩罚机制 上一篇文章《ChatGPT模型采样算法详解》为大家详细介绍了对文本生成效果至关重要的的2种采样方法,以及他们的控制参数temperature和top_p的作用。ChatGPT中,除了采样,还有惩罚机制也能控制文本生成的多样性和创意性。本文将详细为大家讲解ChatGPT种的两种惩罚机制,以及对应的frequency_penalty 和presence_penalty 参数。 文章目录概要frequenc 继续阅读

ChatGPT(180篇技术):技术原理、研究框架,实践及发展趋势

数据、算法、模型三轮驱动AI发展,大模型优势显著,ChatGPT成为AI大模型主流方向,GPT开启千亿参数级AI大模型时代,语言、视觉、科学计算等大模型得到了快速发展。 应专注ChatGPT领域的读者要求,同时也是为了方便读者全面学习ChatGPT/AIGC技术,笔者从海量参考文献中进行严选,最终梳理出180+篇ChatGPT技术干货(持续更新)࿰ 继续阅读

【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型

Chinchilla:训练计算利用率最优的大语言模型 《Training Compute-Optimal Large Language Models》 论文地址:https://arxiv.org/pdf/2203.15556.pdf 一、简介 近期出现了一些列的大语言模型(Large Language Models, LLM),最大的稠密语言模型已经超过了500B的参数。这些大的自回归transformers已经在各个任务上展现 继续阅读

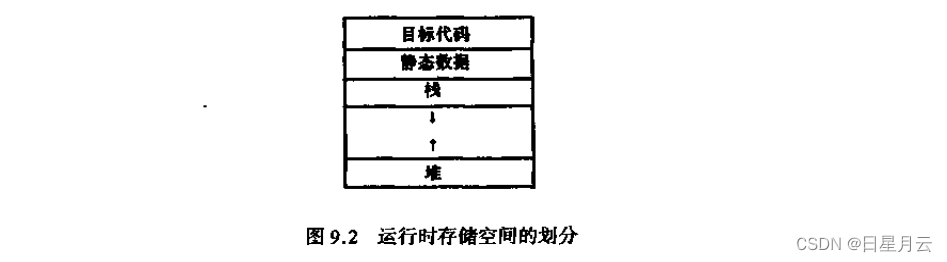

第九章 总结及作业(4)【编译原理】

第九章 总结及作业(4)【编译原理】 前言推荐第九章 运行时存储空间组织9.1 目标程序运行时的活动9.1.1过程的活动9.1.2参数传递 9.2 运行时存储器的划分9.2.1运行时存储器的划分9.2.2 活动记录9.2.3 存储分配策咯 9.3 静态存储分配9.3.1数据区*9.3.2公用语句的处理*9.3.3等价语句的处理9.3.4 地址分配9.3.5 临时变量的地址分配 9.4 简单的栈式存储分配9.4.1C的活动记录9.4.2C的过程调用、过程进入、数组 继续阅读