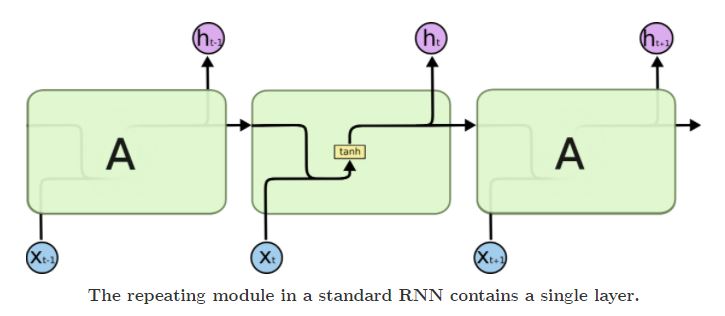

导航LSTM原理GRU原理Seq2Seq架构编码信息损失参考资料 LSTM原理 一般RNN中仅有一个隐藏状态单元hth_tht,且不同时刻的隐藏状态单元的参数是共享的,这种结构导致了RNN存在长期依赖问题,只能对短期输入敏感. LSTM在普通RNN上加入了元胞状态单元ctc_tct,在不同的时刻有着可变的连接权重,ctc_tct通过对hth_tht的调节形成长短期记忆. LSTM引入了门控单元࿰ 继续阅读

Search Results for: LSTM

查询到最新的4条

探索ChatGPT技术在文本生成、机器翻译领域的简单应用

自然语言处理技术——文本生成 ChatGPT的应用领域越来越广泛,关于文本生成,我们可以使用Python中的文本生成库来实现。其中,最常用的是基于深度学习的文本生成模型,如循环神经网络(RNN)和长短时记忆网络(LSTM)。 可以使用Python中的文本生成库来生成文本,例如使用OpenAI的GPT-2模型或者使用TensorFlow的Seq2Seq模型。 模型生成文本Python代码示例 以下是一个使用GPT-2 继续阅读

【人工智能】ChatGPT 技术架构与相关技术栈清单

ChatGPT 技术架构 ChatGPT是一种基于自然语言处理的神经网络模型,它使用了大量的未标注文本数据进行训练,并通过预测文本中下一个词的方式来自我监督。 文章目录 ChatGPT 技术架构自监督预训练模块预训练模型深度学习Transformer模型生成式模型微调模块注意力机制多头自注意力机制基于人类反馈的强化学习与PPO机制残差连接长短时记忆网络(LSTM)词嵌入(Embedding)多层感知器(MLP)梯度下降优化算法自注意力机制序列到序列模型 继续阅读

深入理解深度学习——BERT(Bidirectional Encoder Representations fr

分类目录:《深入理解深度学习》总目录 BERT是由堆叠的Transformer Encoder层组成核心网络,辅以词编码和位置编码而成的。BERT的网络形态与GPT非常相似。简化版本的ELMo、GPT和BERT的网络结构如下图所示。图中的“Trm”表示Transformer Block,即基于Transformer的特征提取器。 ELMo使用自左向右编码和自右向左编码的两个LSTM网络,分别以 P ( w i ∣ w 1 , w 继续阅读