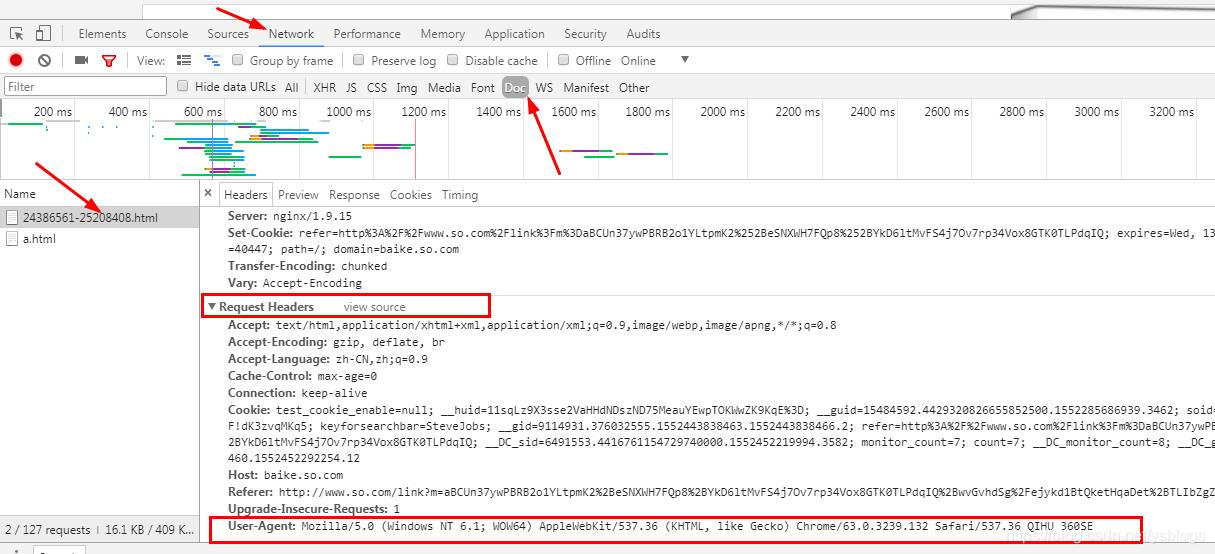

1、为什么要设置headers? 在请求网页爬取的时候,输出的text信息中会出现抱歉,无法访问等字眼,这就是禁止爬取,需要通过反爬机制去解决这个问题。 headers是解决requests请求反爬的方法之一,相当于我们进去这个网页的服务器本身,假装自己本身在爬取数据。 对反爬虫网页,可以设置一些headers信息,模拟成浏览器取访问网站 。 2、 headers在哪里找? 谷歌或者火狐浏览器,在网页面上点击:右键–> 继续阅读

Search Results for: Requests

查询到最新的7条

pip install requests_爬虫_Day 6 学习requests库这一篇文章足够

目录requests安装requests使用get请求requests伪装头信息requests使用ip代理request使用post请求request设置超时参数request忽略ssl证书验证requests携带cookies请求并利用selenium获取cookies1.安装在ubuntu中 Ctrl+Alt+T 进入终端,输入pip3 install request如果安装比较慢可以使用清华的镜像源在终端中输入pip3 install requests -i https: 继续阅读

ChatGPT报错“Too many requests in 1 hour.Try again later“

如果您在使用ChatGPT时出现了“Too many requests in 1 hour. Try again later”(一小时内请求过多,请稍后再试)的错误提示,可能是因为您在短时间内发送了过多的请求。 ChatGPT是一个公共API,许多人都在使用它来获取自然语言生成服务。为了保证公共服务的平稳运行,OpenAI设置了一些限制,包括每小时最多可以发送的请求次数(普通版估计每小时 100 继续阅读

“Authorization“, “Bearer “

public string GetWebRequestStringBearer(string postUrl, string paramData, Encoding dataEncode) { string ret = string.Empty; try { //byte[] byteArray = dataEncode.GetBytes(par 继续阅读

[ChatGPT] 429 you are being rate limited

处理费率限制 当您反复调用 OpenAI API 时,您可能会遇到错误消息 429:’Too Many Requests‘ 或 RateLimitError。 这些错误消息来自超出 API 的速率限制。 要查看用于限制并行请求以避免速率限制错误的示例脚本,请参阅 api_request_parallel_processor.py 为什么存在速率限制? 速率限制是 API 的常见做法,它们的实施有几个不同的原因。 继续阅读

Python采集抖音数据

本文将从多个方面详细讲解如何使用Python采集抖音数据,希望本文能对初学者有所帮助。 一、安装必要的包和工具 在采集抖音数据之前,我们需要安装一些必要的包和工具。首先需要安装Python,建议安装最新版本的Python 3。在安装Python之后,我们需要安装一些第三方包,包括requests、pymongo、beautifulsoup4等。 pip install requests pip install pymongo pip install beaut 继续阅读

Python实时数据表格生成

本文将围绕Python如何生成实时数据表格展开讨论。 一、数据采集与处理 1、数据源获取 在生成实时数据表格前,首先需要获取数据源。Python提供了丰富的库和工具来采集数据,比如Requests库可以用于从网页中抓取数据,API可以用于获取其他数据源的数据。 示例代码: import requests response = requests.get('http://example.com/api/data') data = response.json() 继续阅读