本文将针对日常开设 A/B 实验过程中一个不太合理的使用方法——AABB 实验进行详细的解释,告诉大家为什么不建议开 AABB 实验。 在开始之前,先来回顾一下“什么是 A/B 实验”,A/B 实验是针对想调研的问题,提供两种不同的备选解决方案,然后让一部分用户使用方案 A,另一部分用户使用方案 B,最终通过实验数据对比来确定最优方案。 什么是 AABB 实验 众所周知,AB 实 继续阅读

Search Results for: nni进行超参数调优实验

查询到最新的12条

针对电商物流网络包裹应急调运与结构优化问题的解题【思路数据代码详解】

文章目录C 题 电商物流网络包裹应急调运与结构优化问题解题思路数据进行预处理将数据转换为 stationary 数据底部 C 题 电商物流网络包裹应急调运与结构优化问题 (赛题出来以后第一时间在CSDN分享,文章底部) 最新进度在文章最下方卡片,加入获取思路数据代码论文:2023十三届MathorCup交流 电商物流网络由物流场地(接货仓、分拣中心、营业部等)和物流场地之间的运输线路组成,如图 1 所 继续阅读

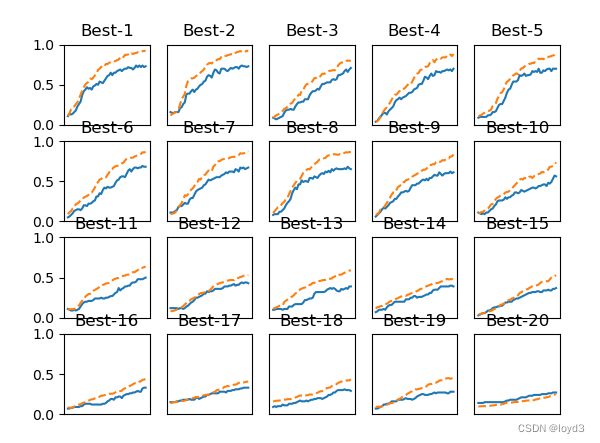

【深度学习】5-5 与学习相关的技巧 - 超参数的验证

超参数指的是,比如各层的神经元数量、batch大小、参数更新时的学习率或权值衰减等。如果这些超参数没有设置合适的值,模型的性能就会很差。 那么如何能够高效地寻找超参数的值的方法 验证数据 之前我们使用的数据集分成了训练数据和测试数据,训练数据用于学习测试数据用于评估泛化能力。 下面要对超参数设置各种各样的值以进行验证。这里要注意的是不能使用测试数据评估超参数的性能。这一点非常重要,但也容易被忽视。为什么不能使用测试数据评估超参数的性能&# 继续阅读

快速玩转 Llama2!阿里云机器学习 PAI 推出最佳实践(一)——低代码 Lora 微调及部署

本文基于阿里云机器学习PAI实现大语言模型Llama2低代码 Lora 微调及部署,适合想要快速开箱体验预训练模型的开发者 前言 近期,Meta 宣布大语言模型 Llama2 开源,包含7B、13B、70B不同尺寸,分别对应70亿、130亿、700亿参数量,并在每个规格下都有专门适配对话场景的优化模型Llama-2-Chat。Llama2 可免费用于研究场景和商业用途(但月活超过7亿以上的企业需要申请 继续阅读

《自然语言处理》第二次实验:机器翻译(Seq2Seq中英文翻译实验)

文章目录 任务一:按照实验手册进行Seq2Seq中英文翻译实验步骤 1 进入ModelArts开发环境步骤 2 下载自然语言处理包步骤 3 上传实验数据步骤 4 进入Notebook实验环境步骤 1 导入实验所需的第三方模块步骤 2 设置运行环境步骤 3 查看数据内容步骤 4 定义数据预处理函数步骤 5 获得mindrecord文件步骤 6 超参数设置步骤 7 定义读取mindrecord函数步骤 8 定义GRU单元步骤 9 定义Encoder步骤 10 定义Decoder步骤 11 定义 继续阅读

OpenCV python sklearn随机超参数搜索的实现

本文介绍了OpenCV python sklearn随机超参数搜索的实现,分享给大家,具体如下: ? 1 2 3 4 5 6 7 继续阅读

ChatGLM-6B does not appear to have a file named config.

文章目录 代码调用演示效果实例一、问题二、场景说明三、error说明四、解决解决一解决二 ChatGLM-6B是一个由清华大学和智谱AI联合研发的开源对话语言模型。它是一个支持中英双语问答的对话系统,并在中文方面进行了特别的优化。 该模型基于General Language Model (GLM)架构,具有62亿参数。借助模型量化技术,用户可以在消费级的显卡上进行本地部署,INT4量化级别下最低只需6GB显存。ChatGLM-6B使用了和ChatGLM相同的技术,针对中文问 继续阅读

体验ChatGPT后,陷入沉思...

1 前言最近 chatGPT 爆火网络,ChatGPT 到底是什么,今天就一起了解和体验一下。ChatGPT 是由OpenAI开发的一个人工智能聊天机器人程序,该程序使用基于GPT-3.5架构的大型语言模型并通过基于人类反馈强化学习进行训练。模型在Microsoft Azure的超级计算机上训练,并通过近端策略优化算法(proximal policy optimization)进行微调。这种策略优化算法比信任域策 继续阅读

平台推广如何管理 平台推广管理流程优化

平台推广管理流程优化 随着互联网的普及,越来越多的公司开始意识到互联网平台推广的重要性。而正确的平台推广管理流程可以使公司的产品或服务迅速被广泛认知,促进公司的发展。本文将从四个方面阐述平台推广如何管理平台推广管理流程优化。 一、定位目标群体 平台推广切入点的选择非常重要,公司的推广对象一定要精准。在定位推广对象时,首先要对市场需求作出准确的判断,了解目标群体,确定推广方向。因此,对于推广对象需要进行充分的调研,定位目标用户群体的兴趣点、 继续阅读

huggingface - PEFT.参数效率微调

GitHub - huggingface/peft: 🤗 PEFT: State-of-the-art Parameter-Efficient Fine-Tuning. 最先进的参数高效微调 (PEFT) 方法 Parameter-Efficient Fine-Tuning (PEFT) 方法可以使预训练语言模型 (PLM) 高效适应各种下游应用程序,而无需微调模型的所有参数。微调大型 PLM 的成本通常高得令人望而却步。在这方面,PE 继续阅读

国产开源类ChatGPT模型,ChatGLM-6b初步微调实验

ChatGLM-6b初步微调实验 chatglm-6b微调/推理, 样本为自动生成的整数/小数加减乘除运算, 可gpu/cpu chatglm-6b fine-tuning/inference, The sample is an automatically generated, integer/decimal of add, sub, mul and div operation, that can be gpu/cpu 项目地址 https://github.com/yongzhuo/ch 继续阅读

CCTV 证券资讯《超越》栏目专访优聚投 CEO 许淏俍

2015年12月30日,优聚投 CEO 许淏俍受邀参加 CCTV 证券资讯《超越》栏目2015年度特别节目选题会,并接受栏目专访。本次选题会是由“国务院新闻办—中国互联网新闻中心”和“中国品牌领袖联盟”指导,“中央电视台”和“中国网”战略支持的。 CCTV 证券资讯频道《超越》栏目是一档金融业特辑节目,立足中国宏观经济,对话中国金融企业,以“新思路、新视角、新见解”把脉中国金融业市场发展趋势,分析市场走向和投资机会,为新经济时代的中国金 继续阅读