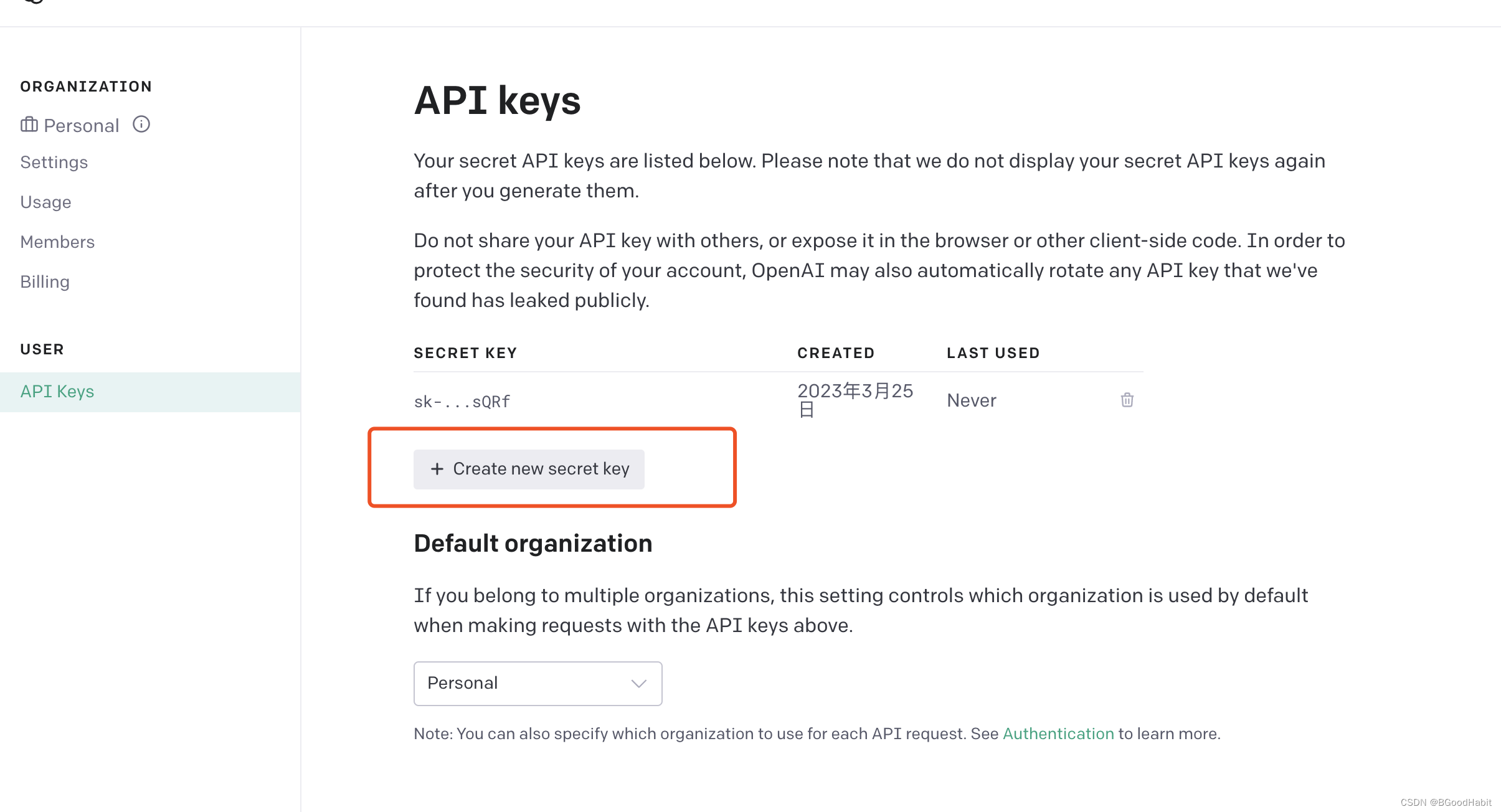

目录1 接口调用1.1 生成key1.2 接口功能1.2.1 图片生成 (image generation)1.2.2 对话(chat)1.2.3 中文纠错 (Chinese Spelling Correct)1.2.4 关键词提取 (keyword extract)1.2.5 抽取文本向量 (Embedding)1.2.6 微调 (fine tune)2 如何写好prompt2.1分类任务2.2 归纳总结3.3 翻译2.4 API接口多样性控制3 实用资料 1 接口调用 继续阅读

Search Results for: tune微调

查询到最新的12条

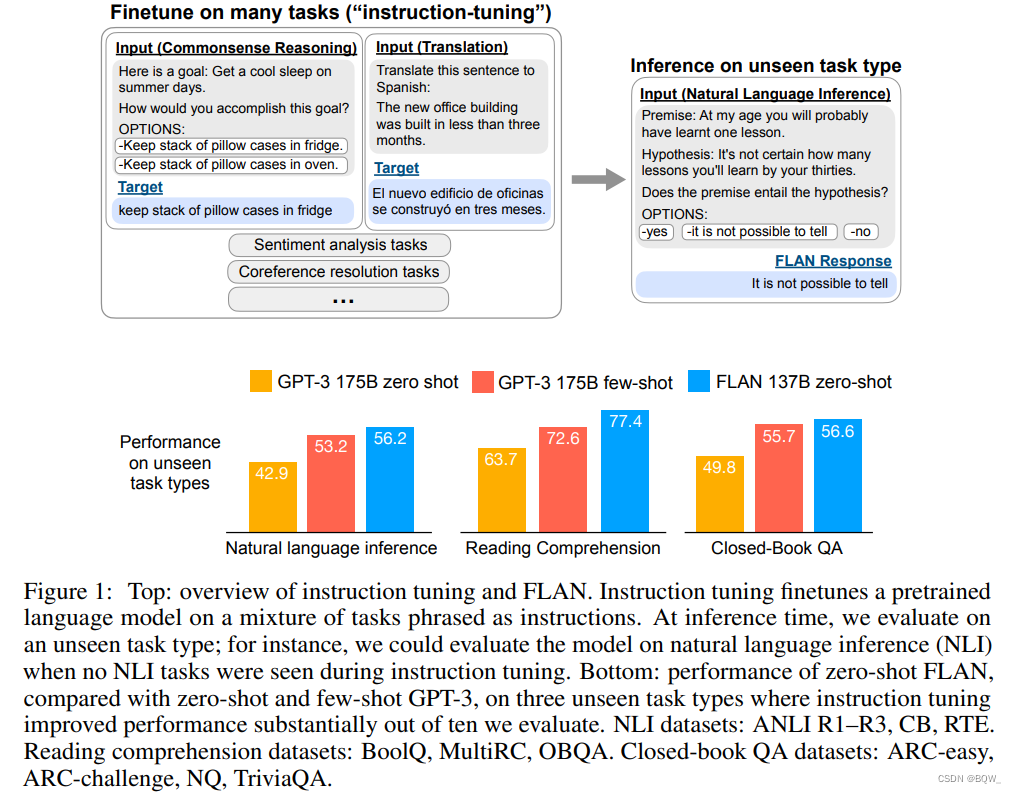

【自然语言处理】【ChatGPT系列】FLAN:微调语言模型是Zero-Shot学习器

FLAN: 微调语言模型是Zero-Shot学习器 《Finetuned Language Models are Zero-shot Learners》 论文地址:https://arxiv.org/abs/2109.01652 一、简介 大语言模型(例如GPT-3\text{GPT-3}GPT-3)已经展现出了非常好的few-shot learning\text{few-shot learning}few-shot learning的能力。然而 继续阅读

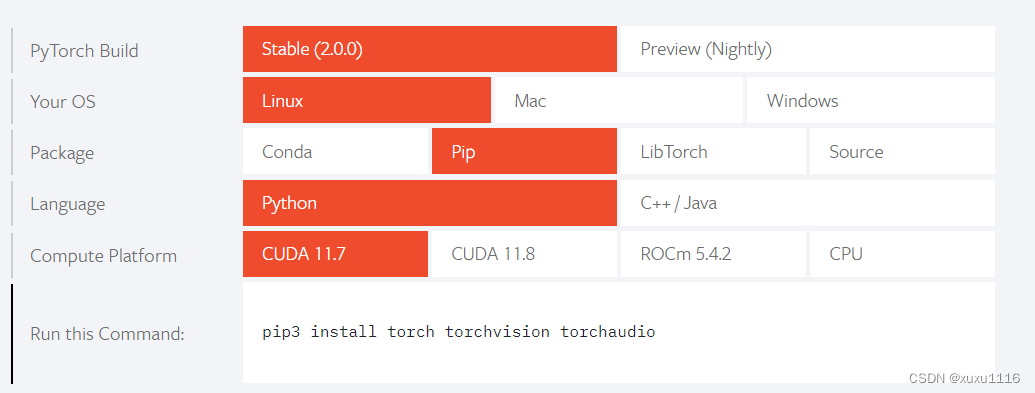

一种平价的chatgpt实现方案,基于清华的 ChatGLM-6B + LoRA 进行finetune.(ai

** 清华大学的chatglm-6b开源模型对话能力虽然能基本满足对话需求,但是针对专业领域和垂直领域回答显得智商捉急,这个时候就需要进行微调来提升效果,但是但是同学们显卡的显存更捉急,这时候一种新的微调方式诞生了,现在大火的ai作画里面的lora训练方式直接应用到微调里面,chatglm-lora方式进行微调** 下面是是教程和注意事项 第一步 下载代码 git clone https://github.c 继续阅读

国产开源类ChatGPT模型,ChatGLM-6b初步微调实验

ChatGLM-6b初步微调实验 chatglm-6b微调/推理, 样本为自动生成的整数/小数加减乘除运算, 可gpu/cpu chatglm-6b fine-tuning/inference, The sample is an automatically generated, integer/decimal of add, sub, mul and div operation, that can be gpu/cpu 项目地址 https://github.com/yongzhuo/ch 继续阅读

chatgpt|安装及示例|聊天|嵌入|微调|适度|图像|音频|异步|API 错误代码-OpenAI Pyth

文章目录OpenAI Python库安装可选依赖项用法参数微软 Azure 端点微软 Azure 活动目录身份验证命令行界面示例代码聊天嵌入微调适度图像生成 (DALL·E)音频转录(Whisper)异步API要求信用TIPS:OpenAI API 错误代码API 错误状态码 概述详细解释 OpenAI Python库 项目git地址 OpenAI Python 库提供了对 OpenAI API 的便捷访问来自用 Python 语言编写的应用程序。它包括一个用于初始化的 API 资源 继续阅读

快速玩转 Llama2!阿里云机器学习 PAI 推出最佳实践(一)——低代码 Lora 微调及部署

本文基于阿里云机器学习PAI实现大语言模型Llama2低代码 Lora 微调及部署,适合想要快速开箱体验预训练模型的开发者 前言 近期,Meta 宣布大语言模型 Llama2 开源,包含7B、13B、70B不同尺寸,分别对应70亿、130亿、700亿参数量,并在每个规格下都有专门适配对话场景的优化模型Llama-2-Chat。Llama2 可免费用于研究场景和商业用途(但月活超过7亿以上的企业需要申请 继续阅读

Azure OpenAI 官方指南04|Codex的模型结构和应用场景

Codex 是 OpenAI 公司推出的 GPT-3(Generative Pre-trained Transformer – 3)的多个派生模型之一。它是基于GPT语言模型,使用代码数据进行 Fine-Tune(微调)而训练出的专门用于代码生成/文档生成的模型。Codex 模型参数从12M到12B不等,是目前最强的编程语言预训练模型。Codex 能够帮助程序员根据函数名和注释自动补全代码、直接生成代码、自动 继续阅读

huggingface - PEFT.参数效率微调

GitHub - huggingface/peft: 🤗 PEFT: State-of-the-art Parameter-Efficient Fine-Tuning. 最先进的参数高效微调 (PEFT) 方法 Parameter-Efficient Fine-Tuning (PEFT) 方法可以使预训练语言模型 (PLM) 高效适应各种下游应用程序,而无需微调模型的所有参数。微调大型 PLM 的成本通常高得令人望而却步。在这方面,PE 继续阅读

体验ChatGPT后,陷入沉思...

1 前言最近 chatGPT 爆火网络,ChatGPT 到底是什么,今天就一起了解和体验一下。ChatGPT 是由OpenAI开发的一个人工智能聊天机器人程序,该程序使用基于GPT-3.5架构的大型语言模型并通过基于人类反馈强化学习进行训练。模型在Microsoft Azure的超级计算机上训练,并通过近端策略优化算法(proximal policy optimization)进行微调。这种策略优化算法比信任域策 继续阅读

2023-02-18 什么是chatGPT?如何使用chatGPT?chatGPT可以胜任人类当前哪些工作?.

文章目录1.什么是chatGPT?2.如何使用chatGPT?3.chatGPT可以胜任人类当前哪些工作?4.什么是openAI?5,使用示例一:旅游攻略6.使用示例二:AI绘画 1.什么是chatGPT? chatGPT本质上是一个应用在对话场景中的语言模型,它是基于GPT3.5(Generative Pre-trained Transformer,是指一种深度学习模型),通过人类反馈的强化学习微调而来, 它能够回答用户的后续问题,理解自然语言,像人类一样回答问题,与人类进行自然语言 继续阅读

全新的博客之旅,全新的界面设计风格

嗨!老朋友们,别来无恙啊,我又回来了!再一次以写博客为目的装上了WordPress,今天的WordPress也已经更新到了5.3,最新的默认主题叫2020,功能和UI也有了一些微调。记得第一次安装时,默认主题还是2013,但很快就过渡到2014了,具体的版本号已经记不清,能清晰的记得这个默认的主题是因为它那暗黑色的风格在历代默认主题中都显得尤为突出,这也就意味着现在距离我第一次接触WordPress已经有整整6年了,这6年里发生了很多事,所以我想找个地方发发牢骚,存放一些记忆,留 继续阅读

AIGC和ChatGPT的区别

AIGC和ChatGPT的区别主要在于: - AIGC是一个广泛的概念,包括多种类型的内容生成;ChatGPT是一个具体的产品,只涉及文本生成。 - AIGC可以应用在多个领域和场景;ChatGPT主要应用在语言相关的领域和场景。 - AIGC可能需要不同的技术和模型来实现;ChatGPT使用了Transformer作为核心技术和模型。 - AIGC可能需要根据不同的任务进行调整或微调;Ch 继续阅读