最近出现很多ChatGPT相关论文,但基本都是讨论其使用场景和伦理问题,至于其原理,ChatGPT在其主页上介绍,它使用来自人类反馈的强化学习训练模型,方法与InstructGPT相同,只在数据收集上有细微的差别。 那么,InstructGPT和ChatGPT为什么使用强化学习呢?先看个示例: 先不论答案是否正确,回答依赖之前的对话, 继续阅读

Search Results for: 强化学习

查询到最新的12条

ChatGPT 使用 拓展资料:强化学习 策略梯度算法及Actor_Critic算法

ChatGPT 使用 拓展资料:强化学习 策略梯度算法及Actor_Critic算法 策略梯度算法是一类基于梯度的优化算法,用于求解强化学习中的策略函数,即输入状态,输出行动的函数。相对于其他的强化学习算法,策略梯度算法更加适合处理连续行动和高维状态空间的问题。 策略梯度算法的基本思想是通过迭代优化策略函数的参数,来最大化期望回报。在策略梯度算法中,每次迭代中都会收集一些经验数据,例如某一状态下采取某一行动所获得的回报值等,然后使用这些经验数据来计算策略函数的梯度。策略梯度算法的目标就是最大 继续阅读

AI人工智能概念(机器学习,深度学习,强化学习)

我们常常听到人工智能,机器学习,深度学习,神经网络,强化学习,图像识别,语音识别,自然语言处理等等诸多人工智能领域的词汇,今天我们就来梳理一下每个名词的概念以及他们的关系: 人工智能首先使用来解决问题的: 人工智能: 人工智能可以分为很多领域,如:自然语言理解,图像识别,语音识别 继续阅读

ChatGPT 使用 强化学习:Proximal Policy Optimization算法(详细图解)

ChatGPT 使用 强化学习:Proximal Policy Optimization算法 强化学习中的PPO(Proximal Policy Optimization)算法是一种高效的策略优化方法,它对于许多任务来说具有很好的性能。PPO的核心思想是限制策略更新的幅度,以实现更稳定的训练过程。接下来,我将分步骤向您介绍PPO算法。 步骤1:了解强化学习基础 首先,您需要了解强化学习的基本概念,如状态(state)、动作(action)、奖励(reward)、策略(policy)和价值函 继续阅读

RLHF:基于人类反馈(Human Feedback)对语言模型进行强化学习【Reinforcement Le

HuggingFace发表了一篇博客,详细讲解了ChatGPT背后的技术原理——RLHF。 笔者读过之后,觉得讲解的还是蛮清晰的,因此提炼了一下核心脉络,希望给对ChatGPT技术原理感兴趣的小伙伴带来帮助。 此外,文末整理了几篇关于 RLHF 最热门的12篇必读论文,卖萌酱打包好挂在公众号后台了,感兴趣的小伙伴可以在公众号“夕小瑶的卖萌屋”后台回复【1212】领取。 在过去几年里࿰ 继续阅读

做网赚最高效的学习方法

我们每个人都是在不断的学习和成长,展天觉得没有任何一个人可以说他能完全的懂一个行业里面的知识,都是在一个不断学习不断精进的过程中,俗话说的好,活到老学到老,只要人存在着都是一个学习的过程,任何人都一样,没有例外~ 但我发现一个问题,很多人都是漫无目的的学习,看到什么都要学习一下,看到不懂的都要研究一番,我觉得要是按照这个进度下去,那么肯定会一直不断的在学习中?当然也只是在学习。 因为始终没有想过一个问题,我们学习的目的是什么? 就好像很多 继续阅读

什么是版本控制系统?怎么学习? - 易智编译EaseEditing

版本控制系统(Version Control System,简称VCS)是一种用于管理和跟踪文件版本的工具或系统。它可以追踪文件的变更历史,记录每个版本的修改内容,以及支持多人协作开发。 学习版本控制系统可以帮助你更好地管理和控制你的代码和项目,以及提高团队协作效率。以下是学习版本控制系统的一些建议: 选择版本控制系统: 首先,选择适合你需求的版本控制 继续阅读

Python学习思维导图(必看篇)

无意间碰到的一个大神整理的Python学习思维导图,感觉对初学者理清学习思路大有裨益,非常感谢他的分享。 14 张思维导图 基础知识 数据类型 序列 字符串 列表 & 元组 字典 & 集合 条件 & 循环 文件对象 错误 & 异常 函数 继续阅读

Python学习—装饰器的力量

Python学习—装饰器的力量 @dec def func(): pass 在进行装饰器的介绍之前,我们必须先明确几个概念和原则: def foo(): print("foo函数被运行了!") #如果就这么样,foo里的语句是不会被执行的。 #程序只是简单的将定义代码块读入内存中。 # foo() 只有调用了,才会执行 def foo(): print 继续阅读

Datawhale组队学习周报(第034周)

希望开设的开源内容 目前Datawhale的开源内容分为两种:第一种是已经囊括在我们的学习路线图内的Datawhale精品课,第二种是暂未囊括在我们的学习路线图内的Datawhale打磨课。我们根据您的投票来确定精品课程的排期,打磨课程一旦完成,即可排入我们每个月的组队学习。 请选择您十一月份希望学习的Datawhale精品课程。如果某门课程超过100人选择,那么我们就邀请该课程设计者开设该课程的组队学习。 -> 继续阅读

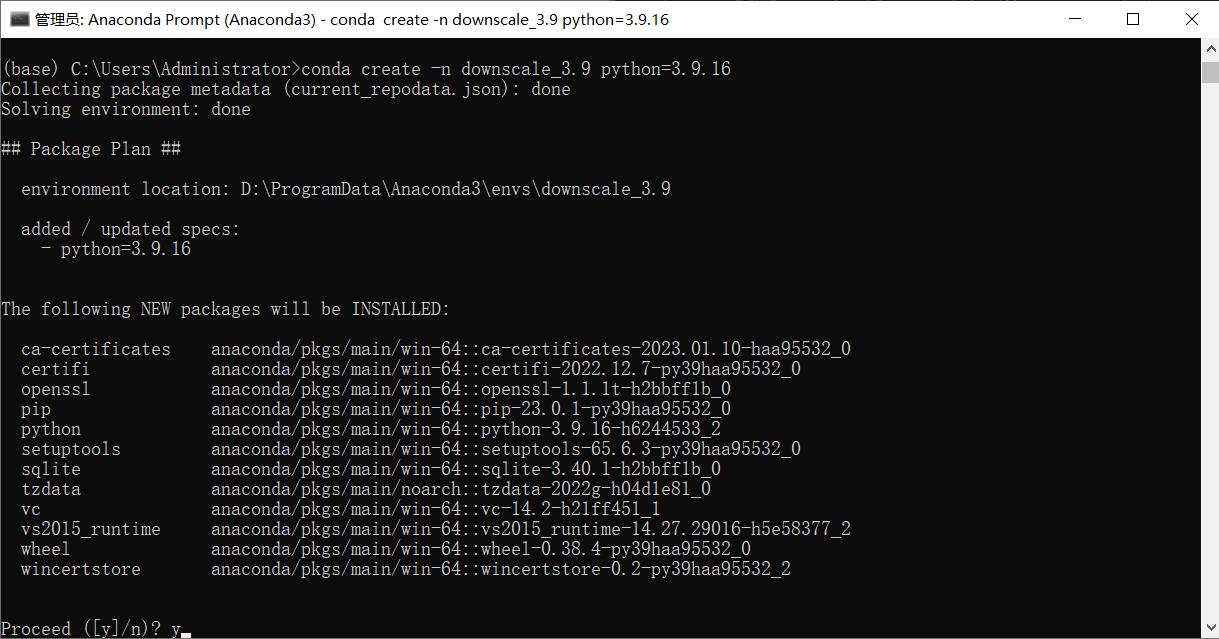

ChatGPT协助配置环境(深度学习降尺度库dl4ds的安装)

最近在研究利用深度学习对气象数据进行降尺度的方法,偶然发现这一篇论文及其提及到的规范化降尺度库,便安装以供实验。GitHub - carlos-gg/dl4ds: Deep Learning for empirical DownScaling. Python package with state-of-the-art and novel deep learning algorithms for empirical/statistical downscaling of 继续阅读

Datawhale组队学习周报(第010周)

本周(04月19日~04月25日),第 24 期组队学习正在如火如荼的进行中。本期组队学习,一共有 5 门开源课程,共组建了 6 个学习群,参与的学习者有 788 人。另外,第 25 期组队学习也蓄势待发准备与大家见面了。我在这里要感谢所有的课程设计人员,以及我们的助教和支持者,因为你们的无私奉献才促成组队学习活动的顺利开展。 所有贡献人员: 正 继续阅读