标题有点长,但是基本也说明出了这篇文章的主旨,那就是利用GPT AI智能回答自己设置好的问题 既能实现自己的AI知识库机器人,又能节省ChatGPT调用的token成本费用。 代码仓库地址 document.ai: 基于GPT3.5的通用本地知识库解决方案 下面图片是整个流程: 导入知识库数据 利用openai的向量接口生成向量数据,然后导入到向量数据库qdrant 这段代码会将指定目录下的所有文件读取出来, 继续阅读

Search Results for: 的本地部署和接口调用

查询到最新的12条

chatGPT:12.12 之后更新的 chatGPT 的本地部署和接口调用,解决 response 403

文章目录问题源代码改动Session token 的获取cf_clearance 的获取user-agent 的获取将 config.json.sample 内容修改并移动位置附注:环境配置python >= 3.7特别提示playwright & cf_clearancerevChatGPT 版本httpxOpenAIAuth删除 import 中的错误后记 问题 因为 chatgpt 在 12.12 号更新了版本,因此整个源代码中增 继续阅读

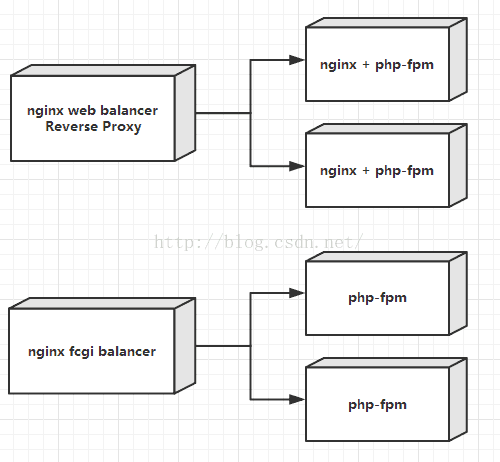

详解Nginx 和 PHP 的两种部署方式的对比

详解Nginx 和 PHP 的两种部署方式的对比 2种部署方式简介 第一种 前置1台nginx服务器做HTTP反向代理和负载均衡 后面N太服务器的Nginx做Web服务,并调用php-fpm提供的fast cgi服务 此种部署方式最为常见,web服务和PHP服务在同一台服务器上都有部署 第二种 前置1台nginx服务器做Web服务 后面服务器只部署php-fpm服务,供ng 继续阅读

使用Nginx反向代理部署laravel和history模式的Vue项目[更新]

[2019.12.2 更新] nginx.conf里要加上对laravel的静态文件目录的转发(这里假设我的静态文件在public/static下)、修改vue的nginx配置。我们以在我本地的开发环境为例,windows7+nginx+Vue+Laravel5,假设我想使用的域名是zh30.com。想达成的效果:我们想直接访问时使用Vue开发的单页面应用index.html,做为我们的前台交互,且在Vue中使用history路由模式。后台和接口使用laravel框架进行开发,所以想使用zh30 继续阅读

【类ChatGPT】本地CPU部署中文羊驼大模型LLaMA和Alpaca

昨天在github上看到一个在本地部署中文大模型的项目,和大家分享一下。先把地址po出来。 项目名称:中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs) 项目地址:https://github.com/ymcui/Chinese-LLaMA-Alpaca 以下是原github中给出的体验GIF,可以看到这个模型还是具备一定的指令理解和上下文对话能力的。 继续阅读

python 计时器_谁能取代Python?我使用Go来部署机器学习模型的原因

图源:unsplash毋庸置疑,Python是如今最受欢迎的机器学习语言。虽然机器学习框架使用CUDA C / C ++之类的语言进行实际运算,但它们都提供了Python接口。这也是为什么大多数机器学习从业人员都工作中都使用Python。而机器学习基础设施——Cortex的代码库88.3%都是Go语言编写的。图源:Cortex GitHub大规模部署模型不同于编写调用PyTorch和TensorFlow函数的P 继续阅读

详细介绍如何调用chatGPT的接口

目录 一、使用官网 1、地址 2、例子 - examples 3、api-reference 1、查询所有model的接口 2、创建聊天 3、画图 4、音频转文字 4、测试场地-playground 二、介绍model 一、使用官网 1、地址 首先登录openai官网,可能需要科学上网 2、例子 - examples 这里是一些官方推荐的例子,一共是48个 点击每个例子,都会弹出一个调用,并 继续阅读

Python函数的创建和调用

1.python函数创建的格式 def 函数名([输入参数]) :函数体[return xx]注意:1.注意缩进2.并不是所有的python都有[]里的内容 2.python函数的创建和调用举例 #假设这个黑板为Pycharm或其他书写代码的软件,在开发环境配置成功的前提下, #以下内容可直接右键运行# 1.函数的创建def Hanshu(a,b) : #这里定义了一个函数名为Hanshu的函数,参数为a 继续阅读

ChatGPT的API接口的模型有多少种?这些模型都有什么功能或者在应用场景上有什么区别?【模型介绍使用与调用

OpenAI 的 API 接口提供了多个 GPT-3 模型,每个模型针对不同的应用场景和任务进行了优化。以下是目前可用的 GPT-3 模型: davinci: 这是最大和最全面的模型,具有最高的准确性和灵活性,用于多种自然语言处理任务,如文本生成、对话系统、翻译等。 curie: 这个模型比 davinci 更快,但在某些任务上可能会稍微逊色。它适用于类似于 davinci 的广泛用途,但需要更快的速度和更低的成本。 babbage: 这个模型比 davinci 和 curie 更小, 继续阅读

NLP之Chatgpt:基于openai框架通过调用API接口实现Chatgpt的吊炸天功能的图文教程(基于p

NLP之Chatgpt:基于openai框架通过调用API接口实现Chatgpt的吊炸天功能的图文教程(基于python代码实现)、案例应用之详细攻略 目录 基于openai框架通过调用API接口实现Chatgpt功能的简介 继续阅读

一文详解!接口自动化的关键思路和解决方案

目录 引言 正文 一.接口传参 二. 外部数据源 三. 测试断言 四. 环境切换 五. 批量测试 总结 一.接口自动化的工具思维和测试思维 二.贯穿整个接口自动化项目的三个基本思路: 引言 与UI相比,接口一旦研发完成,通常变更或重构的频率和幅度相对较小。因此做接口自动化的性价比更高,通常运用于迭代版本上线前的回归测试中。 手工做接口测试,测试数据和参数都可以由测试人员手动填写和更新。 因此 继续阅读

[经验分享]gpt-3.5-Turbo|unity中实现http接口调用gpt新接口以及信息处理的实现案例分享

最近openAI发布了目前chatGPT所使用的模型gpt-3.5-Turbo,之前使用了text-davinci-003模型做了一个galgame的AI女友对话的demo。这次趁着新接口的发布,对这个demo也同步更新了模型调用的代码。本篇文章将分享一下,如何在unity里使用UnityWebRequest实现与openAI的接口调用以及信息处理的示例,希望能够帮助到有需要的朋友。一、gpt-3.5-Turbo官方示例分析①首先我们需要 继续阅读