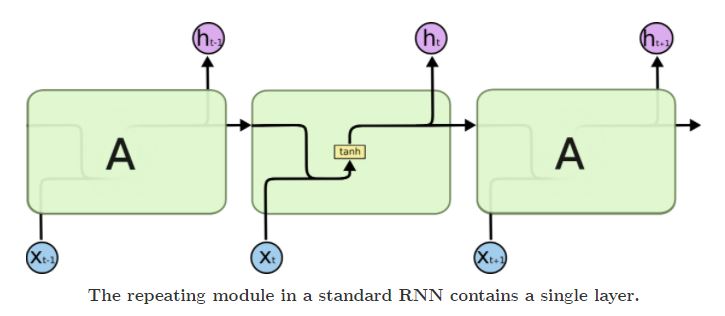

导航LSTM原理GRU原理Seq2Seq架构编码信息损失参考资料 LSTM原理 一般RNN中仅有一个隐藏状态单元hth_tht,且不同时刻的隐藏状态单元的参数是共享的,这种结构导致了RNN存在长期依赖问题,只能对短期输入敏感. LSTM在普通RNN上加入了元胞状态单元ctc_tct,在不同的时刻有着可变的连接权重,ctc_tct通过对hth_tht的调节形成长短期记忆. LSTM引入了门控单元࿰ 继续阅读

Search Results for: 长短

查询到最新的7条

如何快速让文章被收录

事实证明,文章的收录和文章的字数长短没有任何关系。只要你有一个好的标题,好的文案,好的运气,两段话也能被收录!󰄼 赞 7 赏󰄯 分享 继续阅读

月亮还是那么的圆

月亮还是那么的圆 作者:逆时针 | 2015-09-26 | 浏览:539 中秋佳节,工地上的工人们满怀兴奋的心情踏上归乡的路,肩上的背包塞得鼓鼓的,手里还拎着包装精美的月饼盒,望着他们渐行渐远的背影,我拿起手机拨通了家里的电话。 每次和爸妈通电话的时间都非常简短,但开头永远是那几句——“妈!”“嗯,家里很好,你怎么样啊?”“挺好的!”......唠嗑些家里长短,然后就挂了,或许天下的父母都是这样,只要子女在外安好就满足了。 说到中秋节,必然离不开月饼,小的时候,手里捧着一 继续阅读

探索ChatGPT技术在文本生成、机器翻译领域的简单应用

自然语言处理技术——文本生成 ChatGPT的应用领域越来越广泛,关于文本生成,我们可以使用Python中的文本生成库来实现。其中,最常用的是基于深度学习的文本生成模型,如循环神经网络(RNN)和长短时记忆网络(LSTM)。 可以使用Python中的文本生成库来生成文本,例如使用OpenAI的GPT-2模型或者使用TensorFlow的Seq2Seq模型。 模型生成文本Python代码示例 以下是一个使用GPT-2 继续阅读

瞎写碰壁

明明想好了,要早点回宿舍动感单车,但是还是不知不觉的拖到了9点多。明明想好了回到宿舍就不再开电脑做VBA相关的东西,结果还是忍不住,我满脑子都是那个玩意。所以周四的晚上,我又只是匆匆忙忙我完成了一个30分钟的动感单车课程。理论上周三对我来说是动感单车的大课,但实际上我只上了一节15分钟的Y5强度,虽然强度很够意思,但持续时间太长短。周四晚上,本来我打算好好干一场,结果又被时间所限。 周四晚上11点多我才开始研究把字符串分组连接的数组。思路很简单,就是建立一个字典,如果键是相同的,就 继续阅读

【会员课程】 :从零开始打造大流量采集站

本套课程一共24节课,总时长6小时56分 课程介绍: 展天一直推崇的是“长短结合的赚钱体系”,短期图温饱,长期图发展,可以长期持有的项目不多,能够产生持续“被动收入的项目”更少,而我们大流量网站算的上一个非常不错的可长期持有的一个体系。 当然,你可以把它看成是一个项目,也可以把它看做是一门技术,但我觉得这套课程更是一个流量体系,一个“长效被动流量增长”体系。 说它是项目,因为在课程中从前期准备,流量拓展,到中后期变现都描述的很清楚 继续阅读

【人工智能】ChatGPT 技术架构与相关技术栈清单

ChatGPT 技术架构 ChatGPT是一种基于自然语言处理的神经网络模型,它使用了大量的未标注文本数据进行训练,并通过预测文本中下一个词的方式来自我监督。 文章目录 ChatGPT 技术架构自监督预训练模块预训练模型深度学习Transformer模型生成式模型微调模块注意力机制多头自注意力机制基于人类反馈的强化学习与PPO机制残差连接长短时记忆网络(LSTM)词嵌入(Embedding)多层感知器(MLP)梯度下降优化算法自注意力机制序列到序列模型 继续阅读