“ 百模大战,花落谁家?”

01

—

开源、免费

今年2月24日,Meta推出大语言模型Llama(羊驼),按参数量分为7B、13B、33B和65B四个版本。它凭借一己之力,引导了开源大模型的发展,由其演变而来的家族模型非常庞大,庞大到羊驼家族的名词都被用光了,而且有些模型和 ChatGPT 3.5 都有一战之力。

昨天凌晨,Meta 官宣:Llama 2:开源,免费用于研究和商业用途。

Llama 2 在公开的在线数据源上进行了预训练。经过微调的模型 Llama-2-chat 利用公开可用的指令数据集和超过 100 万条人工注释,针对对话用例进行了优化。

Llama 2 参数规模从 70 亿到 700 亿不等。

本次发布的 Llama 2 模型系列包含 70 亿、130 亿和 700 亿三种规模参数。技术报告中提到训练了 340 亿规模参数,但并没有发布。

Llama 2 模型接受了 2 万亿个标记的训练,上下文长度是 Llama 1 的两倍。Llama-2-chat 模型还接受了超过 100 万个新的人类注释的训练。

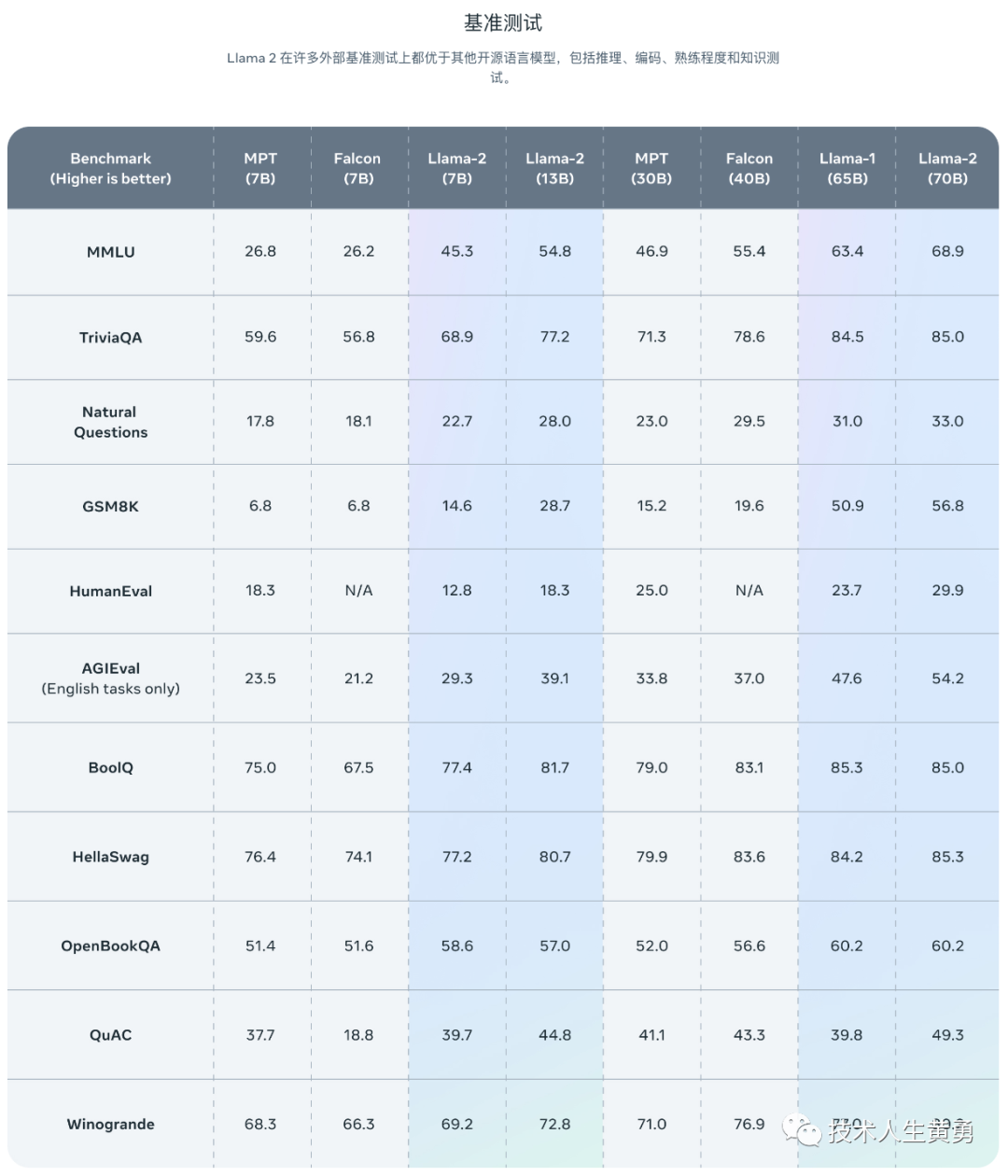

不出意外,官方公布的测评结果显示,Llama 2 在包括推理、编码、精通性和知识测试等许多外部基准测试中都优于其他开源语言模型。

现在看每家模型厂家发布新版本或者新特性时,都会附带一系列基准测试的评测结果。一方面说明模型厂家也在内卷得厉害,另一方面也学会了手机厂家的新品发布常干的事:刷分。

实际体验效果,还得等用户使用后,市场给出最终评价了。

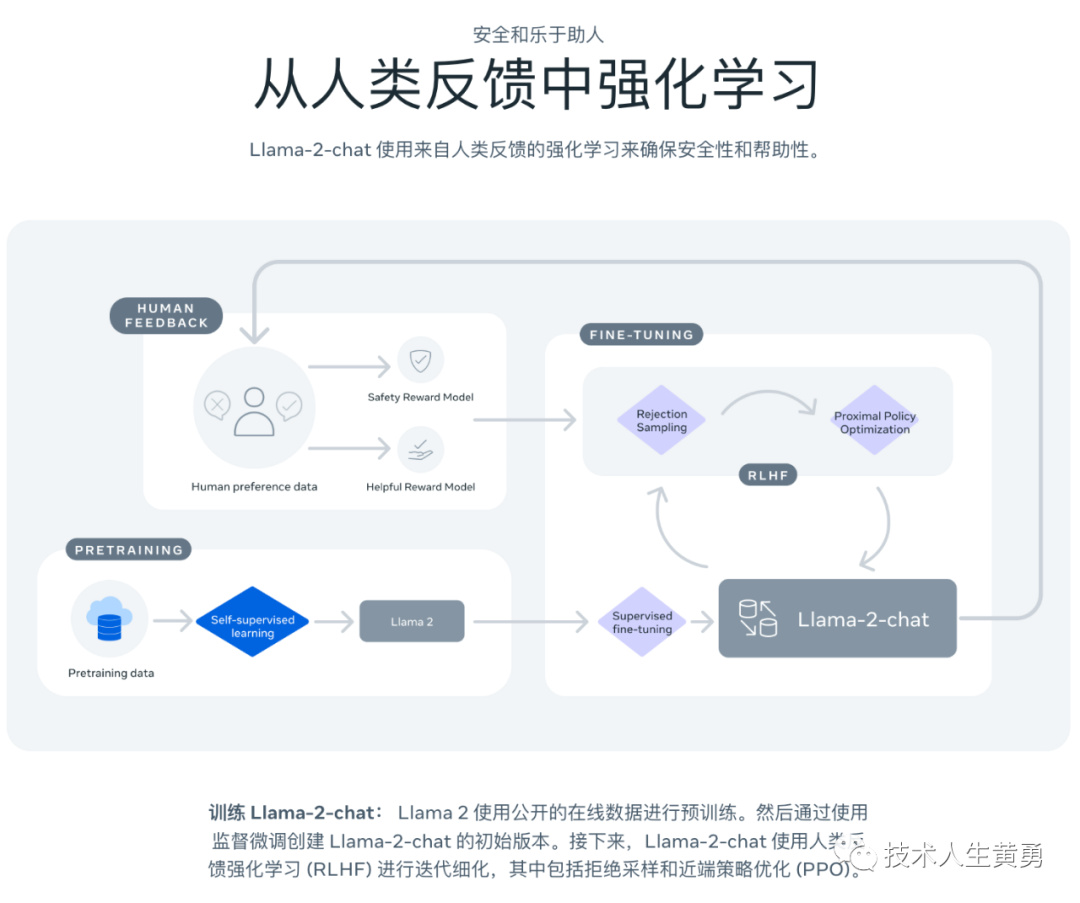

训练 Llama-2-chat 确保安全性和帮助性(更懂人的需求): Llama 2 使用公开的在线数据进行预训练。然后通过使用监督微调创建 Llama-2-chat 的初始版本。接下来,Llama-2-chat 使用人类反馈强化学习 (RLHF) 进行迭代细化,其中包括拒绝采样和近端策略优化 (PPO)。

Github地址:

https://github.com/facebookresearch/llama

这个地址只是介绍,模型权重和数据集都需要向官网填表申请。

https://ai.meta.com/resources/models-and-libraries/llama-downloads/

据说申请通过得很快,不知道是不是我申请的时候特别多,目前为止没有收到通过的邮件回复。

02

—

安全、预训练

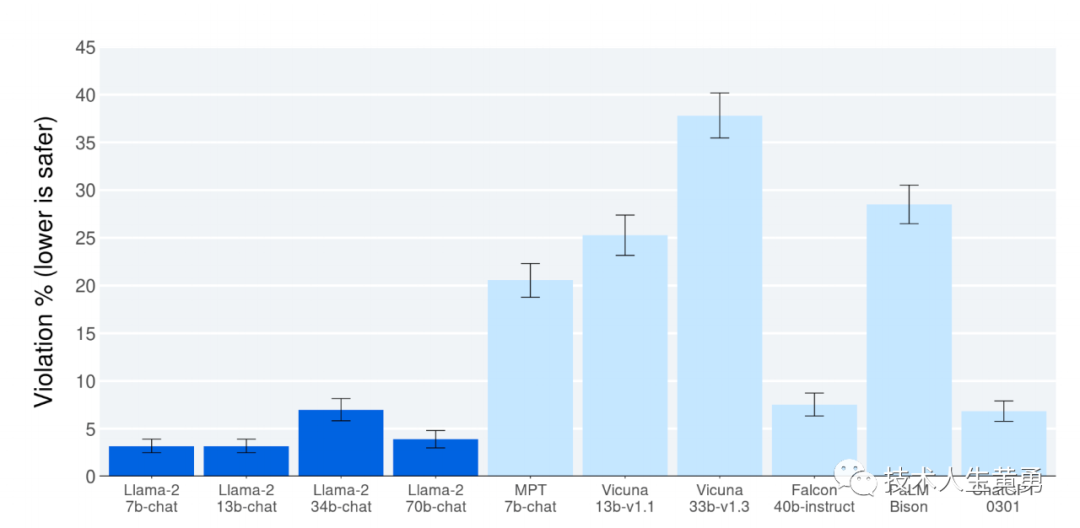

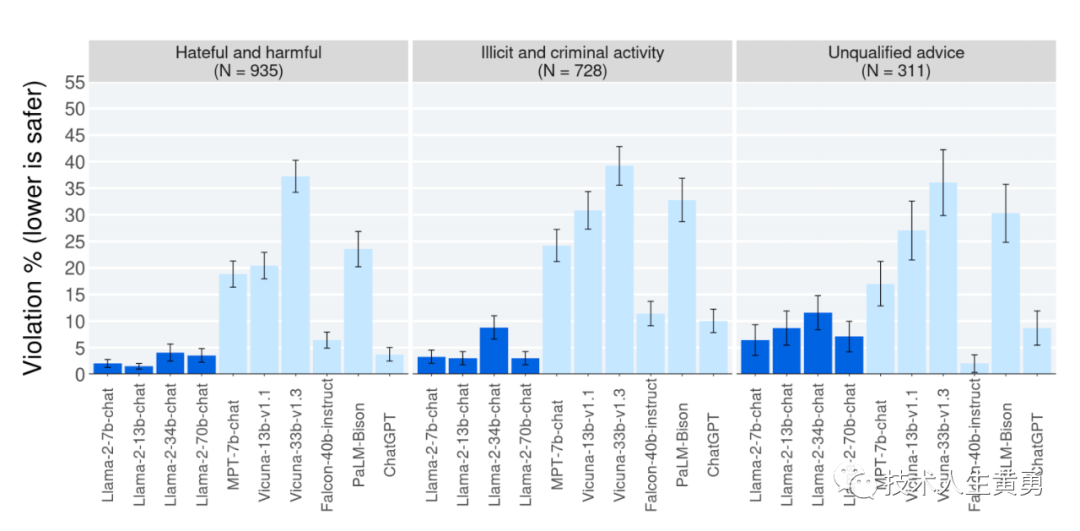

Llama 2-Chat的安全性人工评估结果

纵坐标越低表示越安全。

与其他开源和闭源模型相比,人工评估者根据约2000个对抗性提示判断了模型生成的安全性违规情况,这些提示包括单轮和多轮提示。

虽然写的是和其他开/闭源的模型,但是这个评估表只有 ChatGPT0301 一家比较有名。

官方技术文档中使用三个常用基准评估了 Llama 2 的安全性,针对三个关键维度:

真实性,指语言模型是否会产生错误信息,采用 TruthfulQA 基准;

毒性,指语言模型是否会产生「有毒」、粗鲁、有害的内容,采用 ToxiGen 基准;

偏见,指语言模型是否会产生存在偏见的内容,采用 BOLD 基准。

一、预训练的安全性

首先,预训练数据对模型来说非常重要。Meta 进行实验评估了预训练数据的安全性。

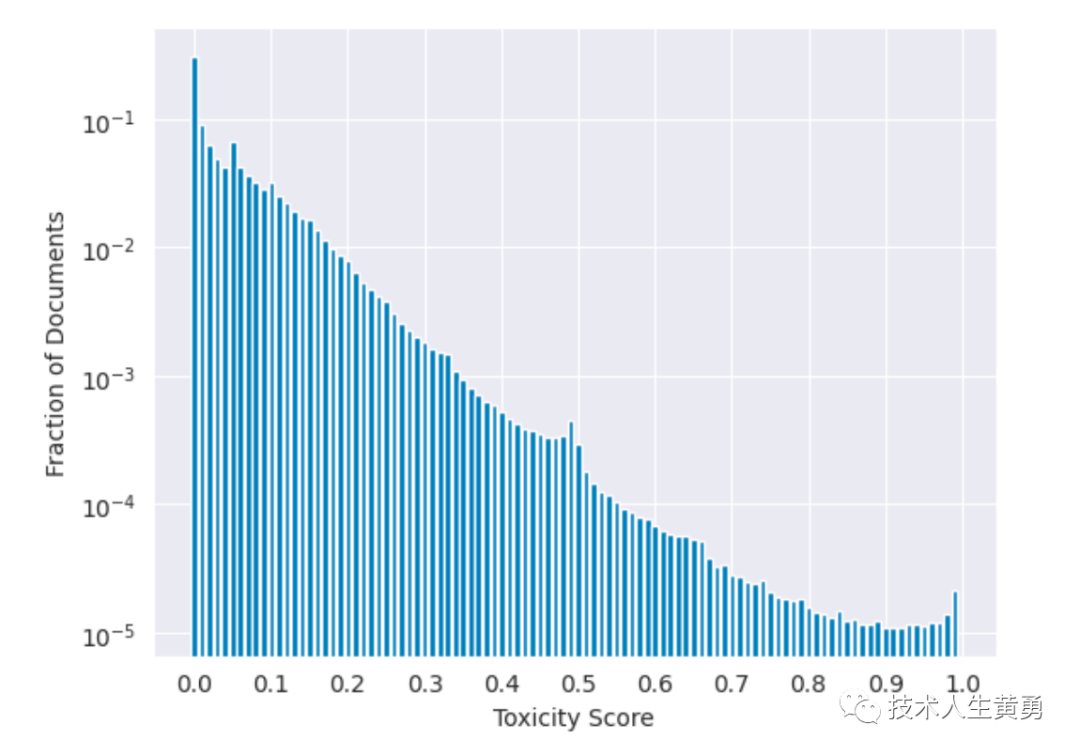

该研究使用在 ToxiGen 数据集上微调的 HateBERT 分类器来测量预训练语料库英文数据的「毒性」,具体结果如下图所示:

Meta 实验预训练数据的毒性分布。为了在泛化中取得更好的效果,Meta选择不从预训练中清除有毒数据。通过HateBERT 分类器辨别,在预训练语料库中包含了约 0.2% 的可能有毒的文档,这些文档的毒性在 0.5 或更高。

什么是“泛化”,可以参考:Claude 2 解读 ChatGPT 4 的技术秘密:细节:参数数量、架构、基础设施、训练数据集、成本,简单理解:指模型在训练集之外的数据集(通常是验证集和测试集)上的表现。

直白的说,为了保证训练在安全性的保障上,Meta 在训练 Llama 2 的数据集里放了大约 0.2%的有毒文档,确保训练后, Llama 2 模型能识别出来有毒的资料。

二、安全微调

Meta 在对 Llama 2 的安全微调中使用了以下技术:1、监督安全微调;2、安全 RLHF;3、安全上下文蒸馏。

Meta 在 Llama 2-Chat 的开发初期就观察到,它能够在有监督的微调过程中从安全演示中有所总结。模型很快就学会了撰写详细的安全回复、解决安全问题、解释话题可能敏感的原因并提供更多有用信息。

特别是,当模型输出安全回复时,它们往往比普通注释者写得更详细。因此,在只收集了几千个有监督的示范后,Meta 就完全改用 RLHF 来教模型如何写出更细致入微的回复。

使用 RLHF 进行全面调整的另一个好处是,它可以使模型对越狱尝试更加鲁棒(指系统或模型在遇到干扰或故障时,仍然能够正常运行的能力。在这里指模型面对故意欺骗的输入时可以检测出来,不被愚弄的特性)。

RLHF Reinforcement Learning from Human Feedback的缩写,来自人类反馈的强化学习

一种强化学习技术,用于提高语言模型的准确性和公平性。它通过使用人类反馈来训练语言模型,以生成更准确和公平的文本。

RLHF 工作原理:

首先,语言模型被预先训练在一个大型的文本和代码数据集上。

然后,人类用户被要求评估语言模型生成的文本。

人类用户的反馈被用于训练一个奖励函数,该函数用于评估语言模型生成的文本。

语言模型然后被重新训练,以最大化奖励函数。

Meta 首先通过收集人类对安全性的偏好数据来进行 RLHF,其中注释者编写他们认为会引发不安全行为的 prompt,然后将多个模型响应与 prompt 进行比较,并根据一系列指南选择最安全的响应。接着使用人类偏好数据来训练安全奖励模型,并在 RLHF 阶段重用对抗性 prompt 以从模型中进行采样。

最后,Meta 通过上下文蒸馏完善了 RLHF 流程。这涉及到通过在 prompt 前加上安全前置 prompt 来生成更安全的模型响应,例如「你是一个安全且负责任的助手」,然后在没有前置 prompt 的情况下根据更安全的响应微调模型,这本质上是提取了安全前置 prompt(上下文)进入模型。

Meta 使用了有针对性的方法,允许安全奖励模型选择是否对每个样本使用上下文蒸馏。

上下文蒸馏(Context Distillation)是一种提高自然语言处理模型泛化能力的技术。

其背后的思想是:使用丰富的训练样本上下文,让模型学习到更强的语义表示能力。

具体做法是:

构造包含丰富上下文的训练样本,如前后文组成的短篇章。

利用大模型(teacher model)生成这些样本的隐层表示或概率分布。

将小模型(student model)训练为预测大模型的输出,而不是原始标注。

通过这种蒸馏,小模型可以学到老师模型看到的丰富上下文信息。

下图为不同 LLM 在不同风险类别中安全违规百分比。 注意:由于提示集的限制、审查指南的主观性、内容标准和个别评估者的主观性,这些结果应谨慎解释。

仍然是纵坐标数值越低,表示越安全。风险类别分为三类:仇恨和有害的、非法和犯罪活动、不适当的建议。

有兴趣的朋友,模型安全方面可以用这篇文章说的方式自己试试:AI人工智能大模型失守!ChatGPT、BARD、BING、Claude 相继被"提示攻击"攻陷!。

预训练

Meta 以 Llama 1 论文中描述的预训练方法为基础,使用了优化的自回归 transformer,并做了性能上的提升,迭代出全新的 Llama 2 模型系列。

token数量仅指预训练数据。所有模型的全局batch大小为4M个token。更大的模型——340亿(34B)和700亿(70B)参数——使用了Grouped-Query Attention(GQA)以提高推理可拓展性。

Llama 2 的训练语料库包含了来自公开可用资源的混合数据,并且不包括 Meta 产品或服务相关的数据。Llama 2 采用了 Llama 1 中的大部分预训练设置和模型架构,包括标准 Transformer 架构、使用 RMSNorm 的预归一化、SwiGLU 激活函数和旋转位置嵌入。

RMSNorm是一种模型正则化技术,全称是Root Mean Square Layer Normalization。它是一种改进的层规范化(Layer Normalization)技术,可以加速神经网络的收敛,并起到一定的正则化作用。

SwiGLU是一种改进版的GLU(Gated Linear Unit)激活函数,全称为Switchable GLU。SwiGLU是GLU的可控可学习版本,通过自适应地调节门控机制的比例,增强了模型的表达能力和泛化性能。它被广泛地应用在Transformer类模型中。

对大模型的神经网络技术名词感到陌生的,可以阅读这篇文章科普:为什么对ChatGPT、ChatGLM这样的大语言模型说“你是某某领域专家”,它的回答会有效得多?(二)

感兴趣的可以访问下方官方下载技术手册地址,手册中附录部分有更多信息披露:预训练的附加细节、微调的附加细节、安全方面的附加细节、数据注释、数据集污染、模型信息。

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

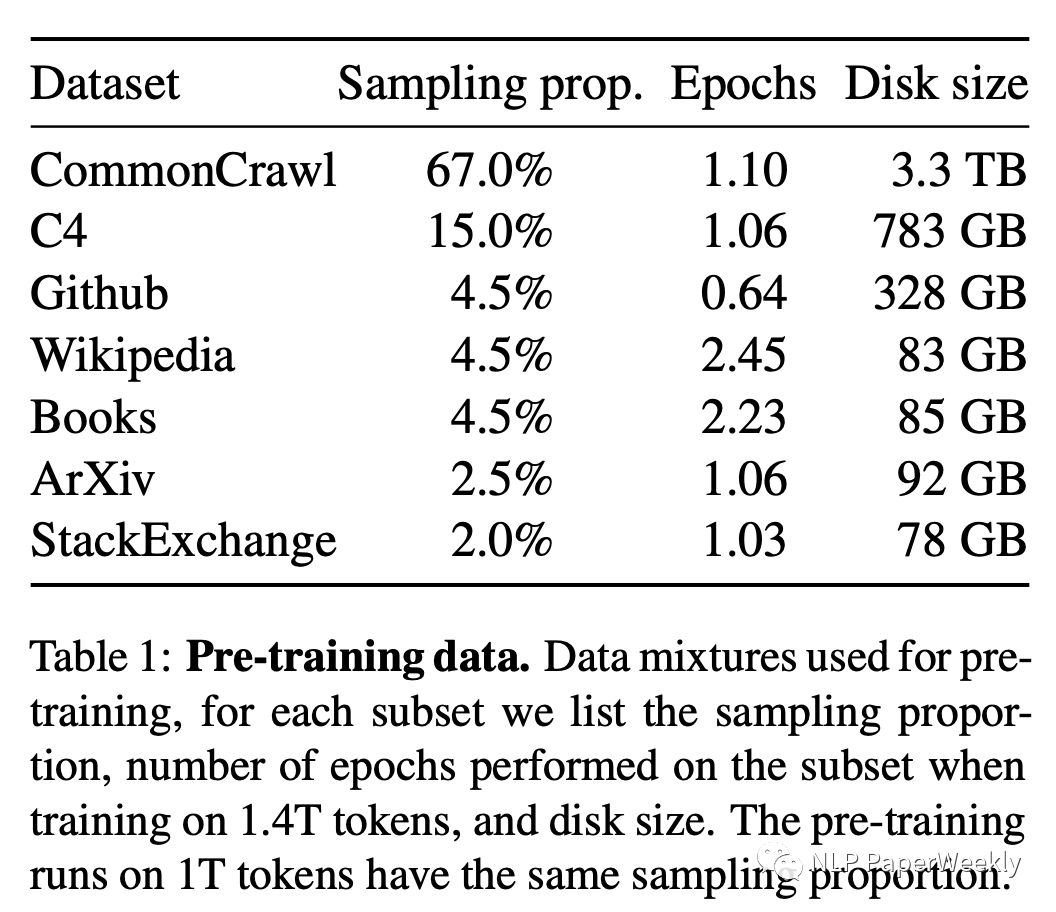

手册没提到训练数据内容,只是说:“A new mix of publicly available online data”,一个新的互联网上公开的数据集。Llama 训练时的数据集,来源和占比情况如下图,主要用了英语的数据,非英语的数据过滤掉了。

03

—

大模型会怎么演变

从技术演进角度来看,我认为当前大语言模型正处于以下阶段:

模型规模快速增长

从BERT到GPT-3再到最近的ChatGPT,顶级语言模型的参数规模正在快速增长,模型容量在不断扩大。ChatGPT的参数量比GPT-3增长了超过10倍。未来的参数规模还会继续快速增长。

多模态结合增强

当前的语言模型主要是文本模态。未来会向多模态发展,将文本、图像、语音、视频等数据整合,形成多模态表示,增强对真实世界的理解。

模型结构持续演进

从LSTM到Transformer再到最近的Sparsely-Gated Mixture-of-Experts结构,语言模型的网络结构也在不断演进,以支持规模化和多模态结合。

训练技术不断优化

超大规模模型的预训练需要各种分布式训练的缩放技术,这些技术也在快速进步。另外,增强学习、迁移学习等新技术也在提升效果。

推理部署日渐重视

早期更关注预训练模型效果,而推理部署和效率日渐受到重视。各种模型压缩、编译、异构计算技术正在成熟。

应用场景持续拓展

从早期的预训练模型转入下游任务,到直接终端部署,语言模型的商业应用场景在不断拓展。

伦理法规框架建设

随着应用影响力增大,伦理风险和治理也日益重视,相关法规框架正在逐步建立。

总体上,大语言模型正处于高速发展期,各方面技术都在快速演进。未来它对社会的影响还会更加深刻。

大语言模型改变其他行业可能会经历如下几个阶段:

第一阶段 - 探索和验证

这个阶段的特点是各行业开始尝试应用大语言模型,但更多停留在探索和验证阶段。企业会通过一些小规模的试点项目来验证语言模型在具体业务场景中的效果。此时的应用更加局限和碎片化。

第二阶段 - 落地应用

这个阶段会看到越来越多的企业基于前期的验证,开始在某些关键业务场景中落地应用语言模型。此时的应用会更加系统化和产品化,形成实际的商业价值。一些成功的应用案例会逐渐出现。

第三阶段 - 大规模部署

这个阶段语言模型将在企业内部得到大规模部署,被嵌入到多个业务流程中。它们不再是孤立的应用,而是成为公司业务和决策的关键部分。我们会看到语言模型驱动的新兴业务模式和商业变革。

第四阶段 - 行业重塑

在这个阶段,语言模型将以颠覆式的力量深刻重塑传统行业。我们可能看到完全由语言模型自动化运营的新型企业。语言模型还将以人工常识的形式深入各行各业,带来广泛的社会影响。

每次行业对新技术的吸收和适应都是一个循序渐进的过程。在推动其他行业变革方面,大语言模型也会经历这种阶段性演进。随着技术的进一步成熟,它的应用范围和影响力还会不断扩大。

当前状况:

行业仍处于初级阶段,主要是技术驱动和产品验证阶段。

主要参与者是大型科技公司和初创公司。规模化资源和数据对模型训练非常关键。

主流商业化产品还比较有限,大多集中在对话机器人和写作助手等方面。

最值得注意的是谷歌已经将新发布的 Bard 模型应用到自家的广告推荐系统中,在实现千人千面的针对不同的人群推荐不同的商品基础上,实现了针对同一款产品,不同的人显示不同的营销广告词。

当用户输入“干燥敏感肌护理”的关键词时,大模型将实时生成广告文案:“舒缓你的干燥敏感肌”。

往期热门文章推荐:

谷歌 Bard 深夜更新:支持中文、语音输入/播报、代码导出、对话分享

定制化需求|一个人工智能大模型应用的算力成本有多高?

ChatLaw:北大团队智能法律助手,国产大模型成功应用普惠法律服务

为什么对ChatGPT、ChatGLM这样的大语言模型说“你是某某领域专家”,它的回答会有效得多?(二)

快捷部署清华大模型 ChatGLM2-6B,一键搞定 HuggingFace Space 空间

ChatGLM2-6B 初体验

希望体验 ChatGPT 微信机器人的朋友可扫下面的群二维码进群(7月24日前有效): @ ChatGPT智能助手,跟着想的问题即可。

拥抱未来,学习 AI 技能!关注我,免费领取 AI 学习资源。

本文链接:https://my.lmcjl.com/post/11067.html

4 评论