巨头入场和“东数西算”的助推,让中国离这个万亿级算力蓝海更近了一步。

作者|思杭

编辑|皮爷

出品|产业家

2023年初,在青岛、济南、日照等12座城市,一座座崭新的大型数据中心拔地而起。

其中,最引人瞩目的属2月23日,在青岛崂山区的青岛人工智能计算中心。这是山东省第一个上线运行的人工智能计算中心,算力规模可达250P。

在青岛这座城市,既有像卡奥斯这样的工业互联网平台型企业,也有像创新奇智、极视角、以萨技术等人工智能服务商。这些企业对算力、算法和数据有着庞大的需求。

像青岛人工智能计算中心这样的项目,最近两年不在少数。而如今,人工智能再一次引爆算力需求。

前有ChatGPT诞世,后有百度“文心一言”,还有鲜为人知的claude+,由Anthropic公司开发;腾讯近日也宣布研发ChatGPT聊天机器人。

为什么ChatGPT爆火后,国内外大厂都前仆后继地参与?又为什么OpenAI的ChatGPT被称为“一直被模仿,从未被超越”?

1956年,人工智能开始发展,60年一直不温不火,直至2017年,Alphago打败围棋世界冠军,才算AI破圈的开始。决定AI的三大核心要素是数据、算法和算力。

首先,全球最不缺的就是数据,尤其在中国,14亿人口平均人手1.6部智能手机,未来随着物联网技术的完善,每人会生产出更庞大的数据量;其次是算法和算力,一个形象的比喻是,数据等于厨师炒菜用的食材,算法是菜谱,算力则相当于厨师的厨艺。而在中国,拖后腿的是算法和算力。

据OpenAI近日发布的数据,截止目前人们对算力的需求已增长超30万倍。然而,就在各国加速布局算力产业之际,2022年美国商务部禁止了高端芯片设备及人工智能芯片的对华出口。这直接影响了英伟达和AMD两大供应商对A100和H100两款高端加速卡的出口。

“1万枚英伟达A100芯片是做好AI大模型的算力门槛”,这是行业内公认的标准。H100则是比A100性能更高的芯片。

ChatGPT能有今天的突破,微软功不可没。构建“永远改变人机交互方式”的超级计算机,是OpenAI五年前的豪言壮志。为了帮助实现这个大胆的想法,微软斥资数亿美元做了一场赌注。这其中面临的难题是前所未有的,比如在Azure云计算平台上连接几万个英伟达A100芯片,再比如打造指数级增长的网络GPU集群规模等。还好,微软赌赢了。

在算法上,ChatGPT依然使用2017年论文中发布的Transformer,该算法原本的应用场景是翻译,因此它不仅具备英语语言能力,也有中文语言系统,这解释了为什么GPT能够进行中文对话;但性能提升主要在算力上,ChatGPT这种大规模分布式训练已经超出了摩尔定律的限制,上万个A100芯片让算力暴涨1万倍,这种算力消耗前所未有。目前,ChatGPT依赖于A100芯片,未来若投入H100,性能会有更大提升。

AI技术不断演进,对算力的需求也呈指数增长。据中国信通院预测,到2030年,近70%的公司都会用到人工智能。企业数字化转型也需要算力支撑,在中美芯片竞争博弈背景下,自建算力系统迫在眉睫。

王坚在3月30日出席财富全球科技论坛时也谈及到算力的重要性,“算力与‘电气化’同等重要。而算力和电力一样,只有极少数技术能帮助人类去做创新,这就是算力的重要性。”。

回到文章开篇的两个问题,之所以国内外大厂有能力开发聊天机器人,是因为其背后所需的技术并不难,像百度和华为都有自研芯片,文心一言就依赖于百度自研的昆仑芯;而之所以“从未被超越”,是因为ChatGPT背后巨大的算力支持,至少从现在来看,国内还需要时间。

一、一个万亿级的算力市场

ChatGPT打破了摩尔定律的限制,也引爆了对AI算力的需求。GPT-4的算力消耗远大于GPT-3和3.5,OpenAI也在不断对Plus付费用户调低阈值,将访问限制由第一天的150 msg/4hr降至最近的25msg/3hr,简言之,就是减少用户的提问次数,从而降低算力消耗。

具体来看,据GPT-4的公开数据,在32K的上下文长度下,每1000个token的提问成本为0.06美金,回答完成成本为0.12美金。与GPT-3的成本对比,GPT-4的输入成本增加了50%-200%,输出升本增加200%-500%。

由ChatGPT带来的算力恐慌也蔓延到了国内。

近日,多只国产芯片股大涨。截至3月29日13:39,芯片 ETF 龙头涨幅 4.37%,立昂微、北方华创涨停,中微公司涨超 9%,思瑞浦、澜起科技涨超 8%,沪硅产业-U、兆易创新、景嘉微涨超 5%。

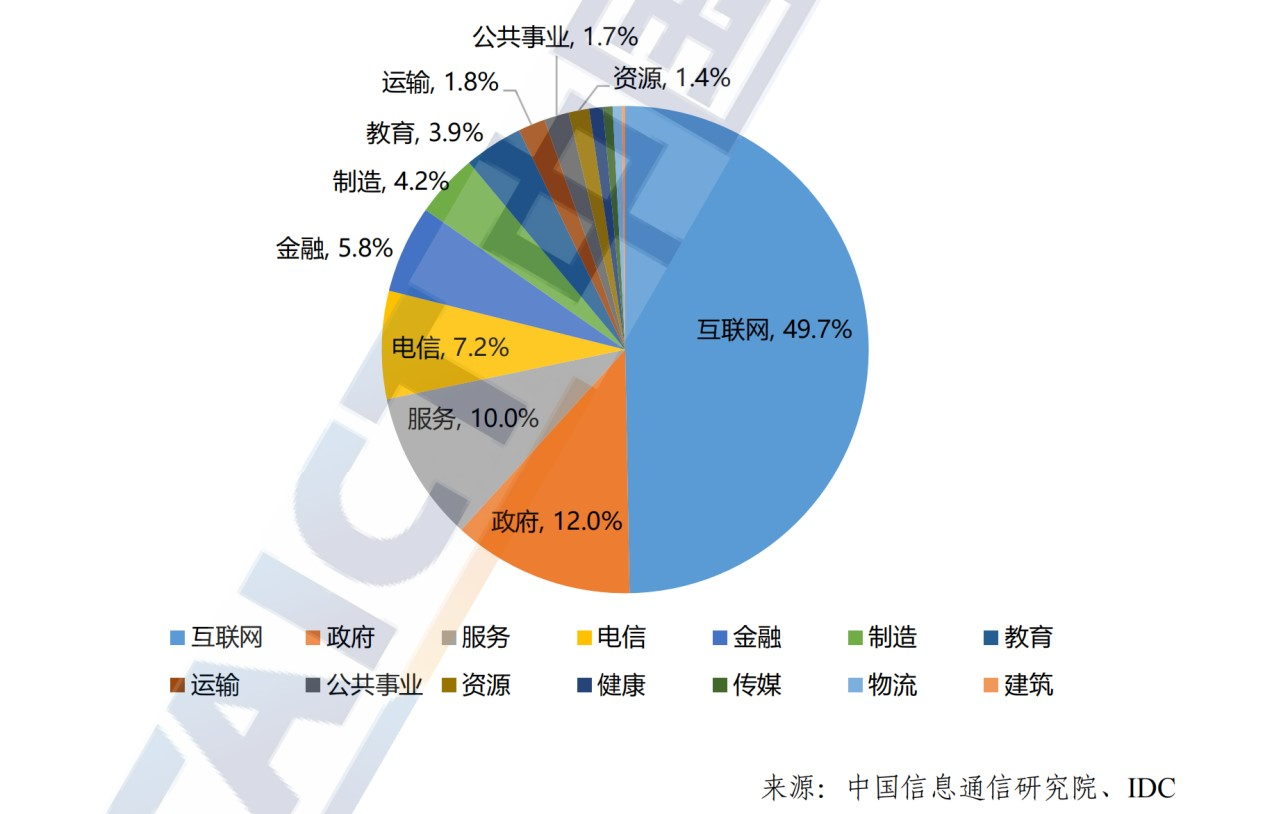

可以说,中国是一片巨大的算力蓝海。一方面,人工智能的发展带动数据流量增长,从而使算力规模激增;另一方面,算力深度融入互联网、电信、金融、制造等行业,助推各行业各领域完成数字化转型。据中国信通院统计,截至2022年,算力需求最大的行业是互联网,占整体算力份额的近一半,其次,政府、服务和电信业也在加大算力投入,占比分别为12%、10%、7.2%。

中国各行业算力应用分布情况

从电商到社交,从游戏到金融,从医疗到教育,互联网各行各业都需要算力。以电商巨头阿里为例,每天数十亿的交易数据,单是搜索引擎就需要处理数百亿个商品数据,这还只是在搜索和推荐商品的场景。另外,阿里还有两大块风控系统,一块是金融领域,主要业务是支付宝,另一块非金融领域,如新零售、高德、大文娱等。这些都需要巨大的算力在背后支撑,进行存储和分析数据,或识别和预防欺诈。

2022年8月30日,阿里云启动了张北超级智算中心,AI算力总规模为12 EFLOPS(每秒1200亿亿次浮点运算),据说超过了谷歌的9 EFLOPS和特斯拉的1.8 EFLOPS,成为全球最大的智算中心。2023年3月,百度也完成了阳泉智算中心的升级,算力规模达4 EFLOPS,成为目前亚洲最大单体智算中心。

智算中心的建设是为AI大模型训练、自动驾驶、空间地理等人工智能探索应用,提供智能算力服务。近年来,智能算力增长最为迅速。据IDC发布的数据,2022年,我国智能算力规模达268 EFLOPS,预计未来5年,我国智能算力规模的年复合增长率将达52.3%。

而国家大力布局智能算力产业的背后,是智能算力存在的巨大供给“鸿沟”。据IDC预测,未来三年新产生的数据量将超过过去三十年的总和。这个鸿沟就表现在,数据总量在增长,真正被有效利用的数据占比却不足1%。中国工程院院士王恩东在《瞭望》新闻周刊中说道,“目前无法具体统计AI算力缺口数据,但中国在加速数字化转型”,在这过程中,需要AI算法利用深度学习,训练出深度神经网络模型,这需要足够强的算力支撑。

未来,74.5%的企业都会用到AI,在智能算力方面,主要应用包括AI语音技术、大数据分析与机器学习、图像识别与处理及自然语言处理。像电商、智能家居、在线教育和人工智能等互联网行业对智能算力需求非常大。比如,阿里旗下的天猫需要智能算力开发“推荐算法”和“超级搜索”,或用于个性化定制和营销策略;再比如小米生态链公司Yeelight的智能家居系统,也需要算力实现智能化联动和语音控制。

如今,各国间的算力博弈进入白热化阶段。据中国信通院统计,2022年,我国服务器规模约2000万台,算力规模超150 EFlops,位居世界第二,仅次于美国;预测2023年,在ChatGPT引爆算力需求的背景下,中国算力规模将超200 EFlops。

巨头入场和“东数西算”的助推,让中国离这个万亿级算力蓝海更近了一步。

二、巨头造芯,算力能否跨越“卡脖子”困境?

2021年,字节下场造芯了,先是从百度截胡了三位芯片相关人才,而后又去华为海思、Arm、高通等公司“三倍(薪资)挖人”。这一波波操作引发了互联网大厂的“芯片人才热”。

早在自研芯片这一信号传出之前,字节跳动就接连投资了RISC-V公司睿思芯科、AI芯片公司希姆计算、GPU芯片设计独角兽摩尔线程、泛半导体行业智能制造商润石科技、数据中心网络芯片公司云脉芯联、开发衍射光学芯片的公司光舟半导体等。

字节下场造芯只是一抹缩影,高薪挖人也是互联网大厂追逐芯片梦的惯用手法。除了字节跳动,还有阿里、百度和腾讯。在一众互联网大厂中,最先吃螃蟹的人是百度。

故事开始于2010年,“这在当年是百度的一个秘密项目。”百度高级副总裁曾透露。百度最初尝试用FPGA架构研发AI芯片,然而它一开始并没有完全自研,而是同Arm、紫光展锐和赛灵思等公司合作,推出数款AI芯片,后来才走上自研的道路。2018年7月,百度正式发布其自研AI芯片“昆仑芯”,并于2020年量产。

2021年,昆仑芯的业务被独立了出来,由百度芯片首席架构师欧阳剑出任昆仑芯片公司CEO。同时,该公司也在3月完成独立融资,首轮估值约130亿元,自此,中国诞生了一家国产芯片超级独角兽。

阿里也紧跟步伐。在百度开始“秘密项目”的五年后,2015年,阿里巴巴宣布与集成电路设计企业杭州中天微合作,两年后又向中天微注资5亿元,宣布向芯片基础架构设计领域进军。2017年10月,阿里达摩院成立,成立之初就将芯片列为研究领域之一。到了2018年,阿里进一步收紧脚步,于8月联合中天微成立平头哥半导体芯片公司。

从这一年开始,阿里的成绩就尤为显赫。从玄铁902到玄铁910,从含光800到倚天710、羽阵600,这些是阿里5年的成绩单。2023年3月2日,阿里平头哥首次展示RISC-V生态全景,并预测到2025年RISC-V架构芯片有望突破800亿颗。中国工程院院士倪光南在会上表示,“今天RISC-V是中国CPU领域最受欢迎的架构,中国芯片产业和整个芯片生态将会越来越多地聚焦于RISC-V架构,中国的巨大市场也将成为支撑RISC-V的重要基地。”

而早有造芯意识的马化腾,却是最后一个入场,动作也略显低调。2016年,腾讯参与了可编程芯片公司Barefoot Networks的2300万美元C轮融资。随后销声匿迹了两年,在2018年,马化腾在论坛演讲中表达了做芯片的想法。三年后,才在腾讯官网上看到其发布的招聘信息:芯片架构师、芯片验证工程师、芯片设计工程师等。对此,腾讯回应,只是在特定领域有芯片研发的尝试,比如AI加速和视频编解码。

腾讯除了在芯片领域的投资,自研方面的成绩在一波三折后,终于柳暗花明。

早在2015年,FPGA刚进入主流视野,没有硬件基因的腾讯做过一次“造芯”的探索,但FPGA毕竟是“半定制”的电路,云端商业化还是失败了,最后团队人员遗憾告别。然而受挫之后,腾讯并没有放弃对硬件之路的思考,中国芯片行业也在2018年回暖。一年后,腾讯内部传来了声音,“AI芯片,要不要做?”虽然这一声音遭遇过反对,但腾讯还是进行了小规模地试水,“蓬莱”芯片也就此诞世。

2020年1月,蓬莱芯片流片完成,经过四次尝试,“蓬莱”被点亮了。2021年11月,在腾讯数字生态大会上,又一口气发布了三款专用芯片:紫霄、沧海和玄灵,分别专注于AI计算、视频优化和智能网络。

如今,字节、百度、阿里、腾讯全部跨界,齐聚芯片行业,究其原因,无非是由需求端和供给侧,两者的合力共同拉动。

“字节跳动光服务器所需要的芯片就是几十万块,只要达到自产自销就能降低成本。何况还有Pico,一旦VR/AR产业爆发,算力就是瓶颈,所以现在自研芯片也算是未雨绸缪。”华南一家AI芯片公司的资深架构工程师李波透露。

不仅是字节,腾讯也是如此。2019年,腾讯迎来云计算业务上的里程碑——云服务器规模突破100万。以更低成本提供更高的网络性能,成为当时腾讯面临的一大难题。

除了中国的互联网巨头,美国的亚马逊、谷歌也在自研芯片。2014年,谷歌为数据中心设计了服务器芯片,2019年又在印度组建团队,其芯片用途主要在云端和智能设备上;亚马逊也于2018年发布其首款自研云服务器CPUGraviton,未来预计还会推出应用于物联网和智能设备的芯片。

从需求端来看,互联网大厂和云计算公司造芯是未雨绸缪。未来,大部分互联网厂商都会进入物联网和智能设备等领域,而这些领域十分倚重硬件。所以,软硬一体是未来互联网公司和云计算厂商的必由之路。另外,很重要的一点,在市场层面,想要守住市场地位,实现差异化,底层硬件设施是关键,它直接影响着上层软件的性能。

对于国内互联网大厂纷纷跨界造芯,除了美国限制高端芯片的对华出口,还有两点更重要的原因——成本和针对性。早前,在英伟达芯片还没有严禁向中国出口时,很多互联网大厂就已经表示过,由于算力需求庞大,英伟达的GPU芯片又太贵,大规模购买成本十分高昂。而且英伟达芯片属于通用型,并不能针对特定某家企业算法做优化。那么对芯片有不同场景需求的互联网大厂,比如在AI加速器和视频编解码场景,想实现成本功耗最低、性能最优,自研是必选项。

从供给侧来看,国内芯片厂商和互联网大厂造芯都已具备足够成熟的技术。而需求方下场做芯片最大的优势在于,对需求的理解和洞察最深刻。

以阿里的含光为例,在2019年云栖大会上,阿里用4颗含光800芯片,就代替了40颗传统GPU才能完成的视频处理任务。而前者的成本,是后者的十分之一。腾讯的紫霄也打破了算力的瓶颈点,在图片和视频处理、自然语言处理、搜索推荐等应用场景下,性能是业界标品的2倍。

应用于百度“文心一言”的昆仑芯则更胜一筹。从算力和成本上,昆仑芯都要强于英伟达 A100芯片,只是在训练量上还相对较弱。据官方介绍,昆仑芯基于7nm工艺打造。在业界,7nm的蚀刻尺寸意味着,芯片的工艺水平更高,单位体积内的集体管更多,芯片性能也就更强。昆仑芯的算力可达到 256TOPS@INT8 以及 128 TFLOPS@FP16。目前,昆仑芯在百度内部已落地了搜索、小度、无人驾驶等AI业务场景。

芯片是一个全球性的产业,从芯片制造角度分析,没有任何一个国家能自己完成芯片的制造,这是不争的事实。另外,我国芯片行业发展的另一大难题是芯片人才短缺。据相关数据统计,2025年我国芯片专业人才缺口将超30万人。但从长远来看,互联网大厂跨界造芯、高薪抢人,也向供给端发送了芯片人才短缺的信号。

尽管如此,互联网公司下场造芯,已经解决了一部分问题,在特定场景下,应用性更强,成本也更低。算力也因此有望跨越“卡脖子”困境。

三、中国的算力有多大想象力?

为什么说芯片是全球性产业,任何国家都很难不借助外力造出来?

第一,芯片的科学原理很难。这一点可以从芯片人才短缺上去理解,目前,只有清华、上交、复旦、中科大、电子科技大学等几所知名高校设有芯片相关专业。从这一现象就足以窥探,芯片科学原理的难度。

第二,芯片的工艺制造很难突破瓶颈。芯片加工和制造就是两个最难的环节。芯片制造离不开光刻机,一台光刻机至少有10万个零部件,而一台汽车的使用零部件只有5000个,足以想像光刻机的制造难度之大。制造芯片更是需要数百道工艺,有些工序还要循环数十遍。

第三,EDA软件(电子设计自动化软件)也是国内一大瓶颈。EDA软件的用处是让电子设计师实现在电脑上设计芯片,否则就需要人工设计、试验,要耗费的人力和时间成本不计其数。但目前我国应用的十几种EDA软件都来自美国。如果自己做EDA研发十分困难,它的算法就决定了芯片设计的优劣。而如果EDA软件质量不够,设计师就不可能设计出高质量的芯片。

除了芯片层面,我国算力产业发展还受到建设方面的问题。比如不同芯片、操作系统、固件、整机系统兼容性不强,制约了产业的进一步发展。中国信通院王骏成认为,“算力应用存在标准缺失、数据共享不够、资源接口不统一等壁垒”,导致算力供需失衡。

对此,国家已于2022年初提出建设“东数西算”工程,助力打通我国东西部数字产业的“大动脉”,为经济发展注入新动能。国家信息中心郭明军表示,通过该工程实现东西部算力资源的流通,依托算力网络,把算力真正用起来,实现“算力入户”、“算力入企”、“算力入园”、“算力入校”。

在算力网络建设层面,三大运营商成为算力网络的主导者。据《财经十一人》,2022年三大运营商云业务总营收1352亿元,增速超过100%。“三大运营商每年都要花费千亿元规模的资本开支用于基础设施建设。2022年,中国移动、中国电信和中国联通的资本开支分别为,1852亿元、952亿元和742亿元。”其资本投入已超过BAT三大互联网公司。

目前来看,国家层面、运营商和企业都在加大力度布局算力网络。在此前提下,这一轮生成式AI技术演变能带来多大规模的算力爆发?对产业格局会产生怎样的影响?

首先,生成式AI会消耗巨大的算力,从而带动对算力产业的需求。当下,互联网大厂BAT早已凭借自身在芯片领域的多年沉淀,开始投入大模型研发。所以,最先受益的会是ICT企业。

其次是头部大公司,互联网厂商自研芯片,也会将能力外溢给合作平台和客户,从而让头部厂商受益。

最后一轮机会则留给创业公司,生态产业链的完整会受益千行百业,这也是生成式AI对各行业的颠覆,只是等到创业公司感受到变化,还需要一段时间。

备注:部分资料来自网络

本文链接:https://my.lmcjl.com/post/13080.html

4 评论