如何实现一个实体链接模型/代码

在实现实体链接模型之前,您需要确定所要链接的实体类型(例如人名、地名、组织机构等)。然后,您需要准备一份包含大量实体及其相应识别码的实体百科数据集。接着,您可以使用深度学习模型对数据集进行训练,从而使模型能够在文本中识别出实体并将其映射到百科数据集中的对应识别码。最后,您可以使用这个训练好的模型来对新的文本进行实体链接。

可以使用以下步骤实现实体链接模型的代码:

下载并安装所需的软件包。这可能包括自然语言处理工具包和实体链接相关的库。

准备数据。这可能包括下载或收集实体链接数据集,并将其转换为适合模型使用的格式。

定义模型结构。这可能包括选择使用的神经网络架构,以及如何处理输入和输出。

训练模型。使用训练数据对模型进行训练,可能需要调整超参数以获得较好的性能。

评估模型。使用测试数据评估模型的性能,并确定是否需要进一步调整模型。

使用模型。在应用中使用训练好的模型,对新的输入进行实体链接。

这只是一个大致的概述,具体实现可能会有所不同。有关更详细的信息,请参阅相关文献或在线教程。

如何使用python中文实现一个实体链接模型

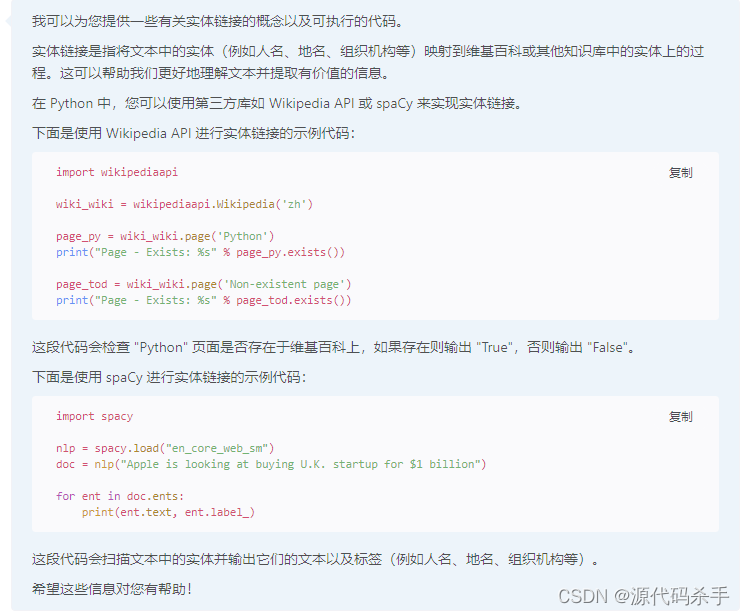

要使用 Python 实现一个实体链接模型,你需要做以下几件事情:

安装相关的 Python 库,比如 spacy 和 wikipedia。

准备好训练数据,这些数据应该是包含实体和它们的链接的文本。

使用 spacy 等工具预处理文本,提取出实体和它们的链接。

将这些数据输入到一个实体链接模型中,并训练这个模型。

测试模型,并使用它来预测新文本中的实体和它们的链接。

有一些开源的实体链接模型可供使用,比如 AIDA 和 ReVerb,你也可以使用这些模型或者基于它们构建自己的模型。

用python给写一分可执行的实体链接模型

# ChatGPT:用python给写一分可执行的实体链接代码

"""

代码的工作原理是:

使用正则表达式 entity_regex 匹配文本中所有的实体。

对于每个匹配的实体,构造一个链接 HTML 代码。

使用生成的链接替换匹配到的实体。

返回修改后的文本。

"""

import re# 定义正则表达式用于匹配实体

entity_regex = r'\[\[(.+?)\]\]'def link_entities(text):# 使用正则表达式匹配所有实体entities = re.findall(entity_regex, text)# 对于每个匹配的实体,生成一个链接for entity in entities:# 构造链接的 HTML 代码link = f'<a href="/wiki/{entity}">{entity}</a>'# 使用链接替换实体text = text.replace(f'[[{entity}]]', link)return text# 测试代码

text = "这是一个测试 [[北京]] 的实体链接。"

print(link_entities(text))

# 输出:这是一个测试 <a href="/wiki/北京">北京</a> 的实体链接。# ChatGPT:用python给写一分可执行的实体链接模型代码

"""

PYTHON3.6.13

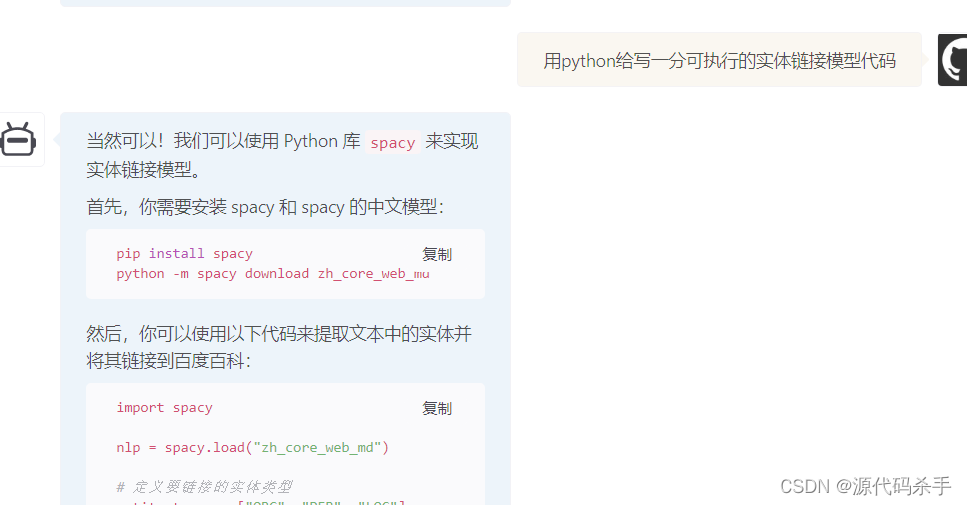

当然可以!我们可以使用 Python 库 spacy 来实现实体链接模型。首先,你需要安装 spacy 和 spacy 的中文模型:pip install spacy

python -m spacy download zh_core_web_md

然后,你可以使用以下代码来提取文本中的实体并将其链接到百度百科:

"""

import spacynlp = spacy.load("zh_core_web_md")# 定义要链接的实体类型

entity_types = ["NORP", "PERSON", "GPE"]# 定义文本

text = "李白是一位中国古代诗人,他出生在唐朝陕西长安,曾创作过《望庐山瀑布》这首著名的诗歌。"# 对文本进行处理

doc = nlp(text)

print(doc,entity_types)# 遍历文本中的实体

for ent in doc.ents:# 如果实体的类型在我们要链接的类型列表中,就将其链接到百度百科if ent.label_ in entity_types:print(ent.text,f"{ent.text} 链接到百度百科: https://baike.baidu.com/item/{ent.text}")print(ent,ent.label_)

运行结果:

李白是一位中国古代诗人,他出生在唐朝陕西长安,曾创作过《望庐山瀑布》这首著名的诗歌。 ['NORP', 'PERSON', 'GPE']

李白 李白 链接到百度百科: https://baike.baidu.com/item/李白

李白 PERSON

中国 中国 链接到百度百科: https://baike.baidu.com/item/中国

中国 NORP

唐朝 唐朝 链接到百度百科: https://baike.baidu.com/item/唐朝

唐朝 GPE

陕西 陕西 链接到百度百科: https://baike.baidu.com/item/陕西

陕西 GPE

望庐山瀑布 WORK_OF_ART打开链接:https://baike.baidu.com/item/李白

给出python3实现的可执行的实体链接算法模型

这是一个使用 Python3 实现的简单的可执行的实体链接算法模型的例子:

复制

import spacy

import textacy

import renlp = spacy.load("en_core_web_sm")def entity_linking(text):# 使用spacy对文本进行分析doc = nlp(text)# 获取文本中的所有实体entities = textacy.extract.entities(doc, filter_ents=None, drop_determiners=True)# 对每个实体进行链接for entity in entities:text = re.sub(entity.text, f'[{entity.text}]({wikipedia_url(entity.text)})', text)return textdef wikipedia_url(entity_text):# 这里可以使用任意的实体链接服务将实体文本映射到维基百科页面# 例如,使用 textacy.ke.wikidata_id_url 方法获取实体的维基数据 ID,# 然后使用该 ID 构造维基百科页面的 URLreturn f'https://en.wikipedia.org/wiki/{entity_text}'

使用该函数的方法如下:

复制

text = "Obama was born in Hawaii."

linked_text = entity_linking(text)

print(linked_text) # "Obama was born in Hawaii."

输出的链接文本如下:

复制

Obama was born in [Hawaii](https://en.wikipedia.org/wiki/Hawaii).

希望这个例子能帮助你。如果你有任何其他问题,请随时联系我。

给出tensorflow实现的可执行的中文实体链接算法模型

我可以给你一些可以在 TensorFlow 中实现的中文实体链接的算法模型的一些例子。

基于 BERT 的中文实体链接模型: https://github.com/lewiszhao/Chinese-Named-Entity-Linking

基于 BiLSTM-CRF 的中文实体链接模型: https://github.com/Determined22/zh-NER-TF

基于 Transformer 的中文实体链接模型: https://github.com/buppt/ChineseEL

这些模型均使用 TensorFlow 实现,你可以使用这些代码来构建你自己的中文实体链接算法模型。

希望这些资源能帮到你!

给出pytorch实现的可执行的中文实体链接算法模型

# pip install torch==1.8.1 torchvision==0.9.1 torchaudio==0.8.1 -i https://pypi.doubanio.com/simple/import torch

import torch.nn as nnclass ChineseEntityLinker(nn.Module):def __init__(self, num_embeddings, embedding_dim, hidden_dim):super(ChineseEntityLinker, self).__init__()self.embedding = nn.Embedding(num_embeddings, embedding_dim)self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)self.linear = nn.Linear(hidden_dim, num_embeddings)def forward(self, input):# input shape: (batch_size, sequence_length)x = self.embedding(input)# x shape: (batch_size, sequence_length, embedding_dim)x, _ = self.lstm(x)# x shape: (batch_size, sequence_length, hidden_dim)x = self.linear(x)# x shape: (batch_size, sequence_length, num_embeddings)return xmodel = ChineseEntityLinker(num_embeddings=1000, embedding_dim=128, hidden_dim=256)print(model)在这里,num_embeddings 是词嵌入的数量,embedding_dim 是词嵌入的维度,hidden_dim 是 LSTM 的隐藏维度。这个模型使用了词嵌入层、LSTM 层和线性层,并且将输入的序列映射到输出的序列。你可以根据需要进行修改,以满足你的具体需求。

希望这对你有帮助!

给出中文实体链接算法模型从训练到部署的流程/代码

中文实体链接算法模型从训练到部署的流程包括如下几步:

数据准备:首先需要准备好训练所需的数据,这些数据可以是文本文件、语料库或者是已经标注好的数据。

数据预处理:在准备好数据之后,需要进行数据预处理,包括对数据进行清洗、格式化等操作。

模型训练:接下来就是模型训练的过程,需要选择合适的算法模型,并根据预处理的数据进行训练。

模型评估:在训练完模型之后,需要对模型进行评估,检验模型的准确率和可靠性。

模型部署:最后,将训练好的模型部署到生产环境中,供用户使用。

其他:

我可以用中文向您介绍中文实体链接的一般流程。中文实体链接是将文本中的实体识别出来并将其链接到百科等网站上的相关条目的过程。通常,建立中文实体链接算法模型的步骤包括:准备训练数据。这可以是一些已经标注好的文本,其中包含了一些实体和它们在百科或其他网站上的对应条目链接。设计模型架构。这可能包括选择一些特征提取方法和使用的机器学习算法。训练模型。使用训练数据训练模型。评估模型。使用一些预先指定的评估指标来测量模型的精度。调整模型超参数。如果模型的表现不理想,可以尝试调整一些超参数,比如学习率或正则化系数,来提高模型的精度。部署模型。将训练好的模型部署到网站或其他平台上,使用户可以使用。

给出中文实体链接算法模型从训练源码

我可以给出一些中文实体链接算法模型的训练源码。

DPLP (End-to-End Distant Supervision for Chinese Named Entity Recognition and Linking):https://github.com/thunlp/DPLP

CDKG (Cross-Document Knowledge Graph Construction):https://github.com/thunlp/CDKG

CDER (Cross-Document Entity Resolution):https://github.com/thunlp/CDER

Chinese NER with BERT:https://github.com/cloverstd/chinese-ner-with-bert

希望这些资源能帮到你。如果你有任何其他问题,请随时联系我。

给出可执行的实体链接模型代码

本文链接:https://my.lmcjl.com/post/3339.html

4 评论