深度学习使用Python进行卷积神经网络的图像分类教程 好的,这次我将使用python编写如何使用卷积神经网络(CNN)进行图像分类。我希望你事先已经阅读并理解了卷积神经网络(CNN)的基本概念,这里我只讨论步骤,而不讨论卷积神经网络(CNN)中使用的术语... 我们将尝试对汽车和摩托车这两个类别进行分类。我们使用的训练数据数量是470个,用于测试/验证的数 继续阅读

Search Results for: 卷积

查询到最新的12条

深度学习笔记9:卷积层的实现(forward, backward 的实现)

用for循环实现的卷积层: 卷积运算: import time """ 定义2维度卷积的非矩阵操作""" def Conv2d(X,W, stride, pad, dilation=1):"""参数说明::param X: 输入,batchsize, in_rows, in_cols, in_channels.:param W: 权重࿰ 继续阅读

基于深度学习的人脸检测技术

用到环境 1、pycharm community edition 2022.3.2 2、Python 3.10 整篇内容都已上传至我的csdn资源中,想用的请移步。 流程 多任务级联卷积神经网络(Multi-task Cascaded Convolutional Networks, MTCNN)算法进行人脸检测 普通人脸检测 单人人脸检测 图1 单人人脸检测 分析:可以看出在单人人脸检测时,MTCNN方法很好的画出了人脸 继续阅读

神经网络笔记

多分类问题 Softmax 高级优化算法 Adam Algorithm Intuition 每个参数有不同的学习率 卷积层 每个神经元只看前一层输入的一部分 原因: 1.更快的计算 2.需要更少的训练数据(不容易过度拟合) 模型评估 成本函数 分类 训练集用来训练参数w和b,而测试集用来选择多项式模型(即参数d),训练集不能评估w和b的好坏,类似的测 继续阅读

conv2d 公式_理解keras中conv2d层的输出形状

这个问题在互联网上以各种形式被问到,而且有一个简单的答案,常常被忽略或混淆: 简单回答: Keras Conv2D层在多通道输入(例如彩色图像)的情况下,将在所有颜色通道上应用滤波器,并将结果求和,生成等效于单色卷积输出图像。在 (1)您正在使用CIFAR图像数据集进行培训,该数据集由32x32颜色图像组成,即每个图像都是形状(32,32,3)(RGB=3个通道 继续阅读

Pytorch——Conv2d、conv2d

Conv2d、conv2d是pytorch中进行卷积操作的2个类,虽然只是首字母大小写不同,使用起来方法也不一样,一个是类,一个是函数。 1 Conv2d Conv2d是torch.nn中的类 1.1 初始化 CLASS torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups 继续阅读

大语言模型会引发第四次产业革命——智能革命吗?

很多小伙伴看的是眼花缭乱,那究竟这些模型有没有差异?如果有差异,差异在哪里? 到底什么是大模型?到底大模型有什么用呢? 第一章 引言 过去10年的人工智能产品的成功,都归功于以为深度卷积、训练神经网络等为核心算法+NVIDIA显卡驱动算力+规模化监督标注下的深度学习1.0范式。也就是深度学习1.0对于AI产业是基础性的生产力变革,而在这个基础上应用这些技术构建的产品和服务,那都是在这个生产力框架下的上层应用。这是过往看到的技术推动生产力革命,带动产品服务产业化的路径。 最近 继续阅读

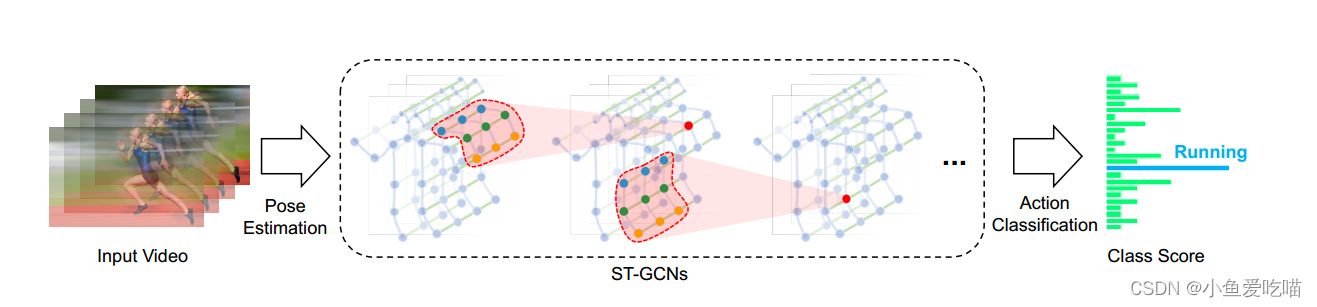

ST-GCN 论文解读

论文名称:Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recognition论文下载:https://arxiv.org/pdf/1801.07455.pdf论文代码:https://github.com/yysijie/st-gcn 论文:基于骨骼动作识别的时空图卷积网络 对视频进行姿态估计,在骨架序列上构造时空图&# 继续阅读

Deformable DETR模型学习记录

引言 Deformable-DETR的主要贡献: 1,结合可变形卷积的稀疏空间采用和Transformer的全局关系建模能力,提出可变形注意力机制模型,使其计算量降低,收敛加快。 2,使用多层级特征,但不使用FPN,对小目标有较好效果。 改进与创新 可变形注意力 可变形注意力提出的初衷是为了解决Transformer的Q,K的运算数据量巨大问题。作者认为Q没必要与 继续阅读

ReduceNet

本文直接采用VanillaNet的方案重新开始构建模型ReduceNet。按照VanillaNet的方式极限压缩网络深度至单层 前几天在知乎上看到华为提出的一个VanillaNet,其中的一个设计点和我一直想实现的功能非常类似,即训练阶段的时候模型是比较深的网络,推理的时候会自动变成比较浅的网络。起初我一直想缓渐地暴力地丢掉卷积层,结果不能如愿,模型性能会在训练阶段的最后几个epoch一直退化,模型变成毫无用处 继续阅读

ChatGPT原理解析

文章目录Transformer模型结构构成组件整体流程GPT预训练微调模型GPT2GPT3局限性GPT4相关论文 Transformer Transformer,这是一种仅依赖于注意力机制而不使用循环或卷积的简单模型,它简单而有效,并且在性能方面表现出色。 在时序模型中,2017年最常用的模型是循环神经网络(RNN),RNN是一种序列模型,通过将之前的信息存储在隐藏状态中,使得它能够有效 继续阅读

ABCNet_v2——优秀的神经网络模型

ABCNet_v2是一个出色的神经网络模型,它可以高效地完成许多复杂的任务,包括图像识别、语言处理和机器翻译等。它的性能比许多常规模型更加优越,已经被广泛地应用于各种领域。 一、结构概述 ABCNet_v2基于Deep Residual Learning思想设计,主要由卷积层和全连接层组成。为了更好地预测不同尺度的特征,它还引入了金字塔式的卷积层结构。其中,每个卷积层包含K个卷积核,每个卷积核都有相同的大小。由于该模型采用通道注意力机制,它逐渐聚焦于模型拥有最 继续阅读