这两个月我过得很神奇。这两个月,新冠疫情在广东肆虐得挺严重,尤其是在广州、东莞以及深圳,我们的生活就只有打疫苗、测核酸和隔离这三件事。我是今年5月才知道原来有西班牙语的字幕组在做YSBLF的翻译,而且已经做了好几年了。不过他们视频源的质量跟20年前没有本质区别。2021-05-13我知道了NBC正在播YSBLF,同步在网络上放出。那时解锁了116集,也就是最后放出的是126集(在最新的没有出全之前,默认最后10集加锁,只供会员观看)。昨天,2021-06-29,他们把最后一集也解锁了 继续阅读

Search Results for: 149集

查询到最新的12条

聚沙计划第三节:火车头/py工具批量采集

我们大流量采集站课程录制出来后需要用到一些工具软件来采集内容,其实这些采集工具,软件使用起来都挺简单的,大多数需要用到的参数我都是配置好了之后直接导出来的。 但是为了防止很多新手朋友拿到软件不会使用,所以我录制了一份使用教程供咱们展友会朋友使用。 一般情况下很多人采集内容都是用火车头直接针对不同的网站,撰写不同的采集规则来实现采集别人网站内容。 但这样采集会出现一个问题,就是基本上都是采集别人网站已有的内容,我个人不太愿意去采集一些 继续阅读

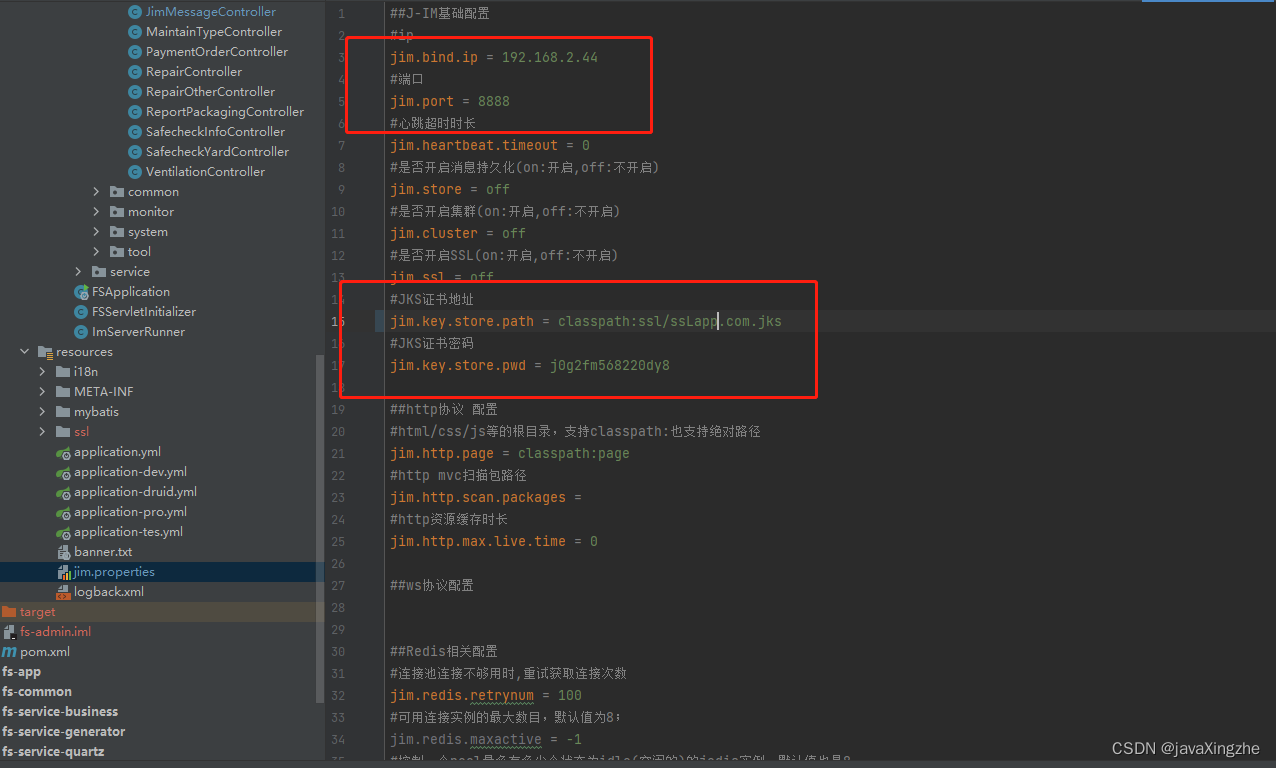

springboot集成J-IM+vue实现简单的聊天功能

前言:看了demo自己摸索着集成了一下,特此记录 一、引入依赖 <!-- jim-server --> <dependency><groupId>org.j-im</groupId><artifactId>jim-server</artifactId><version>3.0.0.v20200501-RELEASE</version> </depend 继续阅读

Centos7.3 RabbitMQ分布式集群搭建示例

本文介绍了Centos7.3 RabbitMQ分布式集群搭建示例,分享给大家,具体如下: 注意事项 centos 7.x 关闭firewall 三台机器: ? 1 2 3 继续阅读

Java 从入门到精通(续集7)——线程和并发

Java 从入门到精通(续集7)——线程和并发 一、线程的创建和启动 Java 中线程有两种创建方式:继承 Thread 类和实现 Runnable 接口。 继承 Thread 类示例代码: public class MyThread extends Thread {@Overridepublic void run() {System.out.println("thread is running");} 继续阅读

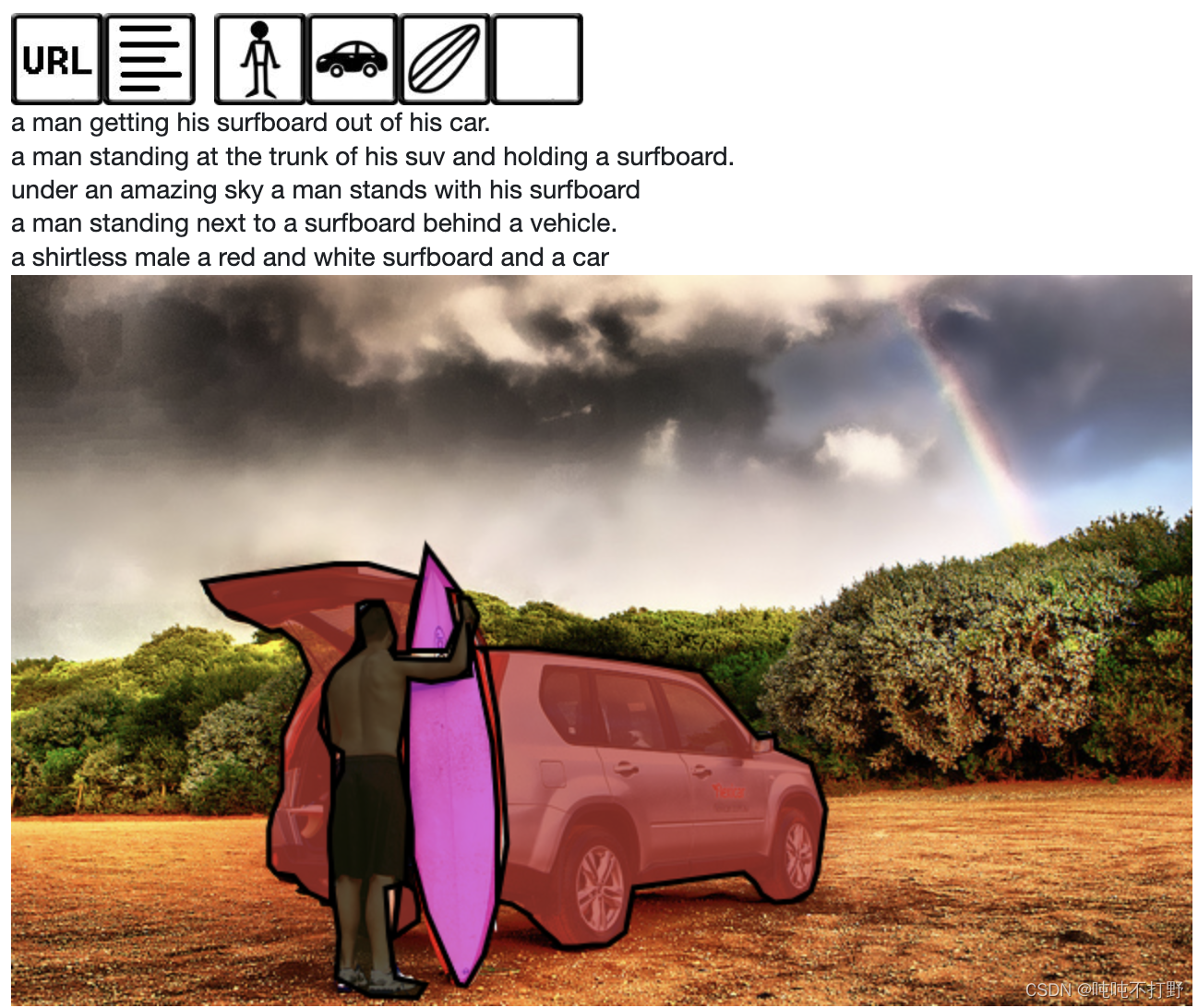

OpenMMLab-AI实战营第二期——相关1. COCO数据集格式和pycocotools使用(目标检测方向

文章目录 1. COCO数据集1.1 COCO数据集介绍1.2 COCO数据集格式1.2.1 常见目标检测数据格式1.2.2 COCO数据集文件结构及标注文件说明1.2.3 COCO的evaluation指标 1.3 其他 2. pycocotools2.1 pycocotools简介和安装2.2 基本使用 3. 图像的EXIF使用3.1 图像的EXIF3.1.1 基本介绍3.1.2 JEPG等格式说明3.1.3 EXIF属性和对应code3.1.4 EXIF中的key和value意义&# 继续阅读

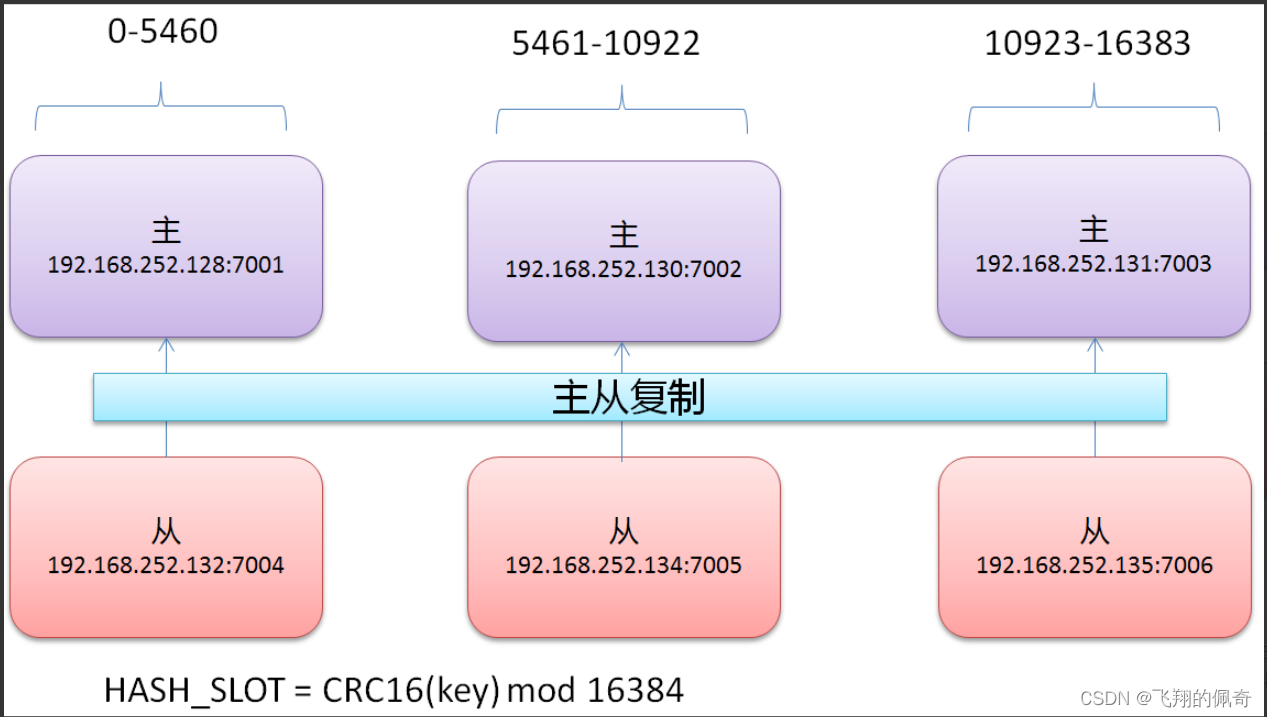

redis高可用集群搭建

redis高可用集群搭建 redis的安装配置允许远程访问重启服务检查服务是否启动架构图开始搭建集群安装ruby创建集群高可用测试redis集群的扩展将7号机添加为新的master节点添加从节点删掉一个slave节点删除master节点 redis的安装 sudo apt-get install redis-server 配置允许远程访问 sudo gedit /etc/redis/redis.conf 注释掉**#bind 127.0.0.1**行 重启服务 s 继续阅读

Java遍历集合的三种方式

对于遍历集合获取其对象,在这里总结的三种简单的方式 方式一 : 将集合变为数组,后遍历数组 ? 1 2 3 4 Object[] obj = lis 继续阅读

多快好省地使用pandas分析大型数据集

1. 简介 pandas虽然是个非常流行的数据分析利器,但很多朋友在使用pandas处理较大规模的数据集的时候经常会反映pandas运算“慢”,且内存开销“大”。 特别是很多学生党在使用自己性能一般的笔记本尝试处理大型数据集时,往往会被捉襟见肘的算力所劝退。但其实只要掌握一定的pandas使用技巧,配置一般的机器也有能力hold住大型数据集的分析。 图1 本文就将以真实数据集和运存16G 继续阅读

采集站怎么赚钱?采集站有哪些变现方式

说起做网站,做采集站,又回到了老本行了哈,展天2010年接触互联网之后先是做的淘宝,然后就是做网站,并且基本都是采集站。 并且这些年采集站手上一直都有,也陆陆续续有变现,因为采集站简单粗暴,不需要花太多的时间在上面,每天大概一个小时不到就能完成一个网站的维护,所以一直当成一个项目再做。 那么采集站怎么做: 采集站如其名,就是靠采集来的,采集就是采集不是很多人说的那种每天复制粘贴几篇文章就叫采集了,很多采集站的数据都是几十上百万,非常夸张! 继续阅读

Observability:如何把 Elastic Agent 采集的数据输入到 Logstash 并最终写入

在之前的文章 “安装独立的 Elastic Agents 并采集数据 - Elastic Stack 8.0”,我们详述了如何使用 No Fleet Server 来把数据写入到 Elasticsearch 中。在今天的文章中,我们来详述如下使用 Elastic Agents 在独立(standalone)模式下来采集数据并把数据最终通过 Logstash 来写入到 Elasticsearch 中去。 在今天的练习中,我 继续阅读

java中TreeMap集合的常用方法详解

public Map.Entry<K,V>ceilingEntry(Kkey) 返回指定的Key大于或等于的最小值的元素,如果没有,则返回null public KceilingKey(Kkey) 返回指定的Key大于或等于的最小值的Key,如果没有,则返回null public Objectclone() 返回集合的副本 public Compara 继续阅读