文章目录1.RLHF方法2.ChatGPT中的RLHF方法2.1 微调模型GPT-32.2 训练奖励模型2.3 利用强化学习进一步微调语言模型3.效果4.面临挑战5.参考 InstructGPT语言模型,是一个比 GPT-3 更善于遵循用户意图,同时使用通过我们的对齐研究开发的技术使它们更真实、毒性更小。InstructGPT 模型循环迭代的过程当中,加入了人类反馈进行训练。 比如下面的例子:几句话向6岁的孩子解析登月 可以看 继续阅读

Search Results for: InstructGPT

查询到最新的5条

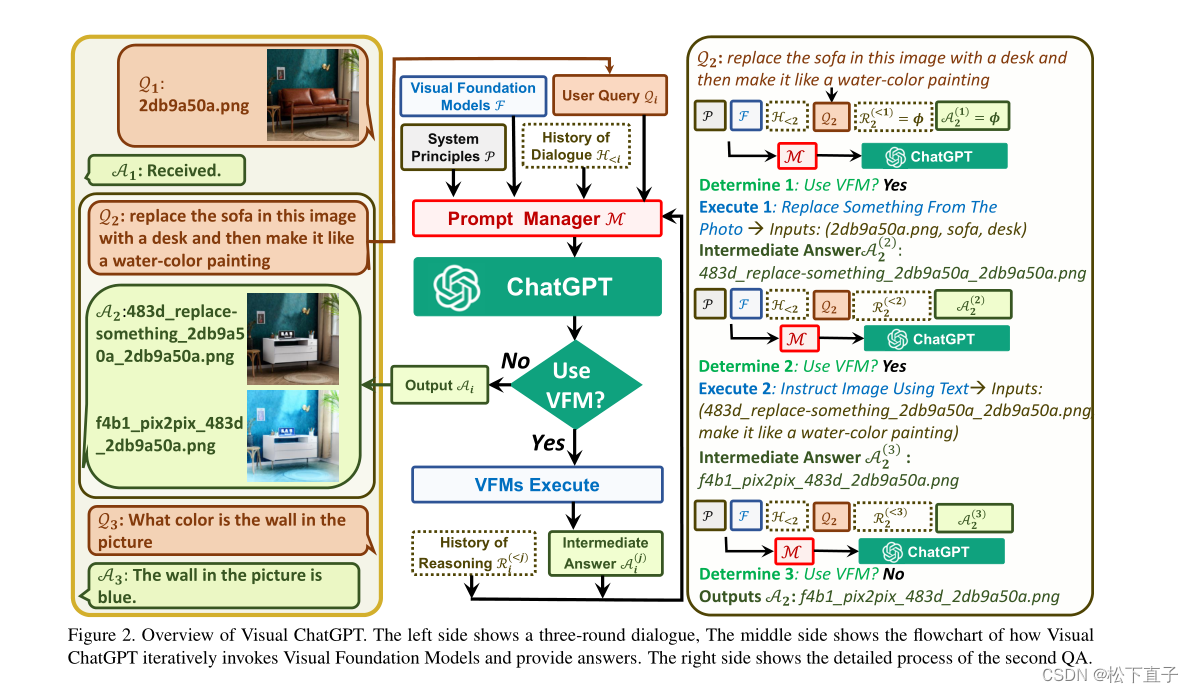

Visual ChatGPT可视化的chatgpt

Visual ChatGPT: Talking, Drawing and Editing with Visual Foundation Models 摘要 不仅发送和接收语言,还发送和接收图像提供复杂的视觉问题或视觉编辑指令,这些问题需要多个AI模型以多步骤协作提供反馈并要求纠正结果考虑到多输入/输出模型和需要视觉反馈的模型,设计了一系列提示符将可视化模型信息注入到ChatGPT中代码地址 引言 ChatGPT建立在InstructGPT的基础上 继续阅读

ChatGPT原理解析以及使用方法介绍

一、背景 这里我就直接贴上跟ChatGPT的对话作为背景输入,说真的,它的回答比我写的还要专业,具体见如下截图:二、原理 从官网介绍可以看到,ChatGPT与InstructGPT是同源的模型。那么接下来我们来看下什么是InstructGPT。从字面上来看,顾名思义,它就是指令式的GPT,“wh 继续阅读

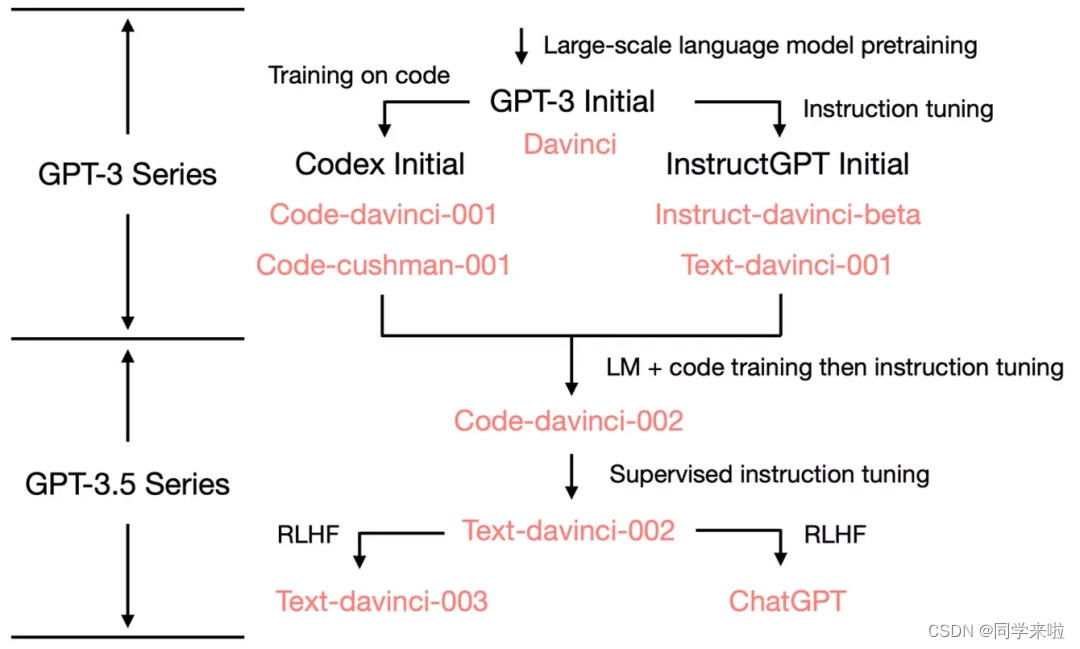

ChatGPT简要解读(三) - ChatGPT发展历程及模型训练机制

文章目录🐣 一、发展历程🔴 1、基本概念🟠 2、演化过程🐤 二、模型训练机制 🐣 一、发展历程 🔴 1、基本概念 ChatGPT是一个采用基于GPT-3.5(Generative Pre-trained Transformer 3.5)架构开发的大型语言模型,与InstructGPT模型是姊妹模型(sibling model&#x 继续阅读

ChatGPT为什么使用强化学习

最近出现很多ChatGPT相关论文,但基本都是讨论其使用场景和伦理问题,至于其原理,ChatGPT在其主页上介绍,它使用来自人类反馈的强化学习训练模型,方法与InstructGPT相同,只在数据收集上有细微的差别。 那么,InstructGPT和ChatGPT为什么使用强化学习呢?先看个示例: 先不论答案是否正确,回答依赖之前的对话, 继续阅读