什么是让ChatGPT爆火的大语言模型(LLM) 更多精彩内容: https://www.nvidia.cn/gtc-global/?ncid=ref-dev-876561 文章目录什么是让ChatGPT爆火的大语言模型(LLM)大型语言模型有什么用?大型语言模型如何工作?大型语言模型的热门应用在哪里可以找到大型语言模型大型语言模型的挑战 AI 应用程序正在总结文章、撰写故事和进行长时间对话——而大型语言模型正在承担繁重的工作。 大型语言模型或 继续阅读

Search Results for: LLM模型

查询到最新的12条

ChatGPT基础知识系列之大型语言模型(LLM)初识

ChatGPT基础知识系列之大型语言模型(LLM)初识 ChatGPT本质是一个对话模型,它可以回答日常问题、挑战不正确的前提,甚至会拒绝不适当的请求,在去除偏见和安全性上不同于以往的语言模型。ChatGPT从闲聊、回答日常问题,到文本改写、诗歌小说生成、视频脚本生成,以及编写和调试代码均展示了其令人惊叹的能力。在OpenAI公布博文和试用接口后,ChatGPT很快以令人惊叹的对话能力“引爆”网络,本文主要从技术角度,梳理ChatGPT背后涉及的技术工作LLM,来阐述其如此强大的原因;同时思考 继续阅读

ChatDoctor(LLM大模型用于医疗对话)

ChatDoctor: A Medical Chat Model Fine-tuned on LLaMA Model using Medical Domain Knowledge paper:https://arxiv.org/pdf/2303.14070.pdf 通用领域中最近的大型语言模型 (LLM),例如 ChatGPT,在遵循指令和产生类似人类的响应方面取得了显着的成功。 但是语言模型并未针对医学领域量身定制,导致答案准确性较差 继续阅读

ChatLaw:中文法律大模型

文章目录 Abstract1. Introduction2. Dataset3. Training Process3.1 ChatLaw LLM3.2 Keyword LLM3.3 Law LLM 4. Experiment and Analysis5. Conclusions Abstract LLM已经展现出在各个领域彻底改变自然语言处理任务的潜力,引发了人们对特定于垂直领域的大模型的极大兴趣。然而,与BloombergGPT和Fi 继续阅读

ChatGPT 的工作原理:机器人背后的模型

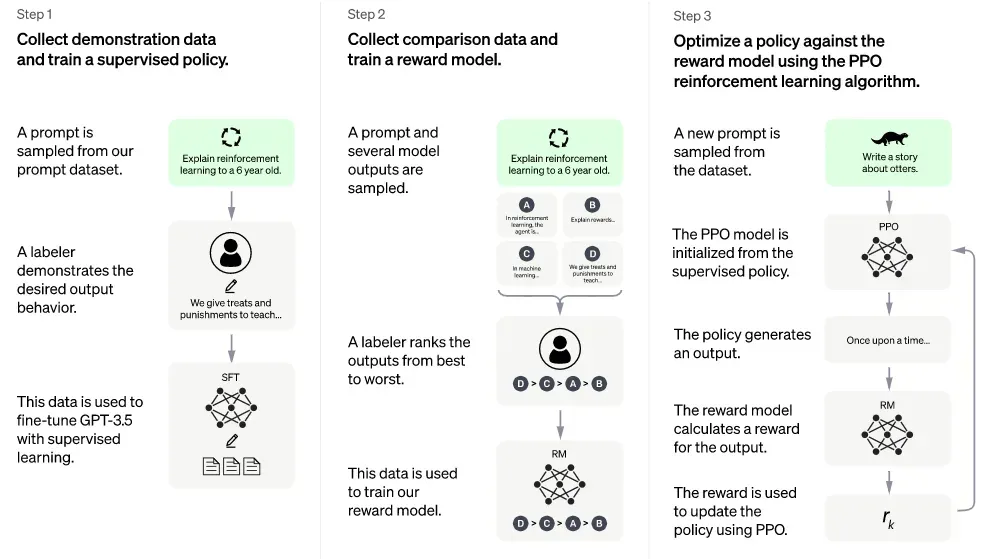

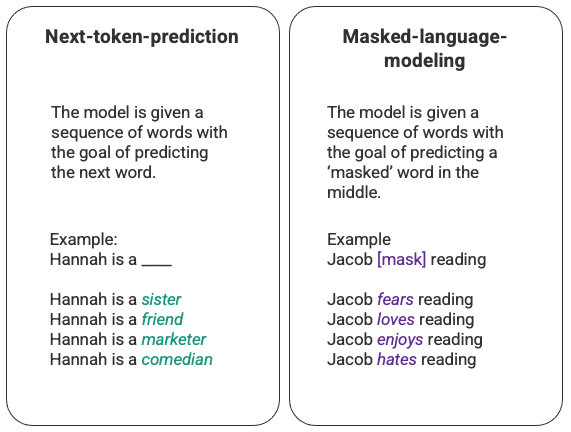

这篇对支持 ChatGPT 的机器学习模型的温和介绍,将从大型语言模型的介绍开始,深入探讨使 GPT-3 得到训练的革命性自我注意机制,然后深入研究人类反馈的强化学习,使 ChatGPT 与众不同的新技术。 大型语言模型 ChatGPT 是一类被称为大型语言模型 (LLM) 的机器学习自然语言处理模型的外推。LLM 消化大量文本数据并推断文本中单词之间的关系。随着我们看到计算能力的进步,这些模型在过去几年中得到了发展。随 继续阅读

深入解析大型语言模型:从训练到部署大模型

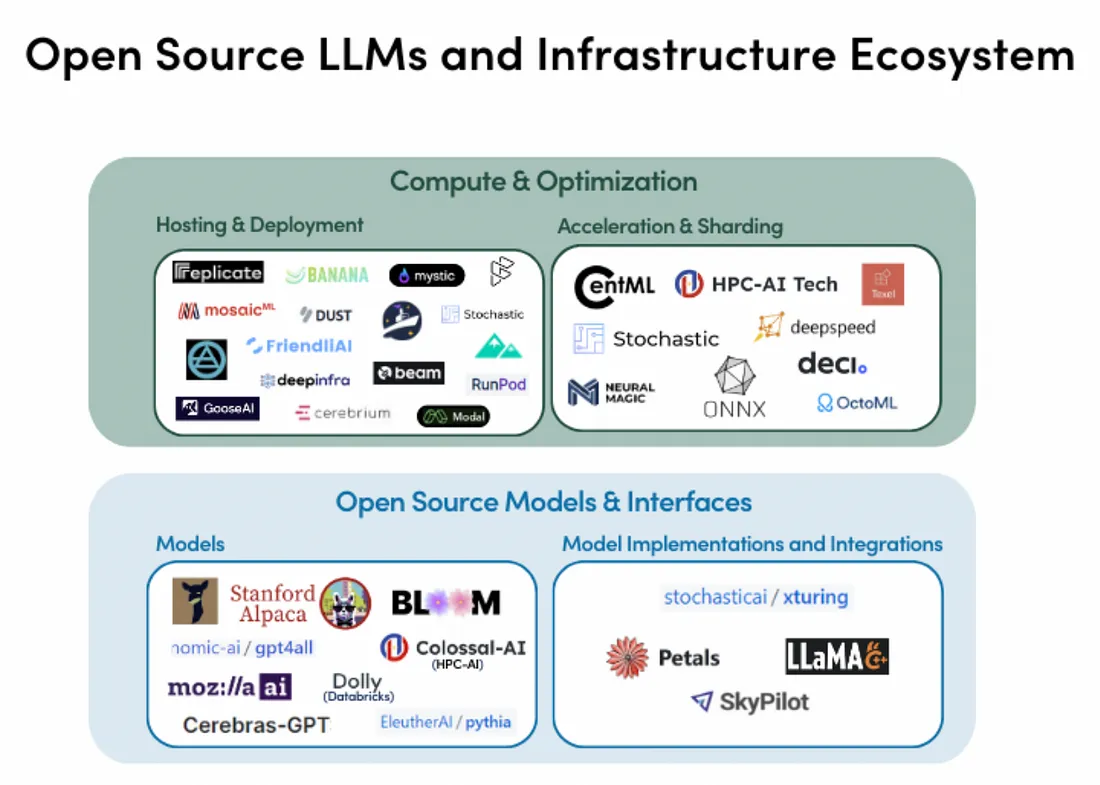

简介 随着数据科学领域的深入发展,大型语言模型—这种能够处理和生成复杂自然语言的精密人工智能系统—逐渐引发了更大的关注。 LLMs是自然语言处理(NLP)中最令人瞩目的突破之一。这些模型有潜力彻底改变从客服到科学研究等各种行业,但是人们对其能力和局限性的理解尚未全面。 LLMs依赖海量的文本数据进行训练,从而能够生成极其准确的预测和回应。像GPT-3和T5这样的LLMs在诸如语言翻译、问答、以及摘要等多个NLP任务中已经 继续阅读

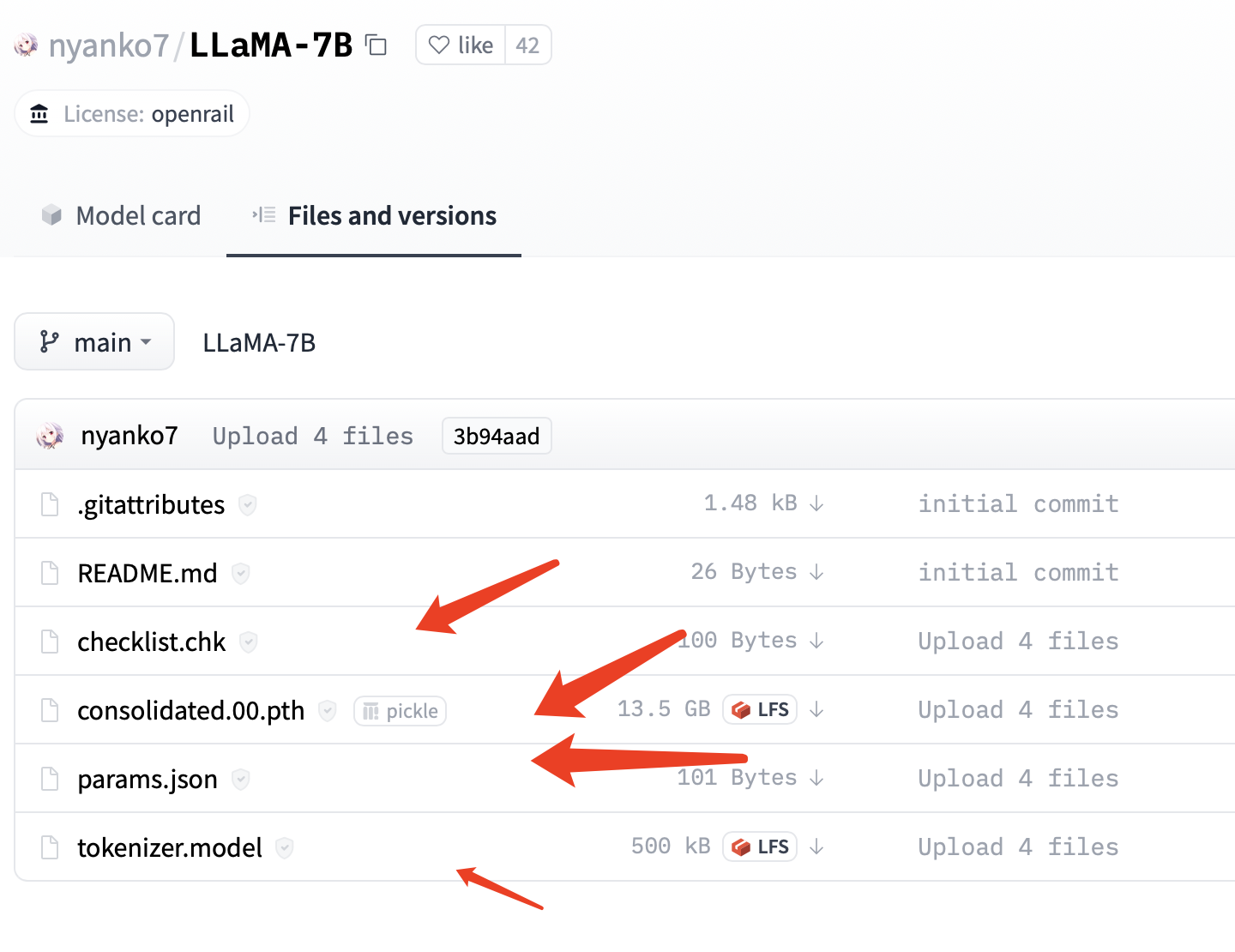

本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿、130亿、330亿和650亿这4种参数规模的模型,参数是指神经网络中的权重和偏置等可调整的变量,用于训练和优化神经网络的性能,70亿意味着神经网络中有70亿个参数,由此类推。 在一些大型神经 继续阅读

训练ChatGPT的必备资源:语料、模型和代码库完全指南

前言近期,ChatGPT成为了全网热议的话题。ChatGPT是一种基于大规模语言模型技术(LLM, large language model)实现的人机对话工具。但是,如果我们想要训练自己的大规模语言模型,有哪些公开的资源可以提供帮助呢?在这个github项目中,人民大学的老师同学们从模型参数(Checkpoints)、语料和代码库三个方面,为 继续阅读

【类ChatGPT】本地CPU部署中文羊驼大模型LLaMA和Alpaca

昨天在github上看到一个在本地部署中文大模型的项目,和大家分享一下。先把地址po出来。 项目名称:中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs) 项目地址:https://github.com/ymcui/Chinese-LLaMA-Alpaca 以下是原github中给出的体验GIF,可以看到这个模型还是具备一定的指令理解和上下文对话能力的。 继续阅读

大模型时代来临,智能文档处理该走向何方?

自去年ChatGPT发布以来,大语言模型(Large Language Model, LLM)的发展仿佛瞬间驶入了快车道,每天都能听到对相关话题的讨论。 按照现行的标准,能被称为大语言模型至少要满足以下四个条件: 模型:基于自回归语言模型,参数量超过百亿。能力:具有思维链、情景学习等涌现能力,能够执行人类的指令。对话:可以直接和人类 继续阅读

【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型

Chinchilla:训练计算利用率最优的大语言模型 《Training Compute-Optimal Large Language Models》 论文地址:https://arxiv.org/pdf/2203.15556.pdf 一、简介 近期出现了一些列的大语言模型(Large Language Models, LLM),最大的稠密语言模型已经超过了500B的参数。这些大的自回归transformers已经在各个任务上展现 继续阅读

微软的 LLM-Augmenter 提高了 ChatGPT 的事实答案分数(教程含源码)

在发布后的三个月里,ChatGPT 能够对范围广泛的问题生成类似人的、连贯的和信息丰富的回答,这使得 OpenAI 对话式大型语言模型 (LLM) 从好奇变成了吸引公众讨论 AI 优缺点的磁石。虽然有很多赞誉,但也有严重的担忧——特别是关于 ChatGPT 偶尔产生误导性或事实不正确的反应,这被描述为“幻觉”。这些担忧以及 ChatGPT 无法访问互联网来更新其知识,导致一些人认为此类 LLM 还没有为现实世界的关键任务应用程序做好准备。 在新论文Check Your Facts and Tr 继续阅读