Paper:Transformer模型起源—2017年的Google机器翻译团队—《Transformer:Attention Is All You Need》翻译并解读-20230802版 目录 相关文章 Paper:Transformer模型起源—2017年的Google机器翻译团队—《Transformer:Attention Is All You Need》翻译并解读-20171206版 Paper&# 继续阅读

Search Results for: Transformer模型起源

查询到最新的12条

【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型

Chinchilla:训练计算利用率最优的大语言模型 《Training Compute-Optimal Large Language Models》 论文地址:https://arxiv.org/pdf/2203.15556.pdf 一、简介 近期出现了一些列的大语言模型(Large Language Models, LLM),最大的稠密语言模型已经超过了500B的参数。这些大的自回归transformers已经在各个任务上展现 继续阅读

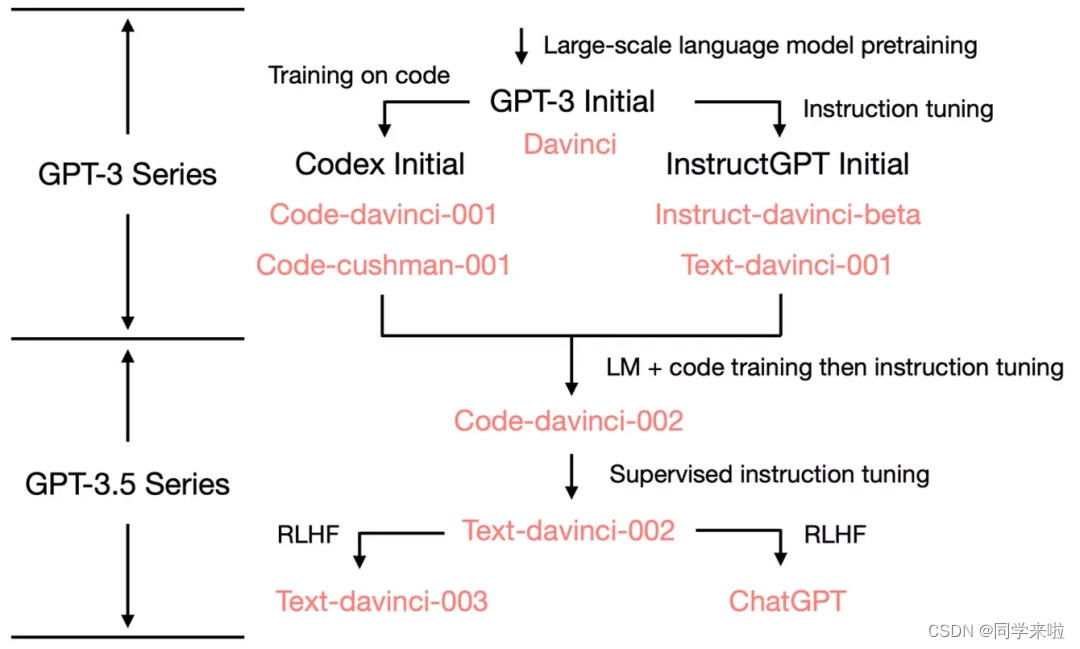

人工智能大模型之ChatGPT原理解析

前言 ChatGPT基本信息&原理 ChatGPT基本信息 研发公司:OpenAI 创立年份:2015年 创立人:马斯克、Sam Altman及其他投资者 目标:造福全人类的AI技术 GPT(Generative Pre-trained Transformer):生成式预训练语言模型 GPT作用:问答,生成文章等 模型发展史 参数量(单位:亿) 预训练数据量( 继续阅读

【回答问题】ChatGPT上线了!推荐30个以上比较好的自然语言处理模型

【回答问题】ChatGPT上线了!推荐40个以上比较好的自然语言处理模型以及github源码? BERT (Bidirectional Encoder Representations from Transformers): https://github.com/google-research/bert GPT (Generative Pre-training Transformer): https://github.com/openai/gpt-3 Transfo 继续阅读

聊聊当下火热的通用人工智能--ChatGPT引爆的大模型时代

前言 目前人工智能领域实在是IT界火热的名字,使IT、互联网又火热了一把,与以往不同,这次着实让模型、算法、AI、大模型、超大规模训练、千亿级参数等不绝于耳。作为一个入门,下面进行一些简单的学习总结 ChatGPT——目前还只能是GPT ChatGPT(全名:Chat Generative Pre-trained Transformer),美国OpenAI 研发的聊天机器人程序& 继续阅读

Azure OpenAI 官方指南04|Codex的模型结构和应用场景

Codex 是 OpenAI 公司推出的 GPT-3(Generative Pre-trained Transformer – 3)的多个派生模型之一。它是基于GPT语言模型,使用代码数据进行 Fine-Tune(微调)而训练出的专门用于代码生成/文档生成的模型。Codex 模型参数从12M到12B不等,是目前最强的编程语言预训练模型。Codex 能够帮助程序员根据函数名和注释自动补全代码、直接生成代码、自动 继续阅读

Deformable DETR模型学习记录

引言 Deformable-DETR的主要贡献: 1,结合可变形卷积的稀疏空间采用和Transformer的全局关系建模能力,提出可变形注意力机制模型,使其计算量降低,收敛加快。 2,使用多层级特征,但不使用FPN,对小目标有较好效果。 改进与创新 可变形注意力 可变形注意力提出的初衷是为了解决Transformer的Q,K的运算数据量巨大问题。作者认为Q没必要与 继续阅读

大语言模型工程化服务系列之三--------姜子牙大模型fastapi接口服务

姜子牙大语言模型fastapi接口服务 姜子牙大模型效果还可以,但是如何将它的模型文件部署成自己的服务呢,下面是教程代码 一、安装环境 python 版本 3.7 transformer最新版本 二、姜子牙fastapi接口服务代码 1.服务端代码 import uvicorn from fastapi import FastAPI from pydantic import BaseModel from transformers import Auto 继续阅读

ChatGPT基础组件Transformer的代码实现(纯净版Transformer实现)

最近ChatGPT大火,其实去年11月份就备受关注了,最近火出圈了,还是这家伙太恐怖了,未来重复性的工作很危险。回归主题,ChatGPT就是由无数个(具体也不知道多少个,哈哈哈哈)Transformer语言模型组成,Transformer最开始在2017年提出,目的是解决序列数据的训练,大多数应用到了语言相关,最近 继续阅读

全面剖析OpenAI发布的GPT-4比其他GPT模型强在哪里

最强的文本生成模型GPT-4 一、什么是GPT-4二、GPT-4的能力三、和其他GPT模型比较3.1、增加了图像模态的输入3.2、可操纵性更强3.3、复杂任务处理能力大幅提升3.4、幻觉、安全等局限性的改善3.6、风险和缓解措施改善更多安全特性3.7、可预测的扩展 四、与之前 GPT 系列模型比较五、和ChatGPT相比有更多的应用亮点六、总结 一、什么是GPT-4 GPT-4(Generative Pre-trained Transformer 4) 继续阅读

【ChatGPT】基于tensorflow2实现transformer(GPT-4)

请记住,您是一位NLP领域的专家和优秀的算法工程师。使用带有 tensorflow2.0 subclass api 的 python 从头开始实现 transformer 模型。 全部内容如下: 构建transformer模型架构和依赖层;生成并预处理一些假样本数据,用于训练上面构建的模型;上面生成的样本数据的训练模型示例教程;上面生成的样本数据的预测模型示例教程;上面生成的示例数据的部署模型示例 继续阅读

ChatGPT简要解读(三) - ChatGPT发展历程及模型训练机制

文章目录🐣 一、发展历程🔴 1、基本概念🟠 2、演化过程🐤 二、模型训练机制 🐣 一、发展历程 🔴 1、基本概念 ChatGPT是一个采用基于GPT-3.5(Generative Pre-trained Transformer 3.5)架构开发的大型语言模型,与InstructGPT模型是姊妹模型(sibling model&#x 继续阅读