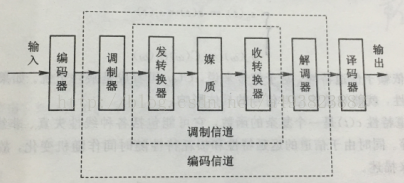

一、信道的定义与调制信道的数学模型 1.信道的定义与分类 信道(Channel)是指以传输媒质为基础的信号通道。根据新到的定义,如果信道仅是指信号的传输媒质,这种信道称为狭义信道;如果这种信道不仅是传输媒质,而且包括通信系统中的转换装置,这种信道称为广义信道。 狭义信道按照传输媒质的特性可分为有线信道和无线信道。有线信道包括对称电缆、同轴电缆及光纤等。无线信道包括地波传播、短波电离层反射、超短 继续阅读

Search Results for: m信道衰落模型

查询到最新的12条

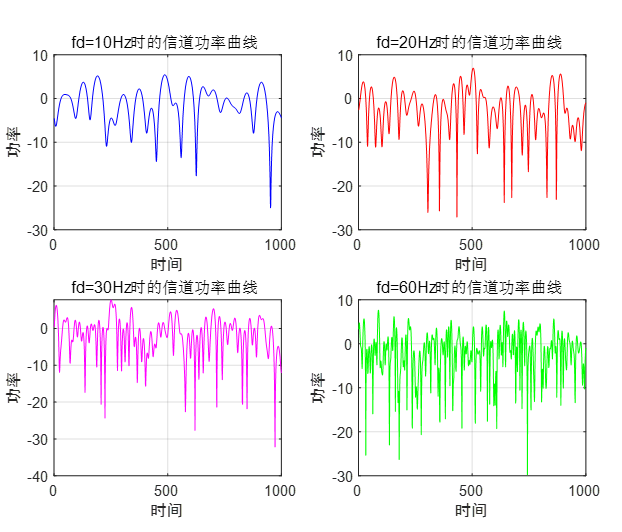

《通信原理》多径衰落信道仿真2

一、实验内容 1.利用改进的jakes模型来产生单径的平坦型瑞利衰落信道。 (1)创建rayleigh.m文件。 1)计算振荡器数目; 2)计算信道函数的实部; 3)计算信道函数的虚部; 4)乘归一化功率系数得到传输函数; 5)计算冲激响应函数; (2)创建rayleigh1.m文件。 继续阅读

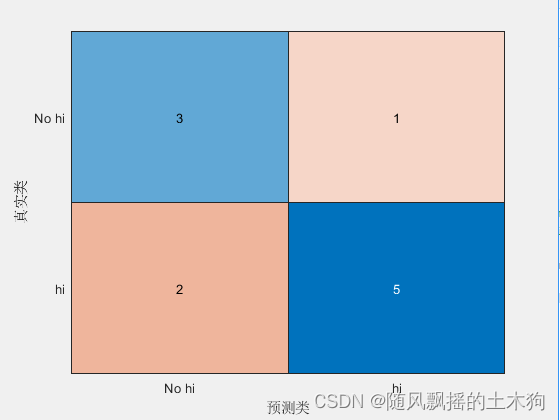

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的评估度量介绍 网格搜索、随机搜索和贝叶斯优化是寻找机器学习模型参数最佳组合、交叉验证每个参数并确定哪一个参数具有最佳性能的常用方法。 一、 评估指标 1、分类 1.1 准确性 1.2 精度 1.3 召回 1.4 F1值 1.5 F0.5值 1.6 F2值 1.7 计算评估指标的功能 2、回归 2.1 平均绝对误差 2.2 均方误差 2.3 均方根误差 二、 基于F1值执 继续阅读

国内首个类 ChatGPT 模型:复旦大学 MOSS 今日正式开源,RTX 3090 显卡可运行

4 月 21 日消息,复旦大学自然语言处理实验室开发的新版 MOSS 模型今日正式上线,成为国内首个插件增强的开源对话语言模型。 目前,MOSS 模型已上线开源,相关代码、数据、模型参数已在 Github 和 Hugging Face 等平台开放,供科研人员下载。 据介绍,MOSS 是一个支持中英双语和多种插件的开源对话语言模型,moss-moon 系列模型具有 160 亿参数&# 继续阅读

ChatDoctor(LLM大模型用于医疗对话)

ChatDoctor: A Medical Chat Model Fine-tuned on LLaMA Model using Medical Domain Knowledge paper:https://arxiv.org/pdf/2303.14070.pdf 通用领域中最近的大型语言模型 (LLM),例如 ChatGPT,在遵循指令和产生类似人类的响应方面取得了显着的成功。 但是语言模型并未针对医学领域量身定制,导致答案准确性较差 继续阅读

从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进...

图文原创:亲爱的数据 “参数服务器之父” Alex Smol教授已于2023年2月从美国著名公有云厂商亚马逊云科技(AWS)离职,创办了一家名为Boson.ai的人工智能公司。 公元2023年的春天,显然也是人工智能的又一春。 Alex Smol教授重新出发并在领英公布了新目标: “scalable foundation models”(可扩展基础模型)。 这类厂商可被视为Cha 继续阅读

全网最详细中英文ChatGPT-GPT-4示例文档-ML/AI语言模型导师从0到1快速入门——官网推荐的48种

从0到1快速入门ML/AI语言模型导师应用场景Introduce 简介setting 设置Prompt 提示Sample response 回复样本API request 接口请求python接口请求示例node.js接口请求示例curl命令示例json格式示例其它资料下载 ChatGPT是目前最先进的AI聊天机器人,它能够理解图片和文字,生成流畅和有趣的回答。如果你想跟上AI时代的潮流,你一定要学会使用ChatGPT。如果你想了解Open 继续阅读

Deformable DETR模型学习记录

引言 Deformable-DETR的主要贡献: 1,结合可变形卷积的稀疏空间采用和Transformer的全局关系建模能力,提出可变形注意力机制模型,使其计算量降低,收敛加快。 2,使用多层级特征,但不使用FPN,对小目标有较好效果。 改进与创新 可变形注意力 可变形注意力提出的初衷是为了解决Transformer的Q,K的运算数据量巨大问题。作者认为Q没必要与 继续阅读

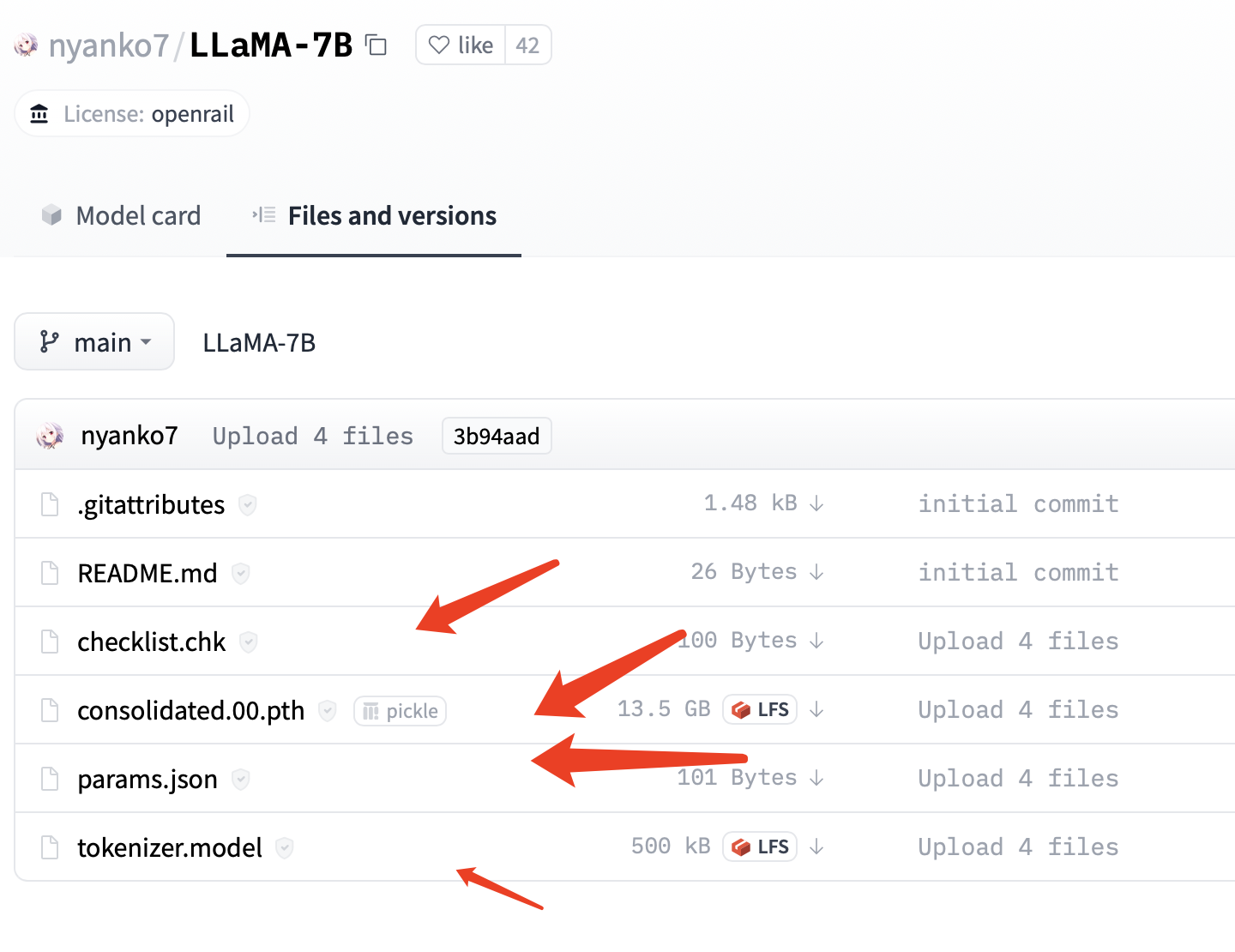

【类ChatGPT】本地CPU部署中文羊驼大模型LLaMA和Alpaca

昨天在github上看到一个在本地部署中文大模型的项目,和大家分享一下。先把地址po出来。 项目名称:中文LLaMA&Alpaca大语言模型+本地部署 (Chinese LLaMA & Alpaca LLMs) 项目地址:https://github.com/ymcui/Chinese-LLaMA-Alpaca 以下是原github中给出的体验GIF,可以看到这个模型还是具备一定的指令理解和上下文对话能力的。 继续阅读

本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿、130亿、330亿和650亿这4种参数规模的模型,参数是指神经网络中的权重和偏置等可调整的变量,用于训练和优化神经网络的性能,70亿意味着神经网络中有70亿个参数,由此类推。 在一些大型神经 继续阅读

【自然语言处理】【大模型】DeepMind的大模型Gopher

DeepMind的大模型Gopher 《Scaling Language Models: Methods, Analysis & Insights from Training Gopher》 论文:https://arxiv.org/pdf/2112.11446.pdf 一、简介 使用自然语言进行交流是智能的核心,因为其可以在人类和人工智能系统之间有效地分享想法。语言的普遍性使我们能够使用自然语言输入来表达许多智能任务,并产生 继续阅读

为什么对ChatGPT、ChatGLM这样的大语言模型说“你是某某领域专家”,它的回答会有效得多?(二)...

“ 介绍神经网络的基本概念和结构,讨论训练实践、技巧以及网络规模的大小对模型能力的影响。同时介绍嵌入(Embeddings)概念,将高维数据映射到低维空间。通过本文,您将对神经网络有更深入的理解,有助于后面理解 ChatGPT 是怎么做的,为什么它有效。” 01 — 神经网络 那么我们用于图像识别等任务的典型模型实际上是如何工作的呢?当前最流行且最成功的方法是使用神经网络。神经网络 继续阅读