这是一个 Linux 命令,用于重新挂载文件系统并将其设置为可读写模式。它的语法如下: mount -o remount,rw [文件系统] 其中,“-o”参数用于指定挂载选项,“remount”选项用于重新挂载文件系统,“rw”选项用于将文件系统设置为可读写模式。您需要将 [文件系统] 替换为您要重新挂载的文件系统的路径。 例如,如果您要将根文件系统重新挂载为可读写模式,可以使用以下命令& 继续阅读

Search Results for: rw

查询到最新的12条

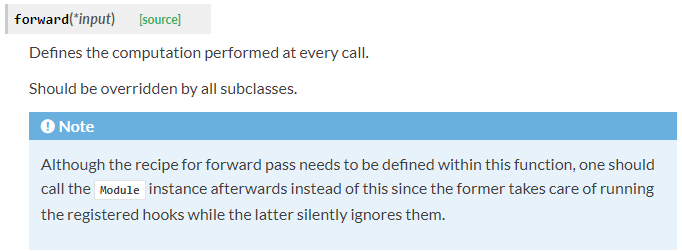

Pytorch中什么时候调用forward()函数

Module类是nn模块里提供的一个模型构造类,是所有神经网络模块的基类,我们可以继承它来定义我们想要的模型。下面继承Module类构造本节开头提到的多层感知机。这里定义的MLP类重载了Module类的__init__函数和forward函数。它们分别用于创建模型参数和定义前向计算。前向计算也即正向传播。 import torch from torch import nnclass MLP(nn.Module):# 声明带有模型参数的层,这里声明了两个 继续阅读

UserWarning

UserWarning 用户代码所产生警告的基类。本文地址:https://my.lmcjl.com/exception/user-warning版权声明:个人博客原创文章,转载请注明出处和网址。,欢迎加入。 继续阅读

旧闻:Kindle Paperwhite第二代固件升级:5.6.1版

是的,这是一篇旧文,但不知为什么Kindle一直没有算动升级,今天看到某新闻时才知道Kindle Paperwhite第二代最新固件升级为5.6.1版,而现在我手上的Kindle Paperwhite第二代固件版本还是:5.4.5.1,所以你手上有Kindle Paperwhite第二代那就升级去吧。 固件下载地址:http://www.amazon.cn/gp/help/customer/display.html?nodeId=201307450 本次更新包括性能改进和以下功能优化: 继续阅读

transformer学习笔记:Feed-Forward Network

transformer结构在Muli-Head Attention层之后还添加了一层Feed-Forward层。Feed-Forward层包括两层全连接层以及一个非线性激活函数ReLu。 注意到在Mui-Head Attention的内部结构中,我们进行的主要都是矩阵乘法(scaled Dot-Product Attention),即进行的都是线性变换,而线性变换的学习能力是不如非线性变化的强的,所以Mui-Head Attention的 继续阅读

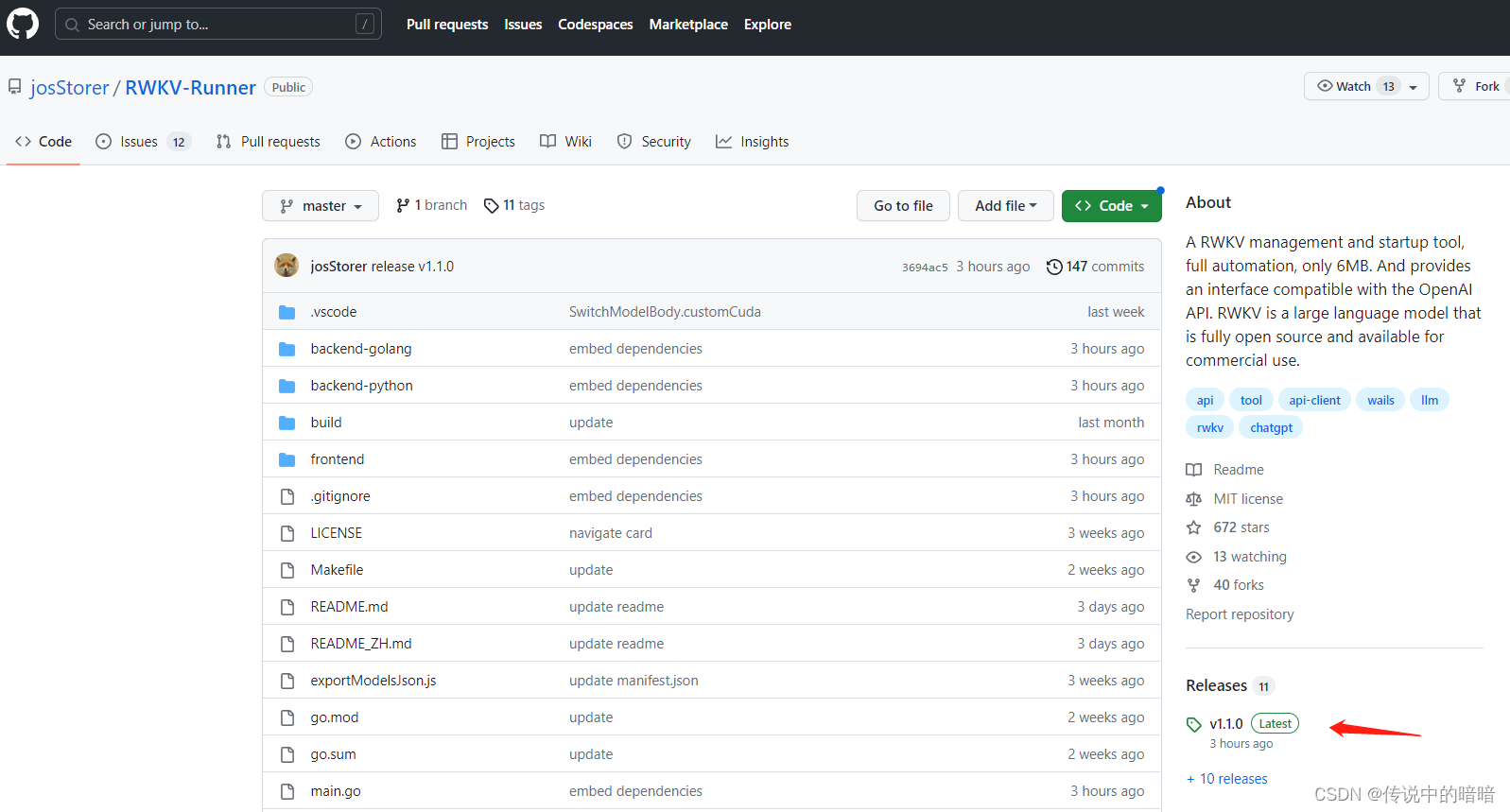

本地化部署AI语言模型RWKV指南,ChatGPT顿时感觉不香了。

之前由于ChatGpt处处受限,又没法注册的同学们有福了,我们可以在自己电脑上本地化部署一套AI语言模型,且对于电脑配置要求也不是非常高,对它就是RWKV。 关于RWKV RWKV是一个开源且允许商用的大语言模型,灵活性很高且极具发展潜力,它是一种纯 RNN 的架构,能够进行语言建模,目前最大参数规模已经做到了 14B,该模型训练由Stability赞助。本文发布时R 继续阅读

pytorch 中的 forward 的使用与解释

转自:https://blog.csdn.net/xu380393916/article/details/97280035,感谢作者分享。 在使用pytorch的时候,模型训练时,不需要使用forward,只要在实例化一个对象中传入对应的参数就可以自动调用 forward 函数 class Module(nn.Module):def __init__(self):super(Module, self).__init__()# 继续阅读

python中forward是什么意思_pytorch 中forward 的用法与解释说明

前言 最近在使用pytorch的时候,模型训练时,不需要使用forward,只要在实例化一个对象中传入对应的参数就可以自动调用 forward 函数 即: forward 的使用 class Module(nn.Module): def __init__(self): super(Module, self).__init__() # ...... def forward(self, x): # ...... return x data = ..... #输入数据 # 实例化一个对象 modul 继续阅读

forward请求转发

请求转发(forward):一种服务器内部的资源跳转方式 实现方式: 创建两个Servlet,并配置他们的访问路径 import javax.servlet.ServletException; import javax.servlet.annotation.WebServlet; import javax.servlet.http.HttpServlet; import javax.servlet.http 继续阅读

PyTorch之前向传播函数forward

神经网络的典型处理如下所示: 1. 定义可学习参数的网络结构(堆叠各层和层的设计); 2. 数据集输入; 3. 对输入进行处理(由定义的网络层进行处理),主要体现在网络的前向传播; 4. 计算loss ,由Loss层计算; 5. 反向传播求梯度; 6. 根据梯度改变参数值,最简单的实现方式(SGD)为: we 继续阅读

深度学习笔记9:卷积层的实现(forward, backward 的实现)

用for循环实现的卷积层: 卷积运算: import time """ 定义2维度卷积的非矩阵操作""" def Conv2d(X,W, stride, pad, dilation=1):"""参数说明::param X: 输入,batchsize, in_rows, in_cols, in_channels.:param W: 权重࿰ 继续阅读

CTF-sql注入(X-Forwarded-For)【简单易懂】

目录 环境配置 信息探测 AWVS漏洞扫描 漏洞利用 扫描数据库 扫描表名 扫描字段值 扫描用户名和密码 环境配置 kali 192.168.20.128 靶机 192.168.20.132 链接:https://pan.baidu.com/s/1vUYqkBnWkrfXvdC99nOsSQ 提取码:4p7w 信息探测 nmap -sV ip nmap -A -v ip nikto -host http://ip 探 继续阅读