前言 ChatGPT基本信息&原理 ChatGPT基本信息 研发公司:OpenAI 创立年份:2015年 创立人:马斯克、Sam Altman及其他投资者 目标:造福全人类的AI技术 GPT(Generative Pre-trained Transformer):生成式预训练语言模型 GPT作用:问答,生成文章等 模型发展史 参数量(单位:亿) 预训练数据量( 继续阅读

Search Results for: 将原模型参数层改造

查询到最新的12条

从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进...

图文原创:亲爱的数据 “参数服务器之父” Alex Smol教授已于2023年2月从美国著名公有云厂商亚马逊云科技(AWS)离职,创办了一家名为Boson.ai的人工智能公司。 公元2023年的春天,显然也是人工智能的又一春。 Alex Smol教授重新出发并在领英公布了新目标: “scalable foundation models”(可扩展基础模型)。 这类厂商可被视为Cha 继续阅读

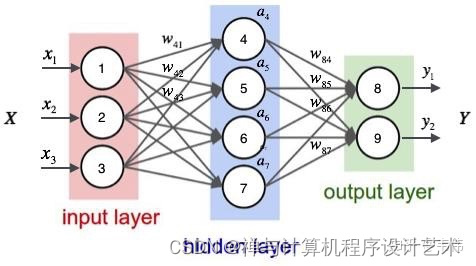

深入解析神经网络(Neural Networks)工作原理

目录 1. 神经网络的基本组成部分2. 神经元和激活函数3. 前向传播4. 反向传播5. 神经网络的层次结构6. 神经网络的应用7. 使用Python和TensorFlow库实现简单神经网络 神经网络(Neural Networks)是一种受到生物神经系统启发的人工智能模型,它在计算机科学和机器学习领域发挥着重要的作用。本文将深入解析神经网络的原理和工作原理,包括神经元、前向传播、反向传播以及网络层次结构的构建。 1. 继续阅读

OSI模型的传输层、会话层、表示层和应用层

根据之前对计算机网络OSI参考模型的学习,我们知道网络体系结构有7层,前期已经学习了网络的第一、二和三层,为了对网络模型有个整体的认知,同样需要了解网络的传输层、会话层、表示层和应用层。 一、传输层(Transport Layer) 传输层在网络体系结构的第四层,是整个网络的关键部分,它是实现两个用户进程间端到端的可靠通信,处理数据包的错误,数据包的次序& 继续阅读

ChatGPT实现的技术原理有哪些?

ChatGPT实现的技术原理 作为一种大型语言模型,ChatGPT的技术原理主要基于人工神经网络和自然语言处理技术。 ChatGPT使用了前馈神经网络(feedforward neural network)和递归神经网络(recurrent neural network)的结合来构建深度神经网络模型。这个模型包括多个隐藏层,每个隐藏层都包含多个神经元。 ChatGPT的训练数据主要来自于海量的互联网文本&# 继续阅读

ChatGPT模型中的惩罚机制

ChatGPT模型中的惩罚机制 上一篇文章《ChatGPT模型采样算法详解》为大家详细介绍了对文本生成效果至关重要的的2种采样方法,以及他们的控制参数temperature和top_p的作用。ChatGPT中,除了采样,还有惩罚机制也能控制文本生成的多样性和创意性。本文将详细为大家讲解ChatGPT种的两种惩罚机制,以及对应的frequency_penalty 和presence_penalty 参数。 文章目录概要frequenc 继续阅读

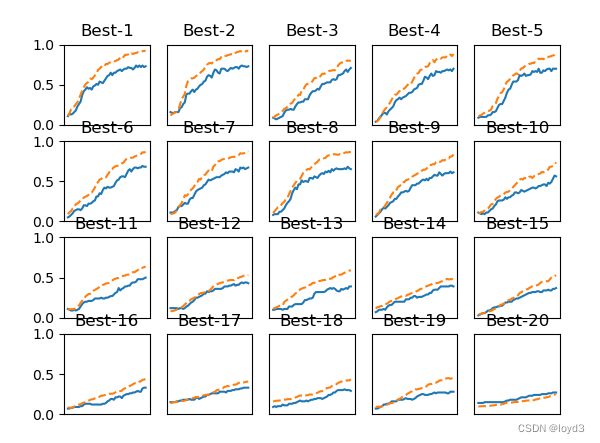

【深度学习】5-5 与学习相关的技巧 - 超参数的验证

超参数指的是,比如各层的神经元数量、batch大小、参数更新时的学习率或权值衰减等。如果这些超参数没有设置合适的值,模型的性能就会很差。 那么如何能够高效地寻找超参数的值的方法 验证数据 之前我们使用的数据集分成了训练数据和测试数据,训练数据用于学习测试数据用于评估泛化能力。 下面要对超参数设置各种各样的值以进行验证。这里要注意的是不能使用测试数据评估超参数的性能。这一点非常重要,但也容易被忽视。为什么不能使用测试数据评估超参数的性能&# 继续阅读

字符设备驱动内部实现原理解析及分步注册流程和代码实例

一、字符设备驱动内部实现原理 用户层调用open函数时,内核层的sys_open()会根据用户层传递的文件路径参数找到该文件的文件信息结构体struct inode{},这个文件信息结构体存放的是该文件的相关信息,里面有一个成员是字符设备驱动结构体struct cdev{},这个字符设备驱动结构体struct cdev{}里面有一个操作方法结构体指针struct file_openations,基于这个操作方法结构体指针s 继续阅读

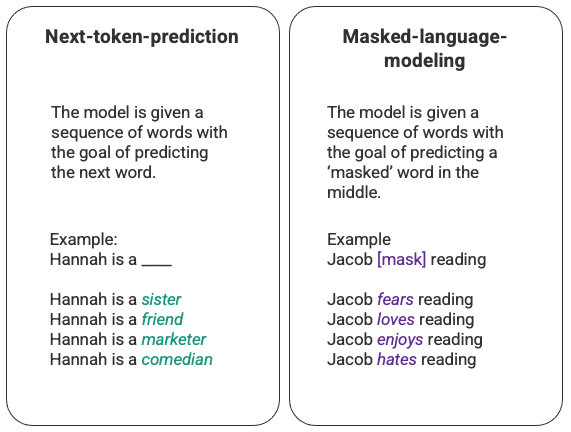

ChatGPT 的工作原理:机器人背后的模型

这篇对支持 ChatGPT 的机器学习模型的温和介绍,将从大型语言模型的介绍开始,深入探讨使 GPT-3 得到训练的革命性自我注意机制,然后深入研究人类反馈的强化学习,使 ChatGPT 与众不同的新技术。 大型语言模型 ChatGPT 是一类被称为大型语言模型 (LLM) 的机器学习自然语言处理模型的外推。LLM 消化大量文本数据并推断文本中单词之间的关系。随着我们看到计算能力的进步,这些模型在过去几年中得到了发展。随 继续阅读

GPT-4震撼发布:多模态大模型,直接升级ChatGPT、必应,开放API,游戏终结的时代到来了?

ChatGPT 点燃了科技行业的明灯,GPT-4 能燎原吗? 谁能革得了 ChatGPT 的命?现在看来还是 OpenAI 自己。 人们一直在探讨AI下一步的发展方向是什么,特别是在ChatGPT引爆科技领域之后。许多学者认为,多模态技术将成为未来AI发展的重要方向。不出所料,在等待的时间不会太久。今天凌晨,OpenAI宣布发布了多模态预训练大模型GPT-4。这一消息对于AI领域来说具有重大的意 继续阅读

scratch lenet(7): C语言计算可学习参数数量和连接数量

scratch lenet(7): C语言计算可学习参数数量和连接数量 1. 目的 按照 LeNet-5 对应的原版论文 LeCun-98.pdf 的网络结构,算出符合原文数据的“网络每层可学习参数数量、连接数量”。 网络上很多人的 LeNet-5 实现仅仅是 “copy” 现有的别人的项目, 缺乏“根据论文手动实现”的“复现”精神。严格对齐到论文结果,对于 LeNet-5 这样的经典论文, 是可以做到的。 具体实现使用 C 语言& 继续阅读

什么是循环神经网络模型?

引言 随着人工智能技术的不断发展,越来越多的应用需要使用深度学习模型来解决。然而,传统的深度学习模型在处理一些复杂的问题时,往往会出现过拟合的情况,导致模型的性能下降。为了解决这个问题,循环神经网络模型应运而生。本文将介绍循环神经网络模型的基本原理、训练方法、应用场景以及优化策略。 一、循环神经网络模型的基本原理 神经网络模型是一种模拟人类神经系统的机器学习模型,可以用于解决各种问题,例如图像识别、自然语言处理、语音识别、推荐系统等等。神经网络模型由多个神经元组成,每个神经 继续阅读