机器学习的问题中,过拟合是一个很常见的问题。过拟合指的是只能拟合训练数据,但不能很好地拟合不包含在训练数据中的其他数据的状态。机器学习的目标是提高泛化能力,即便是没有包含在训练数据里的未观测数据也希望模型可以进行正确的识别。 发生过拟合的原因,主要有以下两个: 模型拥有大量参数、表现力强。训练数据少。 那么如何来抑制过拟合 正则化是有效方法之一,它不仅可以有效降低高方差,还有利于降低偏差。何为 继续阅读

Search Results for: 拟合SIR模型参数的实用指南

查询到最新的12条

训练ChatGPT的必备资源:语料、模型和代码库完全指南

前言近期,ChatGPT成为了全网热议的话题。ChatGPT是一种基于大规模语言模型技术(LLM, large language model)实现的人机对话工具。但是,如果我们想要训练自己的大规模语言模型,有哪些公开的资源可以提供帮助呢?在这个github项目中,人民大学的老师同学们从模型参数(Checkpoints)、语料和代码库三个方面,为 继续阅读

Azure OpenAI 官方指南04|Codex的模型结构和应用场景

Codex 是 OpenAI 公司推出的 GPT-3(Generative Pre-trained Transformer – 3)的多个派生模型之一。它是基于GPT语言模型,使用代码数据进行 Fine-Tune(微调)而训练出的专门用于代码生成/文档生成的模型。Codex 模型参数从12M到12B不等,是目前最强的编程语言预训练模型。Codex 能够帮助程序员根据函数名和注释自动补全代码、直接生成代码、自动 继续阅读

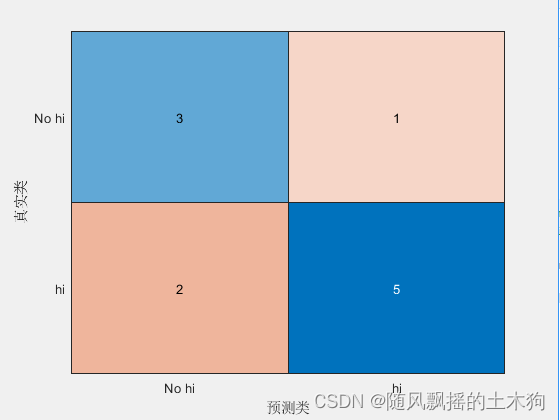

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的

【MATLAB第42期】基于MATLAB的贝叶斯优化决策树分类算法与网格搜索、随机搜索对比,含对机器学习模型的评估度量介绍 网格搜索、随机搜索和贝叶斯优化是寻找机器学习模型参数最佳组合、交叉验证每个参数并确定哪一个参数具有最佳性能的常用方法。 一、 评估指标 1、分类 1.1 准确性 1.2 精度 1.3 召回 1.4 F1值 1.5 F0.5值 1.6 F2值 1.7 计算评估指标的功能 2、回归 2.1 平均绝对误差 2.2 均方误差 2.3 均方根误差 二、 基于F1值执 继续阅读

ChatGPT模型中的惩罚机制

ChatGPT模型中的惩罚机制 上一篇文章《ChatGPT模型采样算法详解》为大家详细介绍了对文本生成效果至关重要的的2种采样方法,以及他们的控制参数temperature和top_p的作用。ChatGPT中,除了采样,还有惩罚机制也能控制文本生成的多样性和创意性。本文将详细为大家讲解ChatGPT种的两种惩罚机制,以及对应的frequency_penalty 和presence_penalty 参数。 文章目录概要frequenc 继续阅读

Abaqus CAE 2018插件使用详解:基于周期性边界条件定义3D几何模型的实践指南**

一、 引言 在进行无限或半无限域建模时,周期性边界条件可为我们提供了一种模拟其晶胞的有效方法。然而,如何在Abaqus中添加这些条件呢?不用担心,今天我将引领大家一同探索Abaqus CAE 2018的插件,通过在每个节点间应用相关约束,我们将会轻松地在Abaqus模型中添加两个曲面间的周期性边界条件。本文将会详细地介绍此插件的使用方法,以便帮助大家更有效率地利用它进行建模。 完整项目下载 继续阅读

【自然语言处理】【大模型】Chinchilla:训练计算利用率最优的大语言模型

Chinchilla:训练计算利用率最优的大语言模型 《Training Compute-Optimal Large Language Models》 论文地址:https://arxiv.org/pdf/2203.15556.pdf 一、简介 近期出现了一些列的大语言模型(Large Language Models, LLM),最大的稠密语言模型已经超过了500B的参数。这些大的自回归transformers已经在各个任务上展现 继续阅读

二次函数数据拟合模型示例

本文将从数据拟合的理论和应用角度出发,介绍二次函数数据拟合模型的相关知识和实际案例,并给出完整的代码示例,帮助读者更好地掌握二次函数拟合的方法和技巧。 一、基本概念 在数据分析和建模中,经常会遇到需要拟合一个函数曲线到已有数据点的情况。而二次函数是一种常见的、能够较好地拟合一些非线性数据的函数形式。 二次函数一般的形式为:$y=ax^2+bx+c$,其中 $a$、$b$、$c$ 分别是二次函数的系数,$x$ 为自变量,$y$ 为因变量。在二次函数中,$a$ 的 继续阅读

利用 recovery 给 HTC Desire 的SD卡分区

SD卡分区方法:(手机中已经装有RECOVERY软件和取得root权限,才能进行操作),本文仅适用HTC Desire,其它手机可以参数,但不能完全照搬。 1、 备份SD卡上资料到电脑中,特别是联系人资料! 2、 已取得root权限的手机进入RECOVERY(按住手机电源键+音量下键,出现界面后再用音量下键让光标停在“recovery"上,然后按一下电源键,机子一抖后进入软件界面),之后用手机光学杆控制光标到"Partition Sdcard"选项,并按下光学杆。 3、 手机中SD 继续阅读

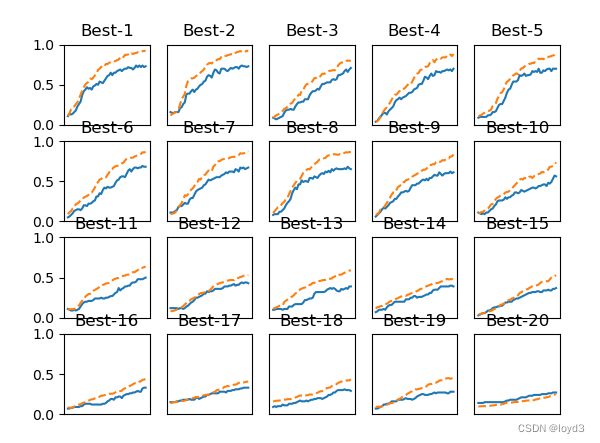

【深度学习】5-5 与学习相关的技巧 - 超参数的验证

超参数指的是,比如各层的神经元数量、batch大小、参数更新时的学习率或权值衰减等。如果这些超参数没有设置合适的值,模型的性能就会很差。 那么如何能够高效地寻找超参数的值的方法 验证数据 之前我们使用的数据集分成了训练数据和测试数据,训练数据用于学习测试数据用于评估泛化能力。 下面要对超参数设置各种各样的值以进行验证。这里要注意的是不能使用测试数据评估超参数的性能。这一点非常重要,但也容易被忽视。为什么不能使用测试数据评估超参数的性能&# 继续阅读

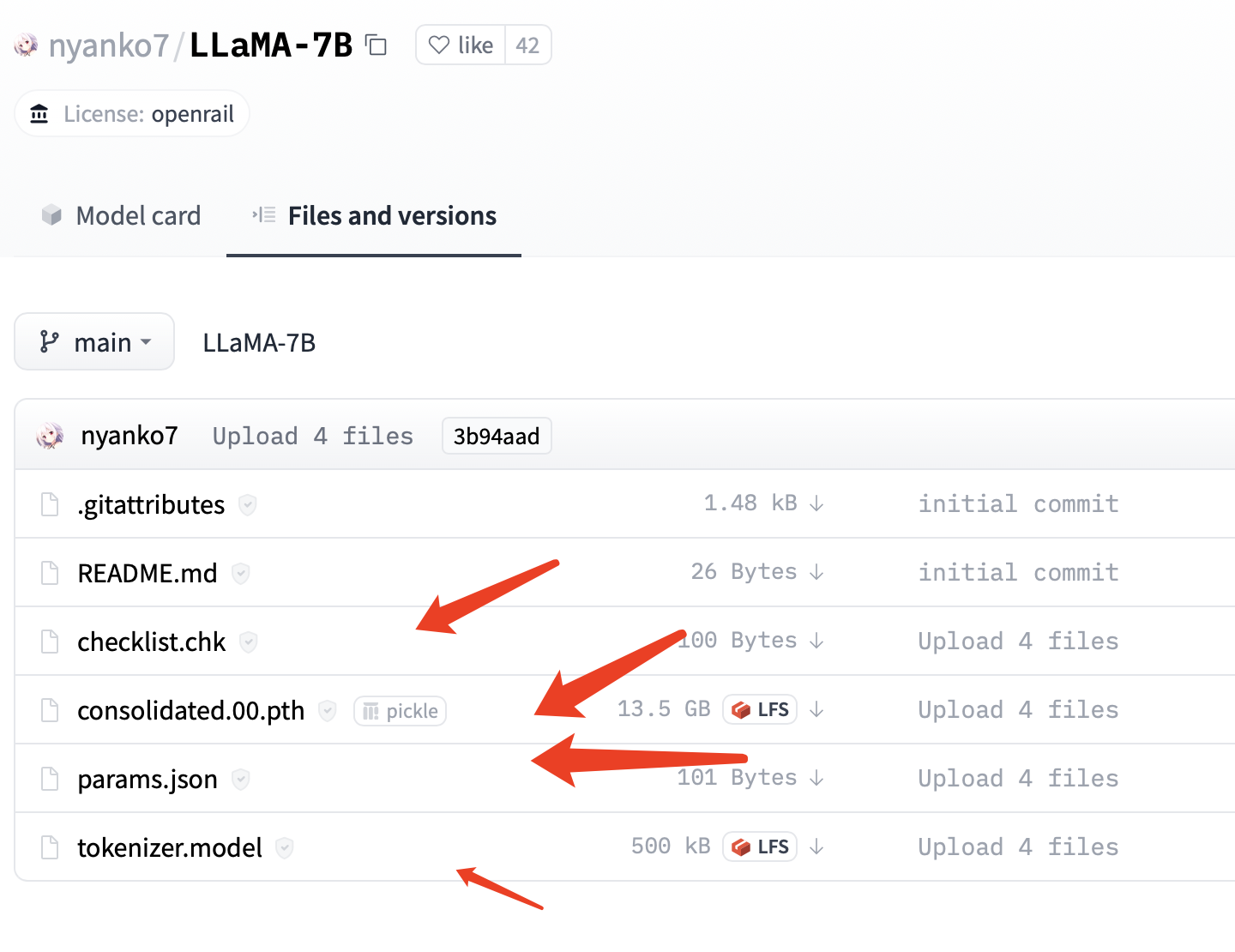

本地推理,单机运行,MacM1芯片系统基于大语言模型C++版本LLaMA部署“本地版”的ChatGPT

OpenAI公司基于GPT模型的ChatGPT风光无两,眼看它起朱楼,眼看它宴宾客,FaceBook终于坐不住了,发布了同样基于LLM的人工智能大语言模型LLaMA,号称包含70亿、130亿、330亿和650亿这4种参数规模的模型,参数是指神经网络中的权重和偏置等可调整的变量,用于训练和优化神经网络的性能,70亿意味着神经网络中有70亿个参数,由此类推。 在一些大型神经 继续阅读

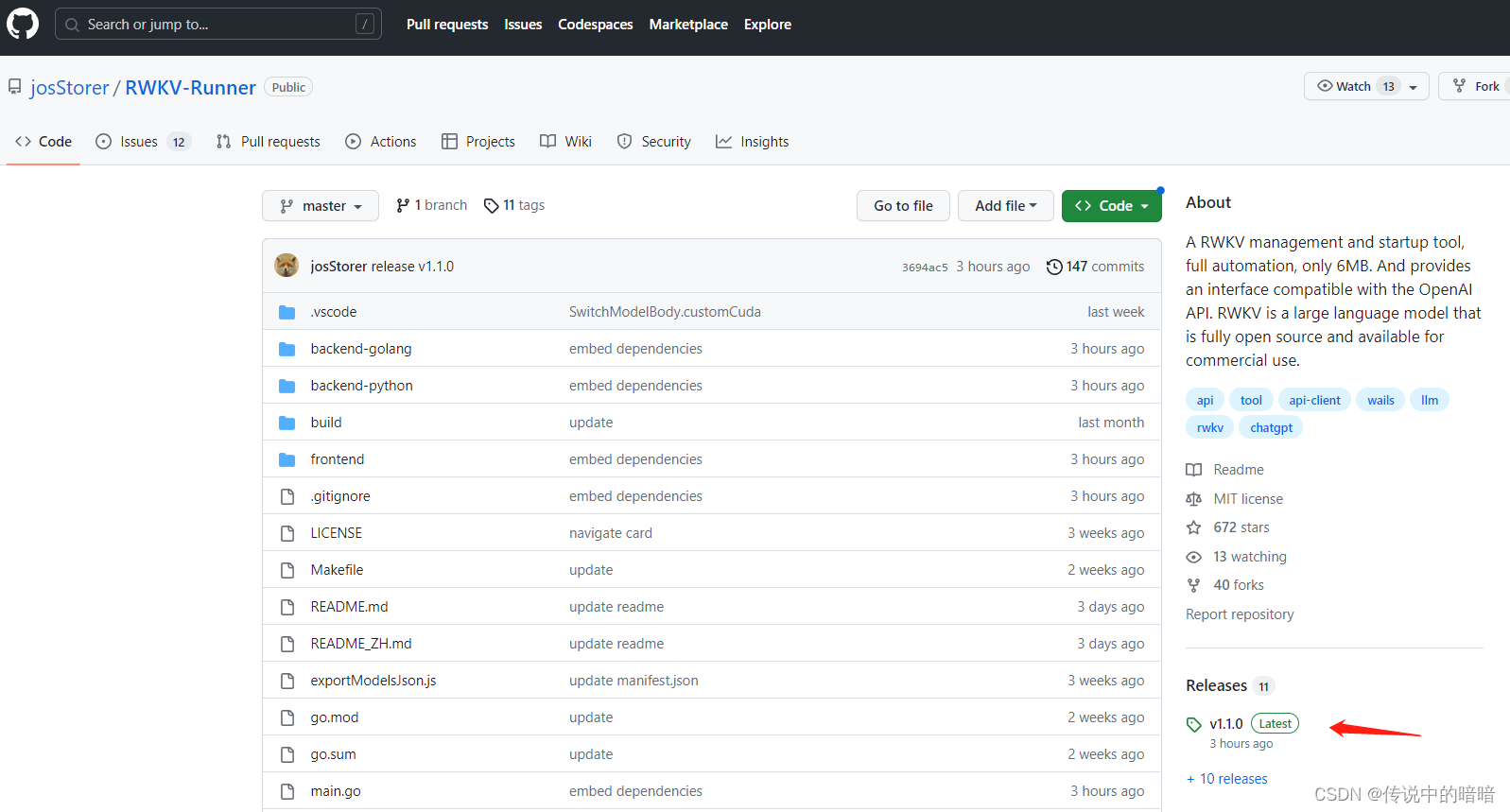

本地化部署AI语言模型RWKV指南,ChatGPT顿时感觉不香了。

之前由于ChatGpt处处受限,又没法注册的同学们有福了,我们可以在自己电脑上本地化部署一套AI语言模型,且对于电脑配置要求也不是非常高,对它就是RWKV。 关于RWKV RWKV是一个开源且允许商用的大语言模型,灵活性很高且极具发展潜力,它是一种纯 RNN 的架构,能够进行语言建模,目前最大参数规模已经做到了 14B,该模型训练由Stability赞助。本文发布时R 继续阅读