进NLP群—>加入NLP交流群

一句话总结

在NLP的7个代表性任务中的20个流行数据集上系统性的分析ChatGPT的zero-shot学习能力,最终得出ChatGPT在许多有利于推理能力的任务上表现良好(例如,算术推理),而在解决序列标注等特定任务时仍然有待提高。

摘要

在参数规模进步的推动下,大型语言模型 (LLM) 已经证明能够执行各种自然语言处理 (NLP) 零样本任务,即无需对下游数据进行调整。

最近,ChatGPT的首次亮相引起了自然语言处理 (NLP) 社区的极大关注,因为它可以对人类输入产生高质量的响应,并根据后续对话自我纠正先前的错误。

然而,尚不清楚 ChatGPT 是否可以作为一个通才模型,可以零样本地执行许多 NLP 任务。

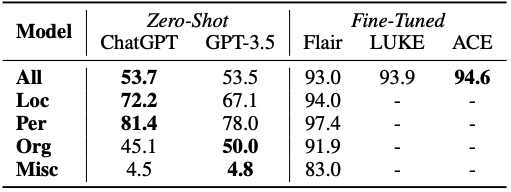

在这项工作中,我们通过在涵盖 7 个代表性任务类别的 20 个流行 NLP 数据集上对其进行评估,对 ChatGPT 的零样本学习能力进行了实证分析。

通过广泛的实证研究,我们证明了当前版本的 ChatGPT 的有效性和局限性。

我们发现 ChatGPT 在许多有利于推理能力的任务(例如,算术推理)上表现良好,但在解决序列标记等特定任务时仍然面临挑战。

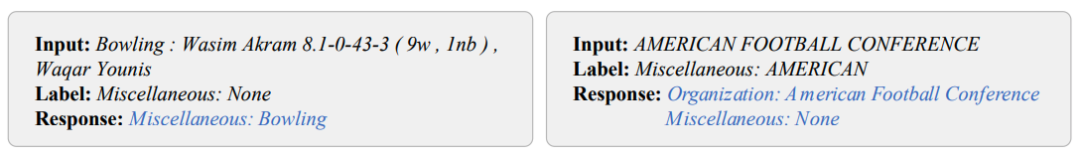

我们还通过定性案例研究提供深入分析。

实验与分析

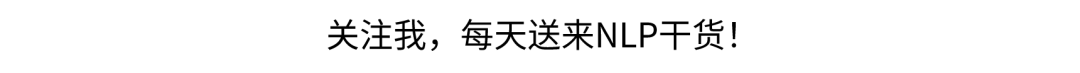

七大任务的输入格式:

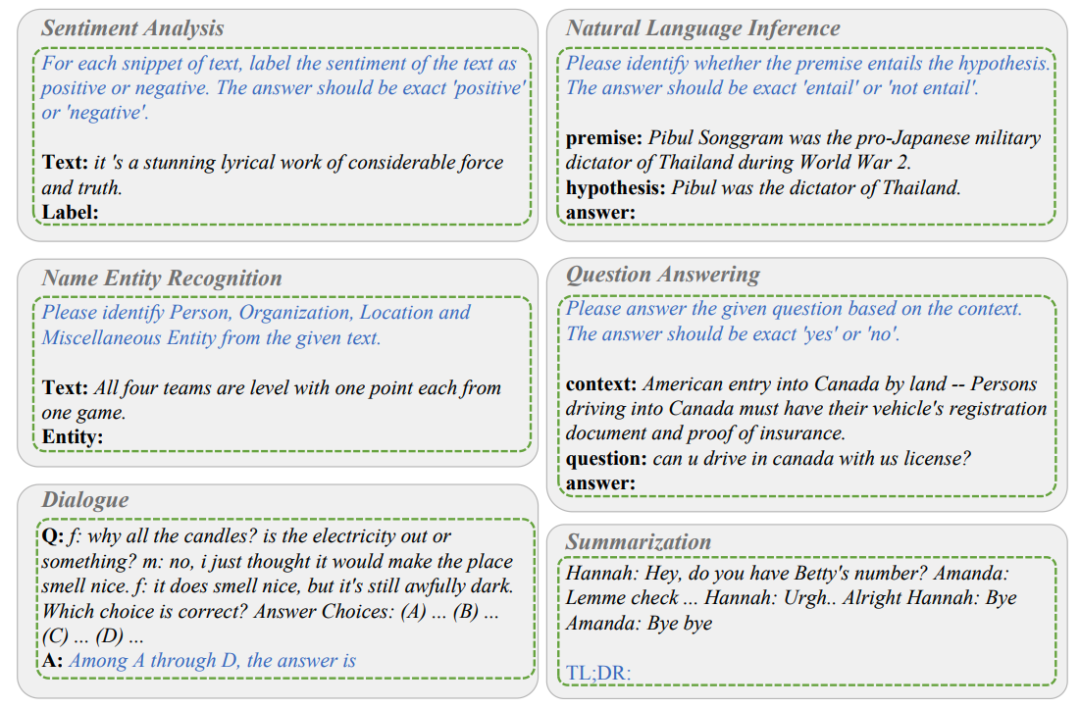

主要发现和见解总结如下:

尽管 ChatGPT 作为可以执行多项任务的通才模型显示出一定的能力,但它的性能通常比针对给定任务进行微调的模型差。

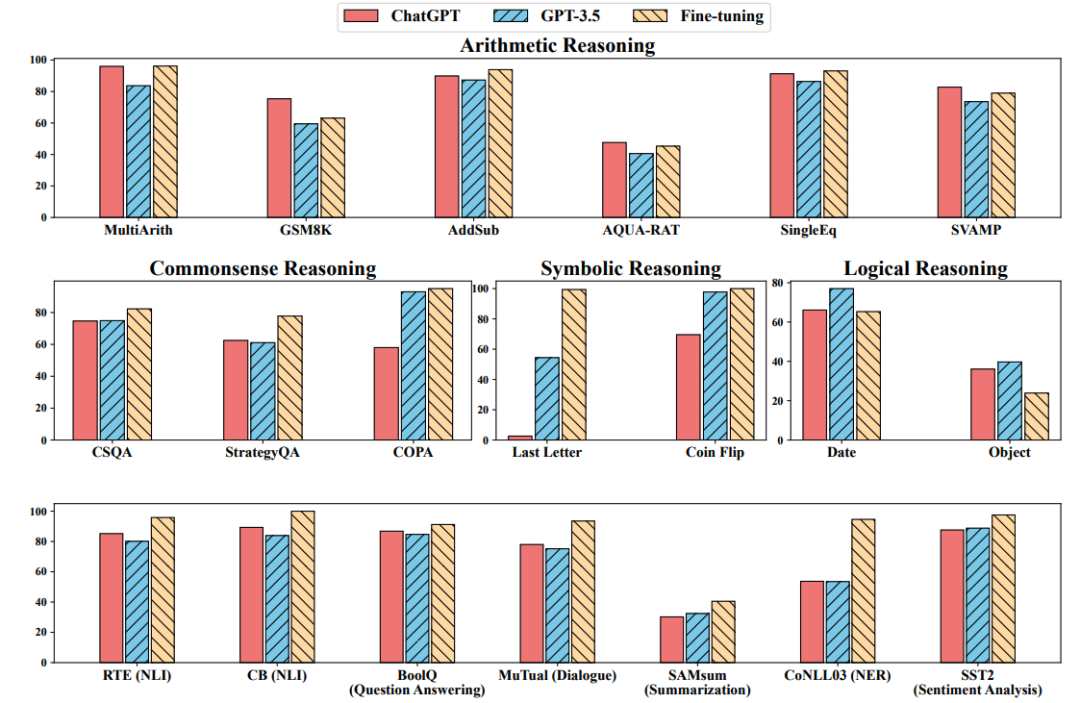

ChatGPT 的卓越推理能力在算术推理任务中得到了经验证实。然而,ChatGPT 在常识、符号和逻辑推理任务中的表现通常不如 GPT-3.5,例如通过生成不确定的响应。

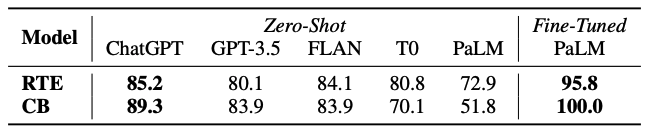

ChatGPT 在支持推理能力的自然语言推理任务和问答(阅读理解)任务方面优于 GPT-3.5,例如确定文本对中的逻辑关系。具体来说,ChatGPT 更擅长处理与事实一致的文本(即,更擅长对蕴含而不是非蕴含进行分类)。

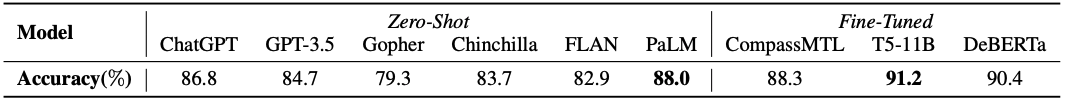

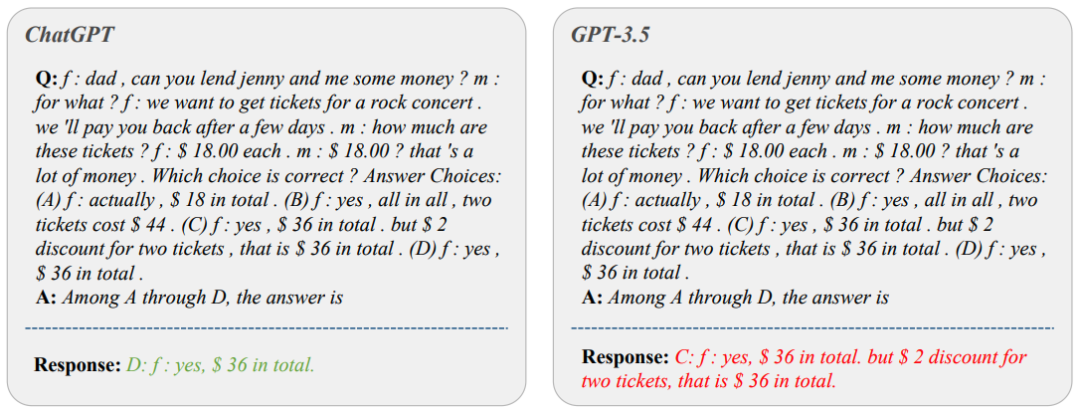

ChatGPT 在对话任务方面优于 GPT-3.5。

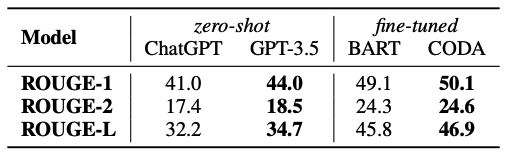

ChatGPT 生成更长的摘要,并且在摘要任务方面比 GPT-3.5 表现更差。然而,在零镜头指令中明确限制摘要长度会损害摘要质量,从而导致更差的性能。

尽管显示出作为通才模型的前景,但 ChatGPT 和 GPT-3.5 在某些任务上都面临挑战,例如序列标记。

ChatGPT 的情感分析能力接近 GPT-3.5。

结论

我们根据经验研究了 ChatGPT 在涵盖代表性任务类别的大量多样化数据集上的零样本学习能力。

广泛的实验结果和分析证明了 ChatGPT 在不同类型的 NLP 任务中的有效性和当前的局限性。

例如,作为一个强大的通才模型,ChatGPT 一方面擅长推理和对话任务;另一方面,ChatGPT 在解决序列标注等特定任务时仍面临挑战。

我们希望这项研究能够启发未来的工作,例如在 NLP 任务中利用 ChatGPT 的推理和对话功能,以及解决通才模型在他们目前遇到的任务中的局限性。

进NLP群—>加入NLP交流群

本文链接:https://my.lmcjl.com/post/10053.html

4 评论